人工知能(AI)と自然言語処理(NLP)の分野で革新をもたらした「Transformer」。その基本から最新技術、そして今後の展望まで、本記事では徹底解説していきます。

Transformerとは?その基本と概要

Transformerは、2017年にGoogleが発表した自然言語処理(NLP)のモデルであり、従来のリカレントニューラルネットワーク(RNN)や長短期記憶ネットワーク(LSTM)を超える性能を持っています。このモデルの革新点は、Attentionメカニズムを利用することで、シーケンス全体を一度に処理できる点です。

従来のモデルでは、入力データが順次処理されるため、長い文脈を扱うのが困難でした。しかし、Transformerでは、全ての単語が一度に処理され、文脈全体の依存関係を効率的に捉えることができます。これにより、長い文章や複雑な文脈の理解が飛躍的に向上しました。

Transformerのアーキテクチャは、エンコーダとデコーダから構成されます。エンコーダは入力文を内部表現に変換し、デコーダはその内部表現から出力文を生成します。エンコーダとデコーダの両方において、自己注意(Self-Attention)機構が重要な役割を果たします。

自己注意機構では、各単語が他の全ての単語に対する重要度を計算します。これにより、重要な単語やフレーズを強調しながら、全体の意味を把握することができます。このプロセスは並列処理が可能であり、従来のシーケンス処理モデルよりも高速で効率的です。

また、Transformerはマルチヘッド注意機構を採用しています。これにより、異なる文脈情報を同時に学習し、多様な視点から文脈を理解することができます。これが、Transformerが幅広いNLPタスクで優れた性能を発揮する理由の一つです。

このように、Transformerはその革新的なアーキテクチャにより、自然言語処理の分野で新たなスタンダードを確立しました。次のセクションでは、Transformerの進化と具体的なモデルについて詳しく見ていきます。

Transformerの進化:BERTやGPTの登場

Transformerの登場以降、その基本アーキテクチャを基にした様々なモデルが開発されてきました。その中でも特に注目すべきは、BERTとGPTです。これらのモデルは、それぞれ異なるタスクで優れた性能を示し、自然言語処理の可能性を大きく広げました。

BERT(Bidirectional Encoder Representations from Transformers)は、Googleが開発したモデルで、双方向の文脈を考慮する点が特徴です。従来のモデルは、文の左から右、または右から左の一方向でしか文脈を捉えられませんでしたが、BERTは両方向からの情報を同時に処理します。

この双方向の情報処理により、文全体の意味をより正確に理解することができます。BERTは、事前学習とファインチューニングという二段階の学習プロセスを経て、高度なNLPタスクに対応します。事前学習では、大量のテキストデータから一般的な言語パターンを学習し、ファインチューニングでは特定のタスクに特化した調整を行います。

一方、GPT(Generative Pre-trained Transformer)は、OpenAIが開発した生成モデルです。GPTは、大規模なテキストデータセットで事前学習を行い、新しいテキストを生成する能力に優れています。特に、GPT-2やGPT-3といった進化版は、その生成能力の高さで広く知られています。

GPTの特徴は、テキスト生成において一方向の文脈を利用する点です。具体的には、与えられた前文に続くテキストを生成する形式で訓練されており、自然な文章の生成が可能です。これにより、対話システムや自動文章生成など、多岐にわたる応用が期待されています。

これらのモデルの登場により、自然言語処理の応用範囲は大きく広がりました。次のセクションでは、Transformerの課題とその解決策について詳しく見ていきます。

Transformerの課題:計算量とメモリ使用量の増加

Transformerモデルは、その革新的なアーキテクチャにより、自然言語処理(NLP)において飛躍的な性能向上を実現しました。しかし、計算量とメモリ使用量の増加という重大な課題も抱えています。これは特に長いシーケンスや大規模なデータセットを扱う場合に顕著です。

Transformerの計算量は、入力シーケンスの長さに対して二次関数的に増加します。具体的には、Attentionメカニズムにおける計算量が、入力シーケンスの長さの二乗に比例します。例えば、シーケンスが2倍になると、計算量は4倍になります。このため、長い文章や大量のデータを処理する際には、計算リソースが非常に多く必要となります。

さらに、メモリ使用量も問題です。Attentionメカニズムは、全ての入力単語のペアに対する重み付けを計算し、その結果を保持します。このため、シーケンスが長くなると、必要なメモリも急激に増加します。特に、大規模なNLPモデルでは、メモリ不足が深刻な問題となることがあります。

また、モデルの層が増えると、活性化関数の出力を保持するためのメモリも増加します。これは、トレーニング時にバックプロパゲーションを行う際に必要です。モデルが深くなるほど、保持するデータ量が増え、メモリ使用量がさらに増大します。

これらの課題により、Transformerの適用範囲が制限されることがあります。計算資源が豊富でない環境では、長いシーケンスの処理が困難であり、モデルのパフォーマンスが低下する可能性があります。また、リアルタイム処理やエッジデバイスでの利用も制限されます。次に、これらの課題に対する解決策として提案されている「Reformer」について詳しく見ていきます。

Reformer:Transformerの効率化モデル

Reformerは、Transformerの計算量とメモリ使用量の課題を克服するために開発された効率化モデルです。Googleの研究者たちによって提案されたReformerは、Transformerの構造を改良し、計算リソースの削減を実現しています。特に、長いシーケンスを効率的に処理することが可能です。

Reformerの主な特徴は、Local-Sensitive-Hashing(LSH)とReversible Residual Layersの二つの革新技術にあります。これらの技術により、Transformerの計算量を大幅に削減し、メモリ使用量も抑えることができます。

LSHは、自己注意(Self-Attention)機構の計算量を削減するための手法です。従来のAttentionメカニズムでは、全ての入力単語ペアに対する計算を行いますが、LSHでは、類似する単語をグループ化し、重要な部分にのみAttentionを集中させます。これにより、計算量が大幅に減少し、長いシーケンスでも効率的に処理できます。

もう一つの重要な技術が、Reversible Residual Layersです。この技術では、層ごとに出力を保持する必要がなくなります。通常のResidual Layersでは、各層の出力をバックプロパゲーションのためにメモリに保持しますが、Reversible Residual Layersでは、入力情報から出力を逆算できるため、メモリ使用量を大幅に削減できます。

Reformerのこれらの技術により、長いシーケンスを処理する際の計算リソースとメモリ使用量が劇的に改善されます。これにより、従来のTransformerでは困難だった長文処理や大規模データセットの解析が可能となり、幅広い応用が期待されます。

Local-Sensitive-Hashing (LSH)の詳細と利点

Local-Sensitive-Hashing(LSH)は、Reformerの効率化を支える重要な技術の一つです。この手法は、自己注意(Self-Attention)機構における計算量を削減するために開発されました。LSHは、クエリとキーの内積計算を全て行わずに、効率的に重要なキーを抽出することを可能にします。

従来の自己注意機構では、入力シーケンス内の全ての単語ペアについて内積を計算し、その結果を基に注意の重みを決定します。しかし、これではシーケンスが長くなると計算量が急増し、リソースの消費が大きくなります。LSHは、この問題を解決するために、類似したキーを同じハッシュバケットに分類し、クエリと近いキーだけを抽出します。

LSHの具体的な動作は次の通りです。まず、ランダムな投影を用いて、入力ベクトルを低次元空間にマッピングします。次に、同じバケットに入るキーを抽出し、クエリとキーの内積を計算します。これにより、全てのペアに対する計算を行わずに、効率的に重要なキーを見つけ出すことができます。この方法により、計算量が劇的に削減され、長いシーケンスでも高速に処理可能です。

また、LSHは並列処理が可能であり、大規模なデータセットにも対応できます。ランダムプロジェクションによる低次元マッピングは、計算負荷が低く、ハッシュバケット内の計算も独立して行えるため、高い並列性を持ちます。この特性により、計算資源の効率的な利用が可能となり、応答時間の短縮に寄与します。

さらに、LSHはメモリ使用量の削減にも貢献します。全ての単語ペアについて内積計算を行わないため、メモリへの負荷が軽減されます。特に、長いシーケンスを扱う場合や大規模なNLPモデルでは、この効果が顕著です。

LSHの導入により、Reformerは従来のTransformerよりも効率的かつスケーラブルなモデルとなり、様々な応用分野での活用が期待されます。次に、もう一つの重要な技術であるReversible Residual Layersについて詳しく見ていきます。

Reversible Residual Layersの仕組み

Reversible Residual Layersは、Reformerの効率化を実現するためのもう一つの重要な技術です。この手法は、層ごとに出力を保持する必要がなく、計算の効率化とメモリ使用量の削減を実現します。特に、深層学習モデルにおいて大きな効果を発揮します。

通常のResidual Layersでは、各層の出力をバックプロパゲーションのためにメモリに保持する必要があります。しかし、Reversible Residual Layersでは、各層の出力を再計算できるため、メモリに保持する必要がありません。これにより、モデルの深さが増してもメモリ使用量を抑えることができます。

Reversible Residual Layersの基本的な動作原理は、入力を二つの部分に分割し、それぞれに異なる変換を適用することです。具体的には、入力XをX1とX2に分け、次のように計算します:

- Y1 = X1 + F(X2)

- Y2 = X2 + G(X1)

この計算は、後の段階で逆にすることが可能です。すなわち、出力Yから入力Xを再構築できます。これにより、出力を保持せずに、逆伝播の際に必要な情報を効率的に再計算することができます。

このアプローチにより、Reformerは非常に効率的なメモリ使用を実現します。特に、大規模なモデルや長いシーケンスを扱う場合において、メモリの節約効果が顕著です。また、計算コストも削減されるため、モデルのトレーニングと推論の両方で効率が向上します。

さらに、Reversible Residual Layersは、計算の安定性と精度も向上させます。入力情報を直接保存せずに再構築するため、数値誤差の影響を抑えつつ、高精度な計算を維持できます。これにより、モデルの性能が向上し、安定した学習が可能になります。

このように、Reversible Residual Layersは、Reformerの効率化と性能向上に大きく寄与する重要な技術です。次に、Reformerがどのようにして具体的な応用分野で効果を発揮しているのか、詳しく見ていきましょう。

Abacusエンベディング:算術能力を向上させる新手法

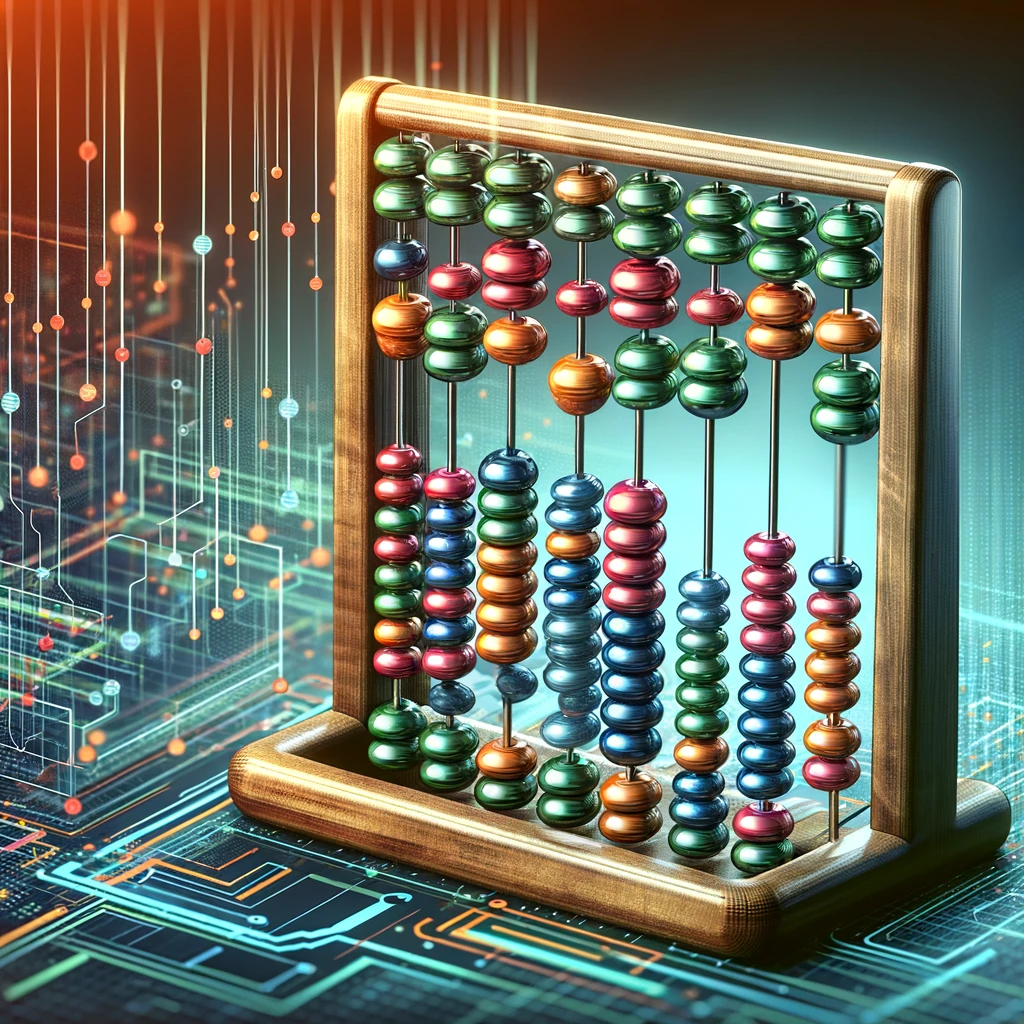

Abacusエンベディングは、Transformerモデルの算術タスクにおける性能を飛躍的に向上させる新しい位置エンベディング手法です。この手法は、数字の位置情報を明示的にエンコードすることで、モデルが長い数字列に対しても高い精度で一般化できるように設計されています。

Transformerモデルは、自然言語処理(NLP)において非常に高い性能を発揮しますが、算術タスクにおいては、数字の正確な位置情報を追跡することが苦手でした。Abacusエンベディングは、この問題を解決するために開発されました。具体的には、数字列中の各数字の位置をエンコードし、モデルがその位置情報を利用して計算を行うことを可能にします。

この新手法により、Transformerは長い数字列に対しても高い精度で一般化することができます。例えば、学習時に使用した数字列の長さの6倍の長さを持つ数字列に対しても、95%以上の正解率を達成しています。これは、Transformerモデルが学習時に見たことのない長さの数字列に対しても、正確に処理できることを示しています。

また、Abacusエンベディングは、再帰的レイヤーとの組み合わせによってさらに効果を発揮します。再帰的レイヤーを持つLooped Transformerアーキテクチャを導入することで、モデルは数字列の処理をより効率的に行うことができます。実験の結果、再帰的レイヤーを導入することで、Abacusエンベディングを用いたTransformerモデルの性能がさらに向上しました。

この手法は、加算タスクだけでなく、乗算やソートといった他の算術・アルゴリズミックタスクにも有効です。実験では、Abacusエンベディングを用いることで、学習時よりも長い数字列や配列に対しても高い精度で一般化できることが確認されています。これにより、Abacusエンベディングは幅広い算術タスクに応用可能な汎用性の高い手法であることが示されています。

このように、Abacusエンベディングは、Transformerモデルの算術タスクにおける性能を大幅に向上させる新手法として注目されています。次に、再帰的レイヤーとの組み合わせによる性能向上について詳しく見ていきます。

再帰的レイヤーとの組み合わせによる性能向上

再帰的レイヤーとの組み合わせは、Abacusエンベディングの効果をさらに引き出すために重要な技術です。この組み合わせにより、Transformerモデルは数字列の処理をより効率的に行うことができます。再帰的レイヤーを導入することで、モデルは複雑な計算を段階的に処理し、性能を大幅に向上させます。

再帰的レイヤー(Recurrent Layer)は、入力データを時間的に依存するシーケンスとして処理するためのレイヤーです。このレイヤーは、過去の情報を保持しながら新しい情報を追加し、次のステップで使用します。これにより、長いシーケンスや複雑なデータの処理が可能となります。

Abacusエンベディングと再帰的レイヤーを組み合わせることで、モデルは長い数字列や複雑な算術タスクに対しても高い精度で対応できます。実験結果によると、Looped TransformerアーキテクチャとAbacusエンベディングを組み合わせた場合、従来のモデルよりも高い精度と効率を実現しています。この組み合わせにより、長い数字列でも高速に処理でき、精度も向上します。

具体的な例として、加算タスクにおいて、再帰的レイヤーを用いることで、モデルは学習時に使用した数字列の長さを超える入力に対しても、高い精度を維持することが確認されています。また、乗算やソートといった他の算術タスクでも同様の効果が見られます。再帰的レイヤーは、各ステップでの計算を効率化し、メモリ使用量を抑えるため、長いシーケンスの処理が特に効果的です。

さらに、再帰的レイヤーは、Transformerモデルの柔軟性を高める役割も果たします。従来のTransformerは、固定長のシーケンスに対してのみ効果を発揮しましたが、再帰的レイヤーの導入により、変動する長さのシーケンスにも適応可能です。これにより、様々な現実世界のタスクに対しても柔軟に対応できます。

このように、再帰的レイヤーとAbacusエンベディングの組み合わせは、Transformerモデルの性能を飛躍的に向上させる重要な技術です。次に、具体的な応用事例を見ていくことで、これらの技術がどのように実践されているかを理解していきましょう。

実際の応用事例:自然言語処理から算術タスクまで

Transformerモデルは、その高度な自然言語処理(NLP)能力により、多岐にわたる応用分野で活躍しています。特に、翻訳、要約、感情分析、質問応答システムなど、テキストベースのタスクにおいて優れた性能を発揮します。

例えば、Google翻訳はTransformerモデルを基にしたニューラル機械翻訳(NMT)システムを採用しています。このシステムは、従来の統計モデルよりも高い精度で自然な翻訳を提供し、多言語対応の精度向上に貢献しています。これにより、ビジネス文書の翻訳や国際コミュニケーションが一層スムーズになります。

また、ニュース記事の自動要約でもTransformerが使用されています。大量の情報を短時間で要約する能力は、忙しいビジネスパーソンにとって非常に有用です。重要な情報を迅速に把握できるため、意思決定のスピードが向上します。

さらに、感情分析では、SNSやカスタマーレビューのテキストデータを解析し、ユーザーの感情や意見を自動的に分類します。これにより、マーケティング戦略の策定や製品改善のための洞察を得ることができます。顧客のフィードバックをリアルタイムで分析することで、迅速な対応が可能となります。

一方、算術タスクにおいても、Transformerモデルの応用が進んでいます。特に、Abacusエンベディングを用いることで、長い数字列の計算や複雑なアルゴリズムの処理が可能となりました。金融データの解析や科学計算など、計算量の多いタスクでも高い精度を維持します。

これらの応用事例は、Transformerモデルが単なるテキスト解析ツールではなく、多目的なAIツールとして機能することを示しています。次に、Transformerの効率化技術であるLongformerや他の革新技術について詳しく見ていきます。

他の効率化技術:Longformerや他の革新技術

Transformerモデルの効率化を図るために、様々な技術が開発されています。その中でも、Longformerは特に注目されています。Longformerは、長いシーケンスを効率的に処理するために設計されたモデルで、従来のTransformerの計算量の課題を克服します。

Longformerの主な特徴は、スライディングウィンドウの自己注意機構を採用している点です。この手法により、全ての単語間の関係を計算するのではなく、一定範囲内の単語にのみ注意を向けることができます。これにより、長い文書でも計算量が大幅に削減され、メモリ使用量も抑えられます。

また、Longformerは、グローバル注意機構も併用しています。スライディングウィンドウ内の重要な単語やフレーズに対しては、全体の文脈を考慮した注意を行うことで、長い文書でも高い精度を維持します。この組み合わせにより、効率性と精度の両立が可能となります。

他にも、Efficient Transformerと呼ばれるモデルが開発されています。このモデルは、Attention機構の計算量をさらに削減するために、さまざまな工夫を凝らしています。例えば、Linformerは、入力シーケンスの次元を低減することで、計算量を線形に抑える手法を採用しています。これにより、大規模なデータセットでも高速に処理できます。

さらに、Performerというモデルも注目されています。Performerは、ランダム特徴マッピングを用いることで、自己注意機構の計算量を大幅に削減します。この技術により、従来のTransformerの課題であった計算リソースの問題が解決され、より広範な応用が可能となります。

これらの技術は、Transformerモデルの効率化を進めることで、さまざまな分野での応用をさらに拡大しています。次に、これらの技術がどのように将来の展望と課題に対応していくのかを詳しく見ていきます。

未来の展望と課題:更なる発展に向けて

Transformerモデルとその効率化技術は、今後さらに進化していくことが期待されています。しかし、いくつかの課題も残されています。これらの課題に対処することで、さらに多くの応用分野での活用が可能となるでしょう。

一つ目の課題は、計算資源の最適化です。現在のTransformerモデルは、大規模な計算リソースを必要とします。特に、トレーニングや推論において、計算コストが高いため、効率的なアルゴリズムの開発が求められています。Efficient TransformerやPerformerのような技術が、この課題に対する解決策となり得ます。

次に、モデルの解釈性も重要な課題です。Transformerモデルは高度な性能を発揮しますが、その内部動作はブラックボックス的であり、結果の解釈が難しい場合があります。モデルの透明性を高め、ユーザーが結果を理解しやすくするための手法が必要です。

さらに、実世界での応用において、データのプライバシーとセキュリティも重要です。特に、個人情報を扱う場合には、データの保護が不可欠です。これには、フェデレーテッドラーニングや差分プライバシーといった技術が有効です。

最後に、モデルの公平性とバイアスの問題があります。AIモデルは、学習データのバイアスを引き継ぐことがあり、不公平な結果を生む可能性があります。この課題を克服するためには、データの選定とモデルのトレーニング方法において、公平性を考慮する必要があります。

これらの課題に対処することで、Transformerモデルはさらに多くの分野で革新をもたらすでしょう。今後の研究と技術開発により、より高度なAIモデルが登場し、私たちの生活やビジネスに新たな価値を提供することが期待されています。

まとめ:次世代AIモデルTransformerの総括

本記事では、次世代AIモデルであるTransformerについて、その基本から最新技術、応用事例、そして未来の展望までを詳しく解説しました。Transformerは、自己注意機構により長いシーケンスの効率的な処理を可能にし、NLPに革命をもたらしました。その進化形として、ReformerやLongformer、さらにAbacusエンベディングなどの技術が登場し、計算量とメモリ使用量の課題を克服しています。

これらの技術は、ビジネスシーンにおいても多大な効果を発揮しており、翻訳、要約、感情分析、算術タスクなど、多岐にわたる応用が進んでいます。今後も、Transformerの効率化技術と新しい応用事例の発展により、AIの可能性はさらに広がっていくことでしょう。