AIの進展とともに、ビジネスの現場では新たな倫理的課題が浮上しています。特に、デジタルエシックスの重要性は日に日に増しており、企業の競争力に直結する問題となっています。

デジタルエシックスとは、AIやデータの活用において倫理的な判断をどのように行うかという指針です。これにより、技術の公平性や透明性を確保することが求められます。

本記事では、最新の情報を基にAIとビジネスエシックスの関連性について深掘りし、具体的な事例やガイドラインを紹介します。これからのデジタル社会を理解し、倫理的に進化するためのヒントを提供します。

はじめに:AIとビジネスエシックスの必要性

AI技術が急速に進化し、ビジネスの現場でその活用が進む中、倫理的な問題がますます重要視されています。ビジネスエシックスは、企業が社会的責任を果たすための基盤であり、信頼性の高いAIシステムの構築に不可欠です。AIの利用が拡大する一方で、その影響力も大きくなり、適切な倫理ガイドラインの策定が求められています。

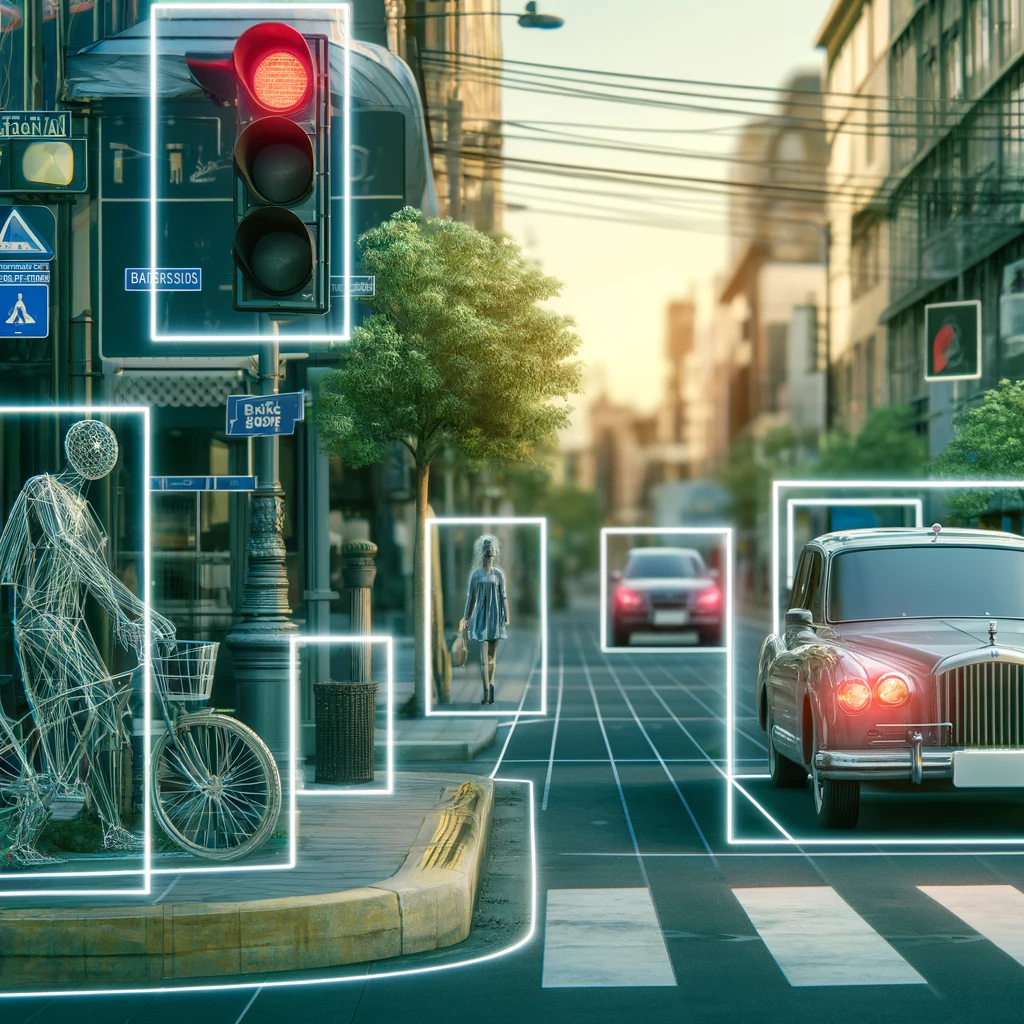

例えば、自動運転車の事故責任やAIによる差別的な判断の問題など、具体的な課題が浮き彫りになっています。企業はこれらの課題に対処するために、透明性、公平性、説明責任を持ったAI開発を行う必要があります。AIシステムがどのようにデータを処理し、決定を下すのかを明確にすることで、利用者や社会全体の信頼を得ることができます。

また、倫理的な判断を行うためには、AI技術者だけでなく、法務、経営、人事など多様な分野の専門家が協力し、総合的な視点から検討することが重要です。さらに、企業はAI倫理のガイドラインを社内外に公開し、透明性を確保することが求められます。これにより、ステークホルダーの理解と協力を得ることができ、持続可能なAI活用を実現することが可能です。

AIとビジネスエシックスの関連性を理解し、適切な対策を講じることで、企業は信頼性と競争力を高めることができます。

デジタルエシックスとは何か?

デジタルエシックスとは、AIやデジタル技術の利用における倫理的な問題を扱う概念です。これには、公平性、透明性、プライバシーの保護などが含まれます。例えば、AIが偏見や差別を助長しないようにするためには、学習データのバイアスを排除する必要があります。具体的には、AIが顔認識技術で特定の人種や性別に対して誤認識をしないように、データセットの多様性を確保することが重要です。

また、AIの判断がどのように行われているかを説明できる「説明可能なAI(Explainable AI)」の開発も進められています。これにより、利用者はAIの決定がどのように導かれたかを理解しやすくなり、信頼性が向上します。さらに、プライバシー保護も重要な要素です。個人データの収集と利用については、明確なポリシーを持ち、ユーザーの同意を得ることが必要です。

デジタルエシックスは、これらの問題を包括的に取り扱い、技術と倫理のバランスを取るためのガイドラインを提供します。企業はデジタルエシックスを導入することで、社会的責任を果たし、持続可能なビジネスモデルを構築することができます。例えば、NECや富士通などの大手企業は、AI倫理ガイドラインを策定し、実践しています。

これにより、AI技術の開発と利用において高い倫理基準を維持し、信頼性の高い製品とサービスを提供しています。デジタルエシックスは、企業の信頼性を高め、競争力を強化するための重要な要素です。

AI技術の進展と倫理的課題

AI技術の急速な進展は、ビジネスに多大な恩恵をもたらしていますが、同時に倫理的な課題も浮上しています。自動運転車や顔認識技術の普及に伴い、事故や誤認識による問題が発生するリスクが増大しています。特に、自動運転車の事故時の責任の所在は明確ではなく、メーカーやソフトウェア開発者、運転者の間で責任が曖昧になっています。また、顔認識技術では、特定の人種や性別に対する認識精度の差が問題視されており、これが差別を助長する可能性があります。

AIの判断がどのように行われるかがブラックボックス化しているため、その透明性も問われています。これにより、AIが導き出した結論に対する説明責任が果たせず、ユーザーの信頼を失うリスクが高まります。さらに、AIが大量の個人データを収集・解析する過程でプライバシーが侵害される可能性も高まっています。企業はこれらの倫理的課題に対処するために、透明性を確保し、公正で偏りのないデータを使用し、個人データの保護を徹底する必要があります。

例えば、GoogleやAmazonはAIの利用に関するガイドラインを策定し、倫理的なAI開発を推進しています。これにより、AI技術の進展と倫理的課題のバランスを取り、持続可能な技術利用を目指しています。企業がAI技術を活用する際には、これらの倫理的課題を認識し、適切な対策を講じることが求められます。AI技術の進展は避けられない現実であり、その利点を最大限に活かすためにも、倫理的な配慮が欠かせません。

企業におけるデジタルエシックスの実践例

企業がデジタルエシックスを実践することで、信頼性の高いAIシステムの構築と持続可能なビジネスモデルの実現が可能になります。例えば、NECは「AI品質ガイドライン」を策定し、AIシステムの開発プロセスにおける倫理的な配慮を徹底しています。このガイドラインは、AIの開発段階から運用までの各フェーズで倫理的なチェックを行い、バイアスのない公正なAIシステムを目指しています。

また、NTTデータは「AI倫理指針」を発表し、AIの開発と運用において透明性と説明可能性を重視しています。この指針は、AIの判断プロセスをユーザーに説明できるようにし、AIシステムの信頼性を高めることを目的としています。さらに、企業内外のステークホルダーとの対話を通じて、倫理的な問題に対する理解を深め、共同で解決策を模索しています。

IBMは「AI倫理原則」を掲げ、人間の知能を拡張するためのAI開発を推進しています。これにより、AIが人間の能力を補完し、社会全体にとって有益な技術となることを目指しています。また、AIの透明性を確保するための技術開発にも力を入れており、説明可能なAI(Explainable AI)の研究を進めています。

これらの企業の取り組みは、デジタルエシックスの実践が企業の競争力を高めることを示しています。企業がAI技術を活用する際には、倫理的な配慮を怠らず、透明性、公正性、プライバシー保護を徹底することが求められます。デジタルエシックスの実践は、企業の信頼性を向上させるだけでなく、持続可能な技術利用の基盤を築くことにも繋がります。

デンマークの事例から学ぶデジタルエシックス

デンマークはデジタルエシックスの分野で先進的な取り組みを行っている国の一つです。デジタルエシックスとは、AIやデータの利用における倫理的な問題を解決するためのガイドラインやポリシーを指します。デンマークの取り組みの特徴は、多様なステークホルダーとの対話を重視する点にあります。研究者、企業、政府、一般市民などが一堂に会し、技術の利用方法やその影響について議論を行っています。これにより、社会全体が共通認識を持ち、倫理的に適正な技術利用を推進しています。

例えば、デンマークデザインセンターが開発した「デジタルエシックスコンパス」は、デジタルプロダクトやサービスの設計において、倫理的な視点を考慮するためのツールです。このツールは、データの扱い、自動化の影響、ユーザーの行動に対する影響など、多岐にわたる質問を通じて、開発者が倫理的な問題に対処するためのガイドラインを提供します。デジタルエシックスコンパスは、デジタル分野での倫理的な判断を促し、社会にとって有益な技術の開発を支援します。

また、デンマーク政府は国民と企業が共同でデジタルエシックスを推進するためのプラットフォームを提供しています。このプラットフォームを通じて、最新の技術動向や倫理的な問題に関する情報共有が行われ、共通の理解を深めることができます。これにより、技術の利用がもたらすリスクを最小限に抑えつつ、持続可能な社会を実現するための施策が進められています。

デンマークの事例は、企業がデジタルエシックスを実践する上での有益な参考となります。企業は、ステークホルダーとの対話を通じて、技術の利用に伴うリスクを理解し、適切な対策を講じることが求められます。デンマークのように、共通の倫理ガイドラインを持つことで、企業は持続可能なビジネスモデルを構築し、社会全体の信頼を得ることができます。

日本におけるAI倫理の現状と課題

日本におけるAI倫理の取り組みは、近年ますます重要性を増しています。政府や企業がAI技術の進展に伴う倫理的な課題に対応するためのガイドラインを策定し、実践しています。例えば、内閣府が掲げる「人間中心のAI社会原則」は、人間の尊厳を尊重し、公正で持続可能な社会を目指すものです。この原則は、AIの開発と利用において、人間の権利やプライバシーを守ることを目的としています。

一方で、日本のAI倫理にはいくつかの課題も存在します。まず、技術の透明性と説明可能性が十分に確保されていないことが挙げられます。AIの判断プロセスがブラックボックス化しているため、その決定がどのように行われたかを説明することが難しい場合があります。これにより、ユーザーや社会全体の信頼を得ることが難しくなっています。また、データのバイアスや差別の問題も解決すべき課題です。AIが学習するデータに偏りがあると、結果として不公正な判断が下されるリスクがあります。

さらに、日本の企業はAI倫理を実践するための体制整備がまだ十分ではありません。多くの企業がAI倫理ガイドラインを策定していますが、それを実際に運用するための仕組みや教育が不足しています。企業がAI倫理を実践するためには、全社的な取り組みが必要であり、技術者だけでなく、経営層や法務部門なども積極的に関与することが求められます。

日本におけるAI倫理の取り組みを強化するためには、政府と企業の連携が不可欠です。政府は法整備やガイドラインの提供を通じて企業を支援し、企業はそのガイドラインを実践に移すことで、持続可能なAI技術の利用を推進することが求められます。日本のAI倫理の現状と課題を認識し、適切な対策を講じることで、信頼性の高いAI技術の普及が期待されます。

ブラックボックス問題とその解決策

ブラックボックス問題は、AIの意思決定プロセスが不透明であり、その結果を合理的に説明できないことを指します。これにより、AIの判断がなぜそのように下されたのかを理解することが難しく、信頼性や透明性が損なわれるリスクがあります。特に、金融業界や医療分野などでAIが重要な役割を果たす場合、この問題は深刻です。例えば、クレジットスコアリングや診断支援において、AIの決定がなぜそうなったのかを説明できなければ、利用者や規制当局の信頼を得ることが難しくなります。

解決策の一つとして、説明可能なAI(Explainable AI)の開発が進められています。これは、AIの判断プロセスを理解しやすくするための技術です。例えば、AIがどのデータを基にどのような判断を下したのかを視覚的に表示するツールが開発されています。これにより、ユーザーはAIの意思決定プロセスを追跡し、その判断の妥当性を確認することができます。さらに、AIの開発段階で透明性と説明可能性を確保するためのガイドラインも策定されています。

もう一つの解決策は、ホワイトボックスAIの導入です。ホワイトボックスAIは、意思決定プロセスが完全に透明であり、利用者がその判断を容易に理解できるAIシステムです。これにより、AIの判断がどのように行われたのかを明確に示すことができ、信頼性が向上します。特に、金融機関や医療機関では、このような透明性の高いAIシステムが求められています。

また、企業はAIの透明性を高めるために、内部監査や外部評価を積極的に行うことが重要です。これにより、AIの意思決定プロセスにおけるバイアスやエラーを早期に発見し、修正することができます。さらに、AIの開発者は、透明性と説明可能性を高めるための継続的な教育とトレーニングを受けることが求められます。

ブラックボックス問題を解決することで、AIの信頼性と透明性が向上し、利用者の安心感が増します。これにより、企業は持続可能なAI技術の利用を推進し、競争力を強化することが可能となります。

AIの差別・偏見問題にどう対処するか

AIの差別・偏見問題は、AIが学習するデータに偏りがある場合に発生します。これは、特定の人種や性別に対する差別的な結果を生むリスクがあります。例えば、顔認識技術において、特定の人種の認識精度が低い場合、その人種に対する差別が助長される可能性があります。アマゾンの採用AIが男性候補者を優遇するように学習してしまった例もあります。これらの問題は、AIの信頼性と公平性を損なう重大なリスクです。

この問題に対処するためには、まずデータのバイアスを排除することが重要です。AIが学習するデータセットは、多様な背景を持つデータで構成されるべきです。これにより、AIが公平な判断を下せるようになります。具体的には、データ収集の段階で意識的に多様なデータを集めることが求められます。また、データの偏りを検出し、それを修正するための技術も開発されています。

さらに、AIのアルゴリズム自体にもバイアスが組み込まれないようにすることが必要です。これは、AIの開発段階で倫理的なガイドラインを設定し、それに従ってアルゴリズムを設計することを意味します。例えば、GoogleやMicrosoftはAIの開発において、倫理的な配慮を徹底するガイドラインを策定しています。これにより、AIが偏見のない判断を下すことが期待されます。

また、AIの判断が差別的な結果を生まないように、定期的に監査を行うことも重要です。企業は、AIの運用中に発生する可能性のあるバイアスを監視し、それを修正するためのプロセスを確立する必要があります。これにより、AIの判断が常に公平であることを保証できます。企業は、AIの差別・偏見問題に対処するために、透明性と説明可能性を持ったシステムを構築し、定期的な監査と改善を行うことが求められます。

最後に、企業内での教育とトレーニングも重要です。AI開発者やデータサイエンティストは、バイアスとその影響について理解し、それを排除するための技術と方法を学ぶ必要があります。これにより、企業全体でバイアスのない公正なAIの開発と運用が可能となります。

プライバシーとデータの保護

AI技術の発展に伴い、プライバシーとデータ保護の重要性がますます高まっています。企業は顧客データを収集し、それをAIシステムで解析することでビジネスの効率化や新たな価値提供を実現していますが、同時にデータ漏洩や不正利用のリスクも増大しています。プライバシー侵害が発生すると、企業の信頼性が損なわれ、法的な問題にも発展する可能性があります。そのため、企業はデータ保護の強化に取り組むことが不可欠です。

まず、データの匿名化が重要な対策の一つです。個人を特定できる情報を取り除き、匿名データとして利用することで、プライバシーを保護しながらデータの価値を最大限に活用できます。さらに、データの暗号化も有効な手段です。通信や保管の際にデータを暗号化することで、外部からの不正アクセスを防ぎます。これにより、万が一データが漏洩しても内容が読み取られるリスクを減少させることができます。

次に、データアクセスの制御も重要です。企業内部でのデータアクセスは、必要な権限を持つ者のみに限定し、不必要なアクセスを制限することで、内部からのデータ漏洩を防ぐことができます。また、アクセスログを定期的に監視し、不審なアクセスがないかをチェックすることも重要です。これにより、早期に異常を発見し対処することが可能となります。

さらに、企業はデータ保護に関するポリシーを明確にし、従業員全体に周知徹底する必要があります。データ保護の重要性を理解し、日常業務において適切な取り扱いを行うための教育とトレーニングを実施することが求められます。これにより、企業全体で一貫したデータ保護体制を構築することが可能です。

最後に、外部の専門家による定期的なセキュリティ監査を実施し、最新の脅威に対する防御策を講じることも重要です。これにより、企業は常に最新のセキュリティ対策を維持し、データ保護の強化を図ることができます。プライバシーとデータ保護の強化は、企業の信頼性を高めるだけでなく、法的リスクの軽減にも繋がります。

AI倫理のガイドラインと国際的な取り組み

AI技術の急速な発展に伴い、国際的なガイドラインと取り組みが重要視されています。各国政府や国際機関は、AIの倫理的な利用を促進するためのガイドラインを策定し、その実践を推進しています。これらのガイドラインは、AIの開発と利用における透明性、公平性、プライバシー保護などの原則を示しています。例えば、欧州委員会は「信頼できるAIのための倫理ガイドライン」を発表し、AIシステムが合法的かつ倫理的で堅固なものであることを求めています。

このガイドラインでは、人間の活動と監視、堅固性と安全性、プライバシーとデータのガバナンス、透明性、多様性・非差別・公平性、社会・環境福祉、説明責任の7つの要件が強調されています。これにより、AI技術の開発と利用が社会にとって有益であり続けるための枠組みが提供されています。さらに、欧州各国の企業はこれらのガイドラインに基づき、AIシステムの設計と運用を行っています。

米国でも、非営利団体や企業がAI倫理のガイドラインを策定しています。例えば、OpenAIはAIの安全性と倫理的利用を推進するためのガイドラインを公表しており、企業や研究機関がこれを参考にしています。また、シンガポール政府は「AIガバナンスと倫理のイニシアチブ」を発表し、産業界と連携してAIの倫理的な利用を促進しています。このイニシアチブでは、企業が自主的にガイドラインを策定し、実践することが推奨されています。

さらに、国際的な協力も進んでいます。OECDはAIに関する勧告を採択し、G20貿易・デジタル経済大臣会合でも「人間中心」のAI原則が合意されています。これにより、各国が共通の基準に基づいてAI技術の開発と利用を行うことが可能となり、国際的な競争力が強化されます。

AI倫理のガイドラインと国際的な取り組みは、企業が倫理的にAI技術を利用するための指針を提供します。企業はこれらのガイドラインを遵守し、透明性、公平性、プライバシー保護を確保することで、持続可能なAI利用を実現することが求められます。これにより、社会全体にとって有益な技術の発展が期待されます。

未来のデジタル社会に向けて

未来のデジタル社会において、AI技術はますます重要な役割を果たすことが予想されます。企業はこの変化に対応し、持続可能なビジネスモデルを構築するために、デジタルエシックスを重視する必要があります。デジタルエシックスとは、AIやデジタル技術の利用における倫理的な課題に対処するための指針です。これにより、企業は透明性、公平性、プライバシー保護を確保し、社会全体の信頼を得ることができます。

具体的には、企業はAI技術の開発と利用において、透明性を確保するための取り組みを進める必要があります。AIの意思決定プロセスを説明可能にすることで、利用者や規制当局の信頼を得ることができます。また、公平性を確保するためには、データのバイアスを排除し、多様なデータを使用することが求められます。これにより、AIが偏見のない判断を下すことが可能となります。

さらに、プライバシー保護も重要な要素です。企業はデータの収集・利用において、個人情報の保護を徹底し、適切なデータ管理を行う必要があります。これには、データの匿名化や暗号化、アクセス制御などの技術的対策が含まれます。プライバシー保護の強化は、企業の信頼性を高めるだけでなく、法的リスクの軽減にも繋がります。

デジタルエシックスを実践するためには、企業内での教育とトレーニングも欠かせません。従業員全体がデジタルエシックスの重要性を理解し、日常業務において適切に実践するための環境を整えることが求められます。これにより、企業全体で一貫した倫理的な取り組みが可能となります。

さらに、企業は外部の専門家との連携を強化し、最新の技術動向や倫理的課題に対する対応策を共有することが重要です。これにより、持続可能なデジタル社会の実現に向けた取り組みが進められます。企業はデジタルエシックスを重視し、透明性、公平性、プライバシー保護を確保することで、未来のデジタル社会においても競争力を維持し続けることが可能です。

まとめ:AIとビジネスエシックスの重要性

AI技術の進展に伴い、ビジネスの現場での倫理的な課題が増大しています。デジタルエシックスの重要性は、企業が社会的責任を果たし、信頼性の高いAIシステムを構築するために不可欠です。デンマークの事例から学ぶように、ステークホルダーとの対話を通じて共通の倫理ガイドラインを持つことが重要です。これにより、技術の利用がもたらすリスクを最小限に抑えつつ、持続可能な社会を実現するための施策が進められます。

日本においても、政府や企業がAI倫理の取り組みを強化し、透明性と説明可能性を確保することが求められます。ブラックボックス問題や差別・偏見の問題に対処するためには、データのバイアスを排除し、公正なアルゴリズムを設計する必要があります。また、プライバシー保護の強化も重要であり、データの匿名化や暗号化、アクセス制御を徹底することが必要です。外部の専門家による定期的なセキュリティ監査も有効な対策です。

国際的なガイドラインに基づき、企業はAI技術の利用における透明性、公平性、プライバシー保護を徹底することで、持続可能なAI利用を実現することが期待されます。未来のデジタル社会に向けて、デジタルエシックスを重視し、企業全体で一貫した倫理的な取り組みを行うことが求められます。デジタルエシックスを実践することで、企業は信頼性を高め、社会全体にとって有益な技術の発展を支援することが可能です。