CerebrasがMetaのLlama 3.1 405B大規模言語モデルを用いて示した性能は、AI推論の新たな水準を切り開いた。独自の第3世代Wafer Scale Engineを搭載したCerebras Inferenceは、Nvidia GPUを使用するAWSの最速AIサービスと比較し、トークン生成速度で75倍の差を記録。

この成果により、Metaの最先端LLMはCerebrasの技術基盤上で1秒間に969トークンを生成する圧倒的な処理能力を実現した。さらにPythonを用いたチェスプログラム生成タスクでは、競合するGPUクラウドに比べ最大で6倍以上の効率を達成。同サービスは、大規模AIモデルの高速化という課題において、技術革新の最前線に立っていることを改めて証明した。

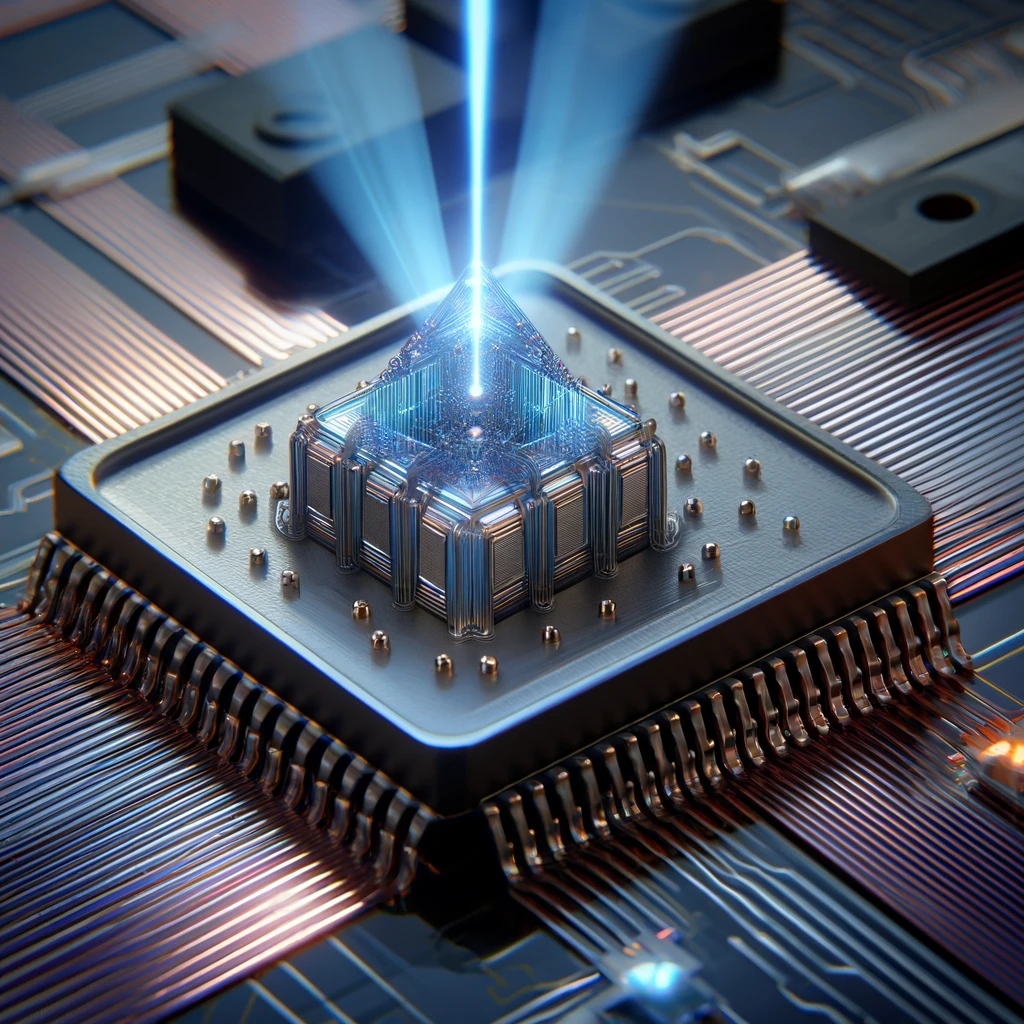

Cerebrasの技術基盤が示すAIチップ設計の革新性

Cerebrasが採用する第3世代Wafer Scale Engine(WSE)は、既存のGPUに依存しない独自のアプローチである。このプロセッサは通常の半導体とは異なり、一枚の大規模ウェハ上に計算資源を統合する設計を持つ。この設計により、分散処理のための通信遅延を劇的に削減し、トークン生成速度を最大化するという特性を実現している。特に、MetaのLlama 3.1 405Bのような超大規模言語モデルでは、このアーキテクチャの効率性が際立つ。

さらに、Cerebrasは独自の冷却技術や消費電力の最適化手法も導入しており、物理的な制約を乗り越える設計思想を反映している。AWSのNvidia GPUが多層的なクラスタ構造に頼る中、Cerebrasはシンプルかつ一貫した構成で性能を追求している。この技術基盤は、高性能AI推論を求める現代において、大規模データの効率的な活用を可能にするものである。

これらの点から、Cerebrasの設計はAI推論専用チップの未来像を示しているといえる。一方で、従来のGPUが持つ汎用性という強みとの比較も重要であり、用途や導入コストの観点から技術的選択が求められる局面が増えるだろう。

トークン生成速度の比較が示唆するAI推論の新たな指標

CerebrasがLlama 3.1 405Bで達成した毎秒969トークンという速度は、NvidiaのGPUによるAWSのクラウドサービスに比べ75倍の性能差を示している。この比較は、単なる速度向上ではなく、AI推論の新たな評価基準を提起している。特に、AI応答の即時性が求められる生成系アプリケーションやリアルタイム処理において、トークン生成速度がパフォーマンス全体に直結する点を明らかにした。

また、Pythonによるチェスプログラム生成タスクにおけるデモンストレーションは、具体的な応用場面での優位性を可視化している。Cerebrasは約3秒でタスクを完了し、GPUベースのFireworksクラウドサービスをはるかに凌駕した。この結果は、AIの演算速度が実務に与える影響の重要性を浮き彫りにしている。

ただし、トークン生成速度だけでは必ずしもすべてのAIワークロードにおける優位性を示せない可能性もある。例えば、並列処理や画像生成など異なる処理特性を持つタスクでは、他の技術が競争力を持つ可能性があるため、さらなる実証が期待される。

AIハードウェア競争の行方とCerebrasの位置づけ

今回のCerebrasの成果は、AIハードウェア市場における激しい競争の中で独自のポジションを確立する動きといえる。従来、AI推論ではNvidiaやAMDのGPUが市場を席巻していたが、Cerebrasのような特化型チップが台頭することで、競争の軸が変化しつつある。AWSやTogether AIとの比較データが示すように、速度や消費電力の最適化が今後の競争ポイントとなることは間違いない。

さらに、Cerebrasの技術はAI推論に留まらず、分子動力学シミュレーションの分野でも世界最速の記録を更新した。この多様性が示すのは、単一用途に特化した性能ではなく、幅広い計算要求を網羅できる可能性である。特に、科学研究や産業応用など高度な計算能力を要する領域での影響力が拡大していくとみられる。

一方で、既存のAIインフラとの互換性や導入コストといった課題も残る。これらの課題が解消されることで、Cerebrasが市場全体を再編する可能性は十分にあるだろう。