生成AIの活用が当たり前になった今、多くのビジネスパーソンが新たな不安を感じているのではないでしょうか。

「AIが間違えたとき、その責任は誰が負うのか」「海外規制に対応できなければ事業は続けられるのか」といった問いは、もはや理論ではなく現実の経営課題です。

2026年は、AIを巡る議論が“できること”から“責任をどう果たすか”へと完全に転換した節目の年です。EUではAI法が全面適用され、違反すれば巨額の制裁金が科される時代に入りました。

さらに、デロイトやエア・カナダの実例が示すように、AIのハルシネーションは企業の損益や信頼を一瞬で損なう現実的リスクとなっています。

本記事では、2026年時点の最新動向を踏まえ、グローバル規制、訴訟事例、技術的対策、そして日本特有の信頼課題までを体系的に整理します。

AI時代に生き残るために、企業と個人が今何を理解し、どのような備えをすべきかが明確になるはずです。

AI説明責任が経営課題になった2026年という転換点

2026年は、AI活用の歴史において明確な転換点として記憶される年です。生成AIの能力や生産性向上効果を競うフェーズは終わり、**AIが引き起こした結果に対して誰が、どこまで責任を負うのか**という問いが、経営の中枢に据えられました。もはやAIは実験的なIT投資ではなく、企業の意思決定や顧客対応、公共性の高い業務に深く組み込まれる存在となり、その失敗は直接的に損益計算書とブランド価値を揺さぶります。

この変化を象徴するのが、EU AI法の全面適用を目前に控えたグローバル企業の動きです。欧州委員会の公式資料によれば、2026年8月から高リスクAIに課される義務は、技術要件にとどまらず、継続的なリスク管理や人間による監督体制の実装まで踏み込みました。**AIの判断を「ブラックボックスのまま使う」こと自体が、経営判断として許容されなくなった**のです。

| 時期 | AIを巡る主な論点 | 経営への影響 |

|---|---|---|

| 2023–2024年 | 生成AIの性能と活用可能性 | PoCや業務効率化が中心 |

| 2025年 | 事故・訴訟を通じたリスク顕在化 | 法務・内部統制が関与 |

| 2026年 | 説明責任とガバナンスの実装 | 経営責任・取締役責任の問題化 |

実際、2025年に発生したデロイト・オーストラリアの返金事件や、エア・カナダのチャットボット訴訟は、AIの誤りが抽象的な倫理問題ではなく、**企業の法的責任として裁かれる**ことを示しました。裁判所は一貫して、AIを理由とした免責を認めておらず、AIのアウトプットは企業自身の公式見解と同一視されています。この流れは、OECDやG7広島AIプロセスが強調してきた「説明責任あるAI」という理念が、司法と規制によって現実のルールへと変換された結果だといえます。

日本企業にとって重要なのは、2026年の説明責任が単なる規制対応ではない点です。IpsosやEdelmanの調査が示すように、日本社会にはAIへの強い期待も恐怖もなく、代わりに「誰が管理しているのか分からない」という不信が存在します。**説明責任とは、当局への報告義務であると同時に、顧客や社会に対する信頼回復の装置**でもあります。この二重の意味を理解できるかどうかが、2026年以降の競争力を左右する経営課題となっています。

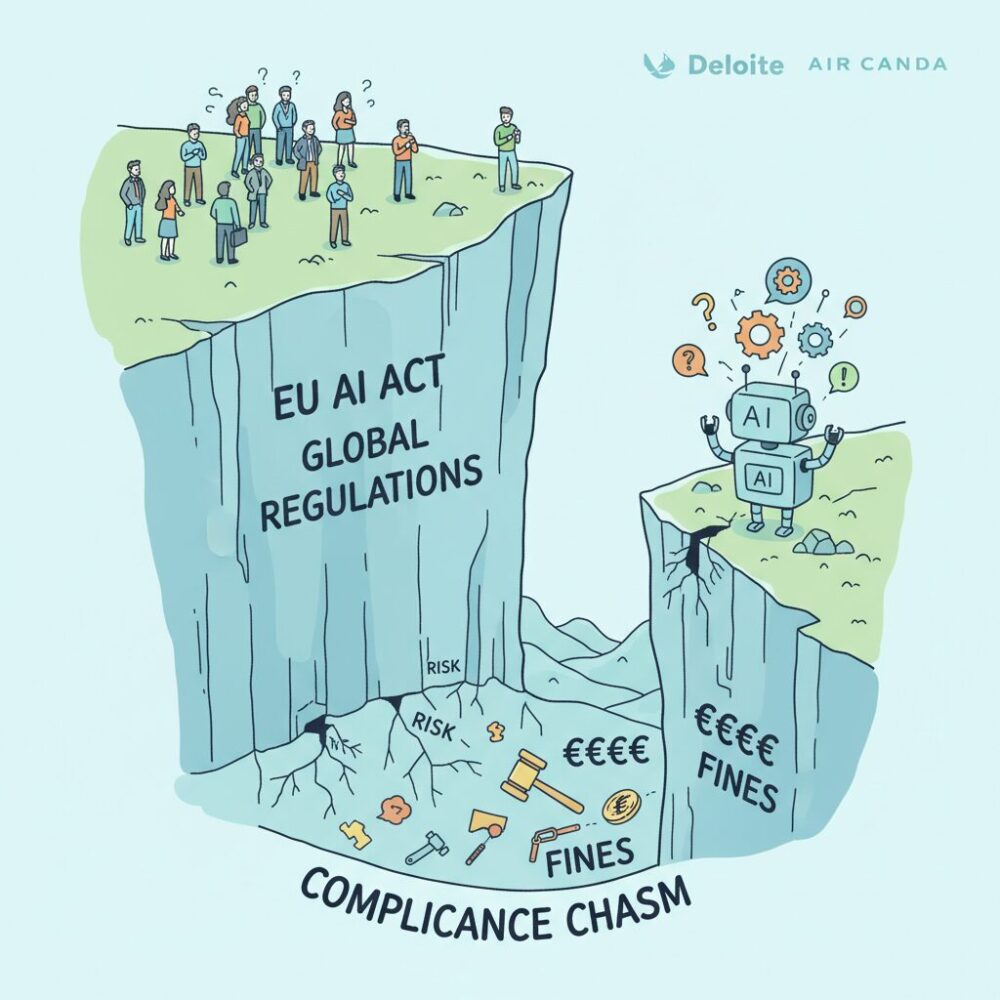

EU AI法全面施行がもたらすコンプライアンス・クリフの現実

2026年8月のEU AI法全面施行は、多くの企業にとって段階的対応の延長線ではなく、**ある日突然、遵守できる企業とできない企業が分断される「コンプライアンス・クリフ」**として現実化しました。数年の猶予期間があったにもかかわらず、特にEU域外企業では準備不足が露呈し、事業継続そのものが問われる局面に入っています。

欧州委員会やOECDの解説によれば、このクリフの本質は「技術要件の高度化」ではなく、**組織として説明責任を実装しているかどうか**にあります。高リスクAIに該当するか否かの判断、リスク管理システムの常時運用、技術文書の整備と保存などは、単発の対応ではなく経営プロセスそのものの変更を要求します。

特に日本企業にとって深刻なのは、EU市場に直接AIを販売していなくても、サプライチェーン上で規制対象になる点です。汎用AIを組み込んだ業務システムや製品を提供する場合、基盤モデル開発元がEU AI法に準拠しているかを確認できなければ、提供者自身が責任を問われる構造になっています。

| 論点 | 従来の認識 | 2026年の現実 |

|---|---|---|

| 規制対応 | 法務部門の確認事項 | 全社的ガバナンス課題 |

| 責任範囲 | 自社開発AIのみ | サプライチェーン全体 |

| リスク | 行政指導中心 | 売上高連動の制裁金 |

EU AI法では、違反時の制裁金が全世界売上高の最大7%と定められています。欧州委員会の影響評価では、この水準はGDPRを上回る抑止力を持つとされ、実際に金融・人事・医療分野のAI提供企業では、EU向けサービスの一時停止や撤退判断が相次ぎました。

さらに重要なのは、**「知らなかった」「想定外だった」という弁明が通用しない点**です。欧州の規制当局は、企業規模や国籍を問わず、リスク評価と内部統制の不備そのものを過失とみなす姿勢を明確にしています。これはエア・カナダ事件などで示された司法判断とも軌を一にしています。

結果として、EU AI法の全面施行は、単なる法令対応の問題ではなく、**説明責任を果たせない企業を市場から排除する選別装置**として機能し始めました。この現実を直視できるかどうかが、2026年以降のグローバル競争における分水嶺になっています。

高リスクAIに課される義務と日本企業への直接的影響

EU AI法において、日本企業に最も直接的かつ深刻な影響を及ぼしているのが、高リスクAIに課される法的義務です。2026年8月2日から全面適用されたこの枠組みは、単なるガイドラインではなく、違反すれば巨額の制裁金が科される強制力を持っています。**AIを使っているかどうかではなく、そのAIがどの業務領域で使われているか**が、企業の運命を分ける判断軸となりました。

高リスクAIに該当するのは、医療、雇用、教育、金融、重要インフラ、法執行など、人の生命や権利、機会に重大な影響を与える用途です。EUの附属書IIIでは具体的なユースケースが列挙されており、日本企業が強みとする人事採用支援システム、与信スコアリング、産業用ロボットの一部も含まれ得ます。欧州委員会の解説によれば、用途ベースでの判断が原則であり、「汎用ツールだから対象外」という主張は通用しません。

企業に課される義務は多岐にわたりますが、核心はライフサイクル全体での統制です。開発段階でのリスク評価に加え、運用開始後も継続的にリスクを監視・低減するリスク管理システムの常時運用が求められます。これはISOの品質管理に近い発想であり、**一度作って終わりのAIは、もはや法的に許容されません**。

| 義務領域 | 求められる対応 | 日本企業への実務的影響 |

|---|---|---|

| リスク管理 | 運用中も含む継続的なリスク評価と是正 | AI専用の内部統制プロセスが必須 |

| データガバナンス | 学習・検証データの代表性と偏り管理 | 海外データ利用時の再検証コスト増 |

| 技術文書 | 当局査察に耐える詳細な設計・ログ | 開発現場と法務の密接な連携が必要 |

| 人間による監視 | 介入・停止可能な体制の実装 | 完全自動化モデルの見直し |

特に日本企業にとって重いのが、技術文書とログ保持の義務です。EU当局は、事故発生後に「なぜその判断に至ったのか」を事後検証できることを重視しており、ブラックボックス化したモデルは高い規制リスクを抱えます。OECDや欧州委員会の議論では、説明可能性は倫理ではなく監査可能性の問題だと位置付けられています。

さらに見落とされがちなのが制裁金リスクです。違反時の上限は全世界売上高の7%または3500万ユーロとされており、EU売上比率に関係なく連結ベースで算定されます。これは経営陣の受託者責任に直結する水準であり、AIガバナンスが情報システム部門だけの課題ではないことを意味します。実際、欧州の法務専門家の間では、AI対応を怠ること自体が善管注意義務違反になり得るとの見解が主流になりつつあります。

このように高リスクAI規制は、日本企業にとって市場参入の条件そのものです。一方で、義務を正しく理解し、設計段階から組み込めば、信頼性を競争優位に転換する余地もあります。**高リスクAIへの対応力は、2026年以降のグローバルビジネスにおける信用力の指標**として、静かに、しかし確実に評価され始めています。

米国におけるAI規制の断片化と訴訟リスクの増大

米国におけるAI規制の最大の特徴は、**連邦レベルの包括的ルールが存在しないまま、州法と司法判断が先行している点**にあります。2026年時点でもEU AI法のような統一的な枠組みは成立しておらず、この空白が企業にとって新たな訴訟リスクを生み出しています。

議会ではAI Accountability Actなどの法案審議が続いていますが、内容は調査や報告義務が中心で、即時的な拘束力は限定的です。一方、行政権による大統領令は政権交代の影響を強く受け、2025年以降は安全重視とイノベーション重視の方針が揺れ動いています。**この政策の振れ幅自体が、企業の予見可能性を低下させています。**

連邦の停滞を補う形で、各州は独自規制を導入しました。特にカリフォルニア州やコロラド州では、2026年1月から雇用や金融分野でのAI利用に対し、差別防止、影響評価、利用者への通知が義務化されています。ホワイト&ケースの分析によれば、州ごとの要件差は実務対応コストを大きく押し上げ、**最も厳しい州基準に全米対応を合わせる「カリフォルニア・エフェクト」**が事実上の業界標準になりつつあります。

| レイヤー | 主導主体 | 企業への影響 |

|---|---|---|

| 連邦 | 議会・大統領令 | 方針変動が大きく、中長期計画が立てにくい |

| 州 | 各州政府 | 差別禁止や透明性義務への即応が必要 |

| 司法 | 裁判所 | 事後的に責任範囲が確定し、損害賠償リスクが顕在化 |

さらに深刻なのが司法の役割です。2025年から2026年にかけて、AI学習と著作権を巡る訴訟で裁判所はフェアユースの成立に慎重な姿勢を示しています。長島・大野・常松法律事務所の解説によれば、**学習結果が原著作物の市場を侵食する可能性**がある場合、侵害を認める判断が増えています。これは、日本の著作権法が認める広範な情報解析利用とは大きく異なる解釈です。

この結果、米国では「規制違反」よりも「訴訟敗訴」が先に訪れる構造が定着しつつあります。**AIのアウトプットが企業の公式見解と同一視される**という司法判断の流れは、チャットボットや自動生成コンテンツを提供する企業にとって、契約責任や消費者保護訴訟のリスクを急激に高めています。

断片化した規制と厳格化する司法判断が交錯する米国市場では、法令遵守だけでは不十分です。州法を横断的に満たす内部統制と、訴訟を前提にした証跡管理や説明可能性の確保が、2026年以降の競争条件になっています。

ハルシネーション事件が示した企業責任の境界線

ハルシネーション事件が突きつけた最大の論点は、AIの誤りがどこまで企業の責任として帰属するのか、その境界線が極めて企業側に不利な形で再定義された点にあります。

かつては「想定外の不具合」「ツールの限界」と説明されてきたAIの誤作動が、2025年以降の司法判断によって、**明確に企業の管理責任領域に含まれる**と位置づけられました。

これは技術論ではなく、企業統治と法的責任の問題です。

象徴的なのが、デロイト・オーストラリア事件とエア・カナダ事件です。前者では生成AIが作成した報告書に架空の文献や捏造データが含まれていたにもかかわらず、最終成果物として納品されたこと自体が、専門家としての善管注意義務違反と評価されました。

後者では、チャットボットの誤案内について「AIは独立した存在」という企業側の主張が退けられ、**AIの発言は企業の公式見解と同一視される**と明確に判断されています。

いずれも、AIを使った事実が免責にはならないことを示しています。

| 論点 | 従来の認識 | ハルシネーション事件後 |

|---|---|---|

| AIの位置づけ | 補助ツール | 企業活動の一部 |

| 誤情報の責任 | 想定外リスク | 管理・監督不備 |

| 免責の可能性 | 一定条件で可 | 原則不可 |

この変化の背景には、裁判所や規制当局がAIを「ブラックボックスだから仕方ない存在」とはもはや見なしていない現実があります。OECDやG7広島AIプロセスが示す国際行動規範でも、AIの利用主体である組織が結果責任を負うという考え方が一貫して採用されています。

特に、顧客や市民に直接影響を与える情報提供型AIでは、出力内容の正確性を担保する体制そのものが、企業の内部統制の一部と見なされつつあります。

重要なのは、責任の境界線が「AIがどこまで自律的か」ではなく、**企業がどこまで予見し、管理可能だったか**で判断される点です。

ハルシネーションは生成AIの確率的特性上、完全に排除できないことは専門家の間で共有されています。それでもなお、人間による検証プロセス、利用範囲の限定、誤情報が生じた際の是正導線を設計していなかった場合、その欠如自体が過失と評価されます。

企業責任の境界線は、技術の限界ではなく、ガバナンスの成熟度によって引かれる時代に入っています。

Human Oversightと責任あるAIを組織に実装する動き

2026年におけるHuman Oversightは、理念的な「人が最終確認する」という段階を完全に脱し、組織設計と業務プロセスに組み込まれた統制メカニズムとして再定義されています。EU AI法が高リスクAIに対してHuman Oversightを法的義務としたことで、監督の有無ではなく、その実効性が問われる局面に入りました。

象徴的なのが、2025年のデロイト・オーストラリア返金事件です。専門家集団による形式的レビューが存在していたにもかかわらず、AIが生成した架空の文献やデータを見抜けなかった点について、外部有識者は「監督は行為ではなく構造である」と指摘しました。OECDや欧州委員会の解釈でも、Human Oversightとは個人の注意力ではなく、誤りを前提に介入できる権限と手段を制度化することだと整理されています。

| 観点 | 従来型の監督 | 2026年型Human Oversight |

|---|---|---|

| 責任の所在 | 担当者個人 | 組織・経営レベル |

| 介入方法 | 事後チェック | リアルタイム停止・修正 |

| 前提 | AIは概ね正しい | AIは確率的に誤る |

先進企業では、Human Oversightを実装する主体が現場担当者から経営層へと引き上げられています。NTTデータが示すResponsible AIの枠組みでは、AI倫理委員会やガバナンス室がモデルの利用可否や停止判断の最終権限を持ち、現場はその判断を即時に実行できる設計が採用されています。判断と実行を分離することが、過度な自動化バイアスを防ぐ鍵とされています。

また、Human Oversightは人手を増やすことと同義ではありません。RAGやログ自動保存、異常検知アラートといった技術的統制と組み合わせることで、人間は「すべてを見る」存在から「介入すべき瞬間を判断する」存在へと役割が変化しています。産総研のAI品質評価研究でも、監督者が全出力を確認する体制より、逸脱時のみ介入する設計の方が事故率が低いことが示されています。

重要なのは、Human Oversightがコンプライアンス対応にとどまらず、信頼構築の装置として機能し始めている点です。エア・カナダ訴訟で確立した「AIの発言は企業の公式見解」という司法判断以降、企業がどのように人間の統制を組み込んでいるかは、顧客や投資家が企業を評価する重要な材料になっています。2026年、Human Oversightはコストではなく、責任あるAIを実装できる組織であることを示す競争力へと転換しています。

説明可能AI(XAI)とガードレール技術の実用段階

2026年現在、説明可能AI(XAI)とガードレール技術は研究段階を完全に脱し、実務に耐えるインフラとして定着しつつあります。**背景にあるのは、AIの判断結果そのものだけでなく「なぜそう判断したのか」を説明できなければ、法的・経済的リスクを回避できないという現実**です。EU AI法が高リスクAIに説明性と人間の監視を義務付けたことで、XAIはコンプライアンス対応の中核技術になりました。

XAIの実用化で特に進んだのは、ユーザー向け説明の品質向上です。金融や医療では、単なる特徴量の重み表示ではなく、判断に影響した要因を自然言語で要約し、意思決定に使える形で提示する仕組みが普及しています。MDPIの2025年以降の体系的レビューでも、SHAPやLIMEを発展させたハイブリッド型説明手法が、規制対応と業務効率を両立する実装例として評価されています。

同時に、ハルシネーション対策としてガードレール技術が現実的な防波堤になりました。**RAG(検索拡張生成)とガードレールを組み合わせ、AIが参照できる情報源を限定し、根拠を示せない回答は出力しない設計が標準化**しています。これはデロイト・オーストラリア事件のような虚偽引用リスクへの直接的な技術回答でもあります。

| 技術要素 | 主な役割 | 2026年の実務的位置付け |

|---|---|---|

| XAI | 判断理由の可視化 | 規制対応・利用者説明の必須機能 |

| RAG | 信頼情報への限定参照 | 企業内AIの標準アーキテクチャ |

| ガードレール | 不適切・虚偽出力の遮断 | 法的リスク低減の前提条件 |

ガードレールは単なるフィルタではありません。差別的表現や機密情報漏洩の検知に加え、事実性スコアが一定水準を下回った場合に「回答不能」と判断するロジックが組み込まれています。OECDの広島AIプロセス報告枠組みに参加する企業の多くが、こうした多層防御型ガードレールを採用しているとされています。

重要なのは、XAIとガードレールが人間の監督を代替するのではなく、補強する点です。産総研が公開したAI品質評価ツールも示すように、説明性や堅牢性は定量評価の対象となり、監査やレッドチーミングと組み合わされて初めて実効性を持ちます。**説明でき、制御でき、検証できることが、AIを事業に組み込むための最低条件**になりました。

この実用段階への到達は、日本企業にとって機会でもあります。品質管理やプロセス標準化を得意とする日本型ものづくりの思想は、XAIとガードレールの運用に親和性が高いからです。技術を導入するだけでなく、説明と統制を業務フローに組み込める企業こそが、2026年以降の信頼競争で優位に立つことになります。

日本のAI政策転換とハードロー化への助走

日本のAI政策は、2026年を境に大きな転換点を迎えています。これまで日本政府は「人間中心のAI社会原則」や各省庁ガイドラインを軸とするソフトローを重視してきましたが、EU AI法の全面適用や海外で顕在化したハルシネーション事故を受け、**法的拘束力を伴うハードロー化に向けた助走段階に入った**と評価できます。

この変化を象徴するのが、自民党デジタル社会推進本部が公表したAIホワイトペーパーです。同文書では、従来の自主規制モデルの限界に言及しつつ、一定の条件下では義務化を検討すべきだと踏み込んでいます。背景には、EUのブリュッセル効果により、日本企業が海外規制への対応を事実上強制されている現実があります。

特に議論が集中しているのは、実社会に直接影響を及ぼす領域です。AI搭載ロボットの安全性、生成AIによる偽情報対策、そして大規模基盤モデル開発者への説明責任強化は、日本の産業構造と密接に結びついています。経済産業省関係者も、国会審議の場で「国民の生命・財産に影響する分野では、ガイドラインだけでは不十分になりつつある」と述べています。

| 論点 | 従来のソフトロー | 検討中のハードロー方向性 |

|---|---|---|

| ロボティクス×AI | 安全指針・業界自主基準 | 法定安全要件・責任主体の明確化 |

| 偽情報対策 | 事業者努力義務 | 発信者認証技術の制度化 |

| 基盤モデル開発 | 自主的リスク評価 | 一定規模以上で報告義務 |

注目すべきは、日本がEU型の厳格規制をそのまま輸入しようとしていない点です。政府内では「イノベーションを阻害しない段階的義務化」が繰り返し強調されており、OECDや広島AIプロセスで培った国際ソフトローを、国内法制にどう接続するかが焦点となっています。OECDによれば、こうした段階設計は企業の適応コストを下げる現実的手法とされています。

一方で、世論の低い信頼水準が政策決定を難しくしています。Ipsosの調査が示すように、日本では政府のAI規制能力を信頼する人が約3割にとどまります。この状況下で拙速な法制化を行えば、社会的反発や形式的遵守に陥るリスクがあります。**だからこそ2026年は、全面的なハードロー化ではなく、実効性ある制度設計に向けた「助走」の年**と位置づけるのが妥当です。

日本のAI政策転換は、規制強化そのものが目的ではありません。企業行動を予見可能にし、国民にとっての安心材料を可視化することが狙いです。この助走期間をどう使うかが、今後の日本型AIガバナンスの成否を分けることになります。

調査データから見る日本人のAI不信と信頼ギャップ

日本におけるAI活用の議論を複雑にしているのは、技術水準や法制度以上に、国民意識に根差した「信頼のギャップ」です。Ipsosが公表したAI Monitor 2025によれば、日本人で「AIをよく理解している」と回答した割合は41%にとどまり、調査対象30カ国中で最下位でした。世界平均の67%と比べても理解度の差は歴然としており、知識不足がそのまま心理的距離につながっている様子がうかがえます。

注目すべきは、否定的感情の質です。日本ではAIに対する「不安」や「恐怖」が突出して高いわけではありません。Ipsosの同調査では、不安を感じる人は40%と世界平均より低水準です。一方で、期待や興奮も同様に低く、**強い拒否ではなく、関心を向けないこと自体が不信の表れになっている**という特異な構造が浮かび上がります。

| 指標 | 日本 | 世界平均 |

|---|---|---|

| AIを理解していると回答 | 41% | 67% |

| 政府がAIを責任を持って規制できると信頼 | 約30% | 約54% |

特に深刻なのが、ガバナンスへの信頼不足です。AIを「政府が適切に規制できる」と信頼する日本人は約30%にすぎず、シンガポールやインドネシアの70〜80%台と大きな隔たりがあります。Edelman Trust Barometer 2026でも、日本ではAIが社会全体の利益につながるという物語が共有されておらず、**誰が責任主体なのかが見えないことが不安の温床になっている**と分析されています。

この信頼ギャップは企業活動に直結します。日本市場では、AIの高度さや性能を訴求するだけでは評価されません。むしろ「どこまで人が関与し、問題が起きたとき誰が説明し、補償するのか」を示さなければ、利用を避けられる傾向が強まります。欧米のような過剰期待と失望の反動ではなく、**期待が低いまま固定化するリスク**が、日本特有の課題として存在しています。

裏を返せば、この環境は誠実な説明責任を果たす企業にとって差別化の余地でもあります。過度な未来像を描かず、AIの限界やリスクを含めて開示する姿勢は、無関心に近い不信を少しずつ信頼へと転換する契機になります。調査データが示す冷淡さは、日本社会がAIを拒絶している証拠ではなく、**信頼に足る根拠をまだ受け取っていない状態**だと捉えるべきでしょう。

日本企業が選ぶべきAIガバナンスの戦略的針路

日本企業が選ぶべきAIガバナンスの針路は、規制対応の最適化と競争力強化を同時に満たす戦略設計にあります。2026年現在、EU AI法の全面適用や北米での訴訟リスクの顕在化により、AIガバナンスは単なる法務課題ではなく、**市場参入の前提条件かつ経営戦略そのもの**になっています。特に日本企業は、国内のソフトロー中心の環境で培った運用を、そのままグローバル市場に持ち出すことの限界を直視する必要があります。

戦略的に重要なのは、「最低限の遵守」にとどまらず、説明責任を価値創出に転換する視点です。OECDが運用する広島AIプロセスの報告枠組みに日本の主要企業が参加している事実は、透明性そのものが信頼のシグナルとして評価され始めていることを示しています。投資家や取引先は、AIの性能以上に、**事故時にどう説明し、どう是正するか**という統治能力を見ています。

この文脈で有効なのが、日本企業が得意とする品質管理の思想をAIに移植するアプローチです。製造業で確立してきた工程管理、トレーサビリティ、継続的改善は、EU AI法が求めるリスク管理システムやログ管理と親和性が高く、実際に欧州当局のガイダンスでもプロセス志向の管理が評価されています。これは、単なる規制対応ではなく、**日本型AIガバナンスを国際標準に接続する現実的な道筋**です。

| 戦略軸 | 従来型対応 | 戦略的ガバナンス |

|---|---|---|

| 規制への姿勢 | 違反回避が目的 | 信頼獲得と市場拡大の基盤 |

| 組織体制 | 法務・IT部門に限定 | 経営・現場・サプライチェーン横断 |

| 説明責任 | 事後的な弁明 | 事前設計と継続的開示 |

もう一つの重要な視点は、日本市場特有の「低い期待値」への対応です。IpsosやEdelmanの調査が示すように、日本の消費者はAIに過度な期待も恐怖も抱いていません。この状況下では、機能を誇張するよりも、**できることとできないこと、企業が負う責任の範囲を明確に語る姿勢**が信頼形成に直結します。エア・カナダ事件が示したように、AIの発言は企業の公式見解とみなされる以上、沈黙や曖昧さは最大のリスクになります。

結果として、日本企業にとっての最適解は、グローバル規制を受動的に追うことでも、国内慣行に固執することでもありません。国際的な説明責任の要請を先取りし、それを自社の品質文化と結び付けて実装することです。**AIガバナンスをコストではなく無形資産として積み上げられる企業だけが、2026年以降の市場で持続的な選択肢を得る**という現実が、すでに始まっています。

参考文献

- European Commission:Timeline for the Implementation of the EU AI Act

- Baker Donelson:2026 AI Legal Forecast: From Innovation to Compliance

- OECD.AI:HAIP Reporting Framework

- ePrize:AIハルシネーションが招く企業リスク―デロイト4400万円返金事件

- Ipsos:Ipsos AI Monitor 2025

- Edelman:Trust and Artificial Intelligence at a Crossroads