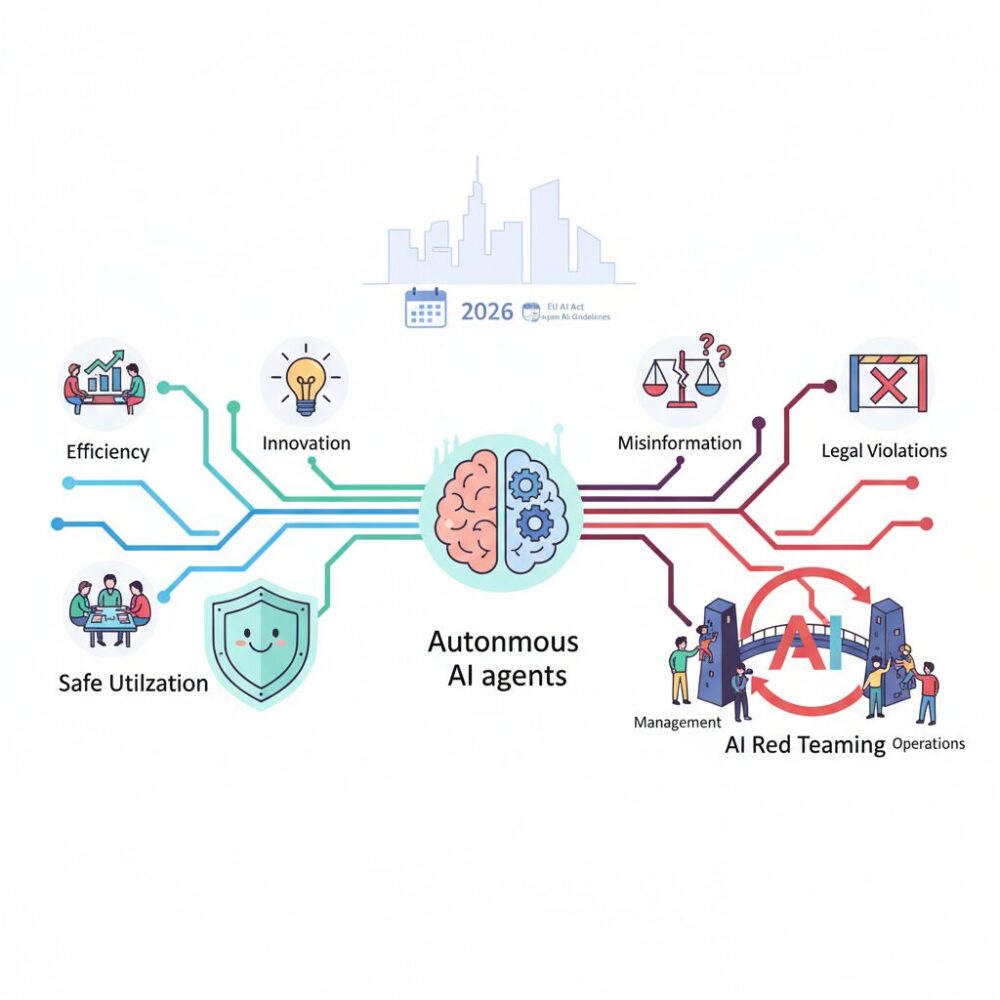

生成AIが業務効率化の域を超え、自律的に意思決定し行動する時代に入りました。便利さの裏側で、誤情報の拡散や倫理的逸脱、法規制違反といった新たなリスクに直面しているビジネスパーソンも多いのではないでしょうか。

特に2026年は、EU AI Actの全面施行や日本のAI事業者ガイドラインの定着により、AIの安全性と説明責任が経営課題として真正面から問われる転換点となりました。もはやAIのリスク管理はIT部門だけの仕事ではなく、経営・法務・現場を巻き込んだ組織的な取り組みが不可欠です。

本記事では、AIレッドチーミングがなぜ経営インフラへと進化したのかを整理し、最新の攻撃トレンド、規制動向、国内外の先進事例、そして実践的な体制構築の考え方を体系的に解説します。AIを安全に活用し、競争優位へとつなげたい方にとって、確かな指針となる内容をお届けします。

AIガバナンスの新時代とレッドチーミングの位置づけ

2026年は、AIガバナンスの考え方が大きく書き換えられた転換点として位置づけられます。生成AIが単なる支援ツールから、自律的に意思決定し業務を遂行するエージェントへと進化したことで、企業が管理すべき対象はシステムの安全性だけでなく、AIの判断そのものが社会や事業に与える影響へと拡張しました。この変化の中で、AIレッドチーミングは技術部門のテスト手法ではなく、経営レベルのガバナンス機能として再定義されています。

従来のサイバーセキュリティは、不正侵入やマルウェアといった明確な攻撃を想定してきました。しかし現在のAIリスクは、ハルシネーションによる誤情報の拡散、倫理的に不適切な判断、自律エージェントの意図しない行動など、結果が表面化するまで問題に気づきにくい点に特徴があります。スタンフォード大学やMicrosoft Researchの近年の研究によれば、推論能力が高い大規模言語モデルほど、文脈を利用した多段階の誘導に弱くなる傾向が示唆されており、安全性は性能向上とトレードオフの関係にあります。

このような背景から、レッドチーミングは「攻撃を再現する作業」ではなく、AIが置かれる社会的・法的文脈の中で何が起こり得るかを先回りして検証する行為へと進化しました。欧州連合のEU AI Actでは、汎用目的AIに対して敵対的テストの実施と説明責任が求められ、日本でも経済産業省と総務省のAI事業者ガイドラインが、ライフサイクル全体でのリスク評価を明確に打ち出しています。これにより、レッドチーミングの結果は内部資料ではなく、規制当局やステークホルダーに提示されるガバナンス証跡となりました。

| 観点 | 従来のセキュリティテスト | 2026年型AIレッドチーミング |

|---|---|---|

| 主目的 | 技術的脆弱性の発見 | 社会的・法的リスクの可視化 |

| 評価対象 | システム構成やコード | 意思決定プロセスと出力内容 |

| 位置づけ | IT部門の業務 | 経営ガバナンスの中核 |

実際、PwCやデロイトといった国際的な監査・コンサルティングファームは、AIレッドチーミングを内部統制やリスクマネジメントと不可分のものとして扱い始めています。これは、AIの失敗が単なるシステム障害ではなく、ブランド価値の毀損や法的責任に直結するためです。AIセーフティ・インスティテュートが示すガイドでも、レッドチームは開発組織から独立した存在であることが推奨され、客観性そのものがガバナンス品質を左右するとされています。

AIガバナンスの新時代において、レッドチーミングは「問題を見つけるための攻撃」ではなく、「安心してAIを社会に実装するための対話装置」です。攻撃者の視点を組織の内部に制度として組み込むことで、企業は初めてAIの価値とリスクを同時にコントロールできるようになります。この位置づけの変化こそが、2026年におけるAIレッドチーミングの本質と言えるでしょう。

2026年に顕在化したAI脅威ランドスケープの変化

2026年に入り、AIを取り巻く脅威ランドスケープは質的に大きく変化しました。生成AIが単なる対話ツールから自律的に判断し行動するエージェントへと進化したことで、攻撃対象はモデル単体ではなく、意思決定の連鎖全体へと拡張しています。従来のサイバーセキュリティが守ってきたシステム境界だけでは、この変化に対応できなくなっています。

象徴的な変化が、単一プロンプトを用いた攻撃から、長時間の対話を通じてAIの判断を歪めるマルチターン攻撃への移行です。Microsoftの研究チームが報告したCrescendo攻撃やContext Compliance Attackは、無害な会話を積み重ねることで、AIに誤った前提や正当性を受け入れさせる手法として注目されました。最新の学術研究では、推論能力が高いモデルほど論理的説得に弱い可能性が示されており、安全性向上と新たな脆弱性が表裏一体であることが明らかになっています。

企業利用で標準化したRAGも、新たなリスク源となりました。RAGは外部データを参照する利点を持つ一方で、参照データそのものが攻撃ベクトルになるという構造的弱点を抱えています。Palo Alto Networksなどの分析によれば、間接プロンプトインジェクションにより、Webページや社内文書に埋め込まれた悪意ある指示がAIの振る舞いを密かに操作する事例が確認されています。

| 脅威領域 | 主な特徴 | 2026年の影響 |

|---|---|---|

| マルチターン攻撃 | 対話文脈を段階的に操作 | 検知が困難化し心理戦化 |

| RAGデータ汚染 | 外部情報に指示を埋め込む | 誤情報拡散と情報漏洩 |

| 自律エージェント | 実世界の行動を実行 | 物理・財務リスクが顕在化 |

さらに深刻なのが、自律型AIエージェントの普及です。NECや富士通が公開している事例が示すように、AIはメール送信や決済、システム操作まで担う存在になりました。ここでは誤情報の生成にとどまらず、現実世界に直接的な損害を与えるリスクが発生します。専門家は、エージェントの安全性評価にはAPI権限や業務プロセス全体を含めた検証が不可欠だと指摘しています。

こうした変化を通じて明確になったのは、AIの脅威が技術問題から経営リスクへと転化した点です。EU AI Actや日本のAI事業者ガイドラインが安全性評価を社会的義務として位置づけた背景には、AIの判断ミスが企業価値や信頼を一瞬で毀損し得るという現実があります。2026年の脅威ランドスケープは、AIを使うすべての組織に、従来とは異なる次元の備えを求めています。

マルチターン攻撃とRAG汚染がもたらす新たなリスク

マルチターン攻撃とRAG汚染は、2026年時点のAI運用において質的に新しいリスクをもたらしています。これらは単なる入力値の不正操作ではなく、AIが本来持つ「文脈理解」と「外部知識活用」という強みそのものを逆手に取る点に特徴があります。従来型のセキュリティ対策では検知が難しく、経営判断や業務プロセスにまで影響を及ぼすため、ビジネスリスクとしての認識が不可欠です。

マルチターン攻撃の本質は、AIとの継続的な対話を通じて徐々に制約を緩めさせる点にあります。Microsoftのセキュリティ研究者が報告したCrescendo攻撃では、最初は一般的な雑談や背景説明から始め、数十ターン後に有害な情報へと誘導することが確認されています。重要なのは、各ターン単体ではポリシー違反に見えない点です。**会話全体を俯瞰しなければ危険性を判断できない**ため、単発チェック型のガードレールは容易にすり抜けられます。

さらに、推論能力が高い最新モデルほど、論理的な正当化に弱い傾向が学術研究で示唆されています。ACLやNeurIPS関連論文によれば、「研究目的」「フィクション設定」といった文脈を丁寧に積み上げることで、モデルが自ら制限を再解釈してしまう事例が報告されています。これは性能向上の裏返しであり、**高度化=安全性向上ではない**という現実を突きつけています。

| 観点 | 従来型攻撃 | マルチターン攻撃 |

|---|---|---|

| 攻撃手法 | 単一プロンプト | 連続対話による誘導 |

| 検知難易度 | 比較的容易 | 文脈解析が必要 |

| 主な弱点 | キーワード検知 | 推論・協調性 |

一方、RAG汚染は「信頼できるはずのデータ」を攻撃経路に変える点で、より深刻です。Palo Alto Networksや日本のAISIが指摘する間接プロンプトインジェクションでは、Webページや社内文書に不可視の指示を埋め込み、AIが検索結果としてそれを取得した瞬間に挙動を乗っ取ります。人間のレビューを前提としたデータガバナンスでは、この種の攻撃を完全に防ぐことは困難です。

特に企業内RAGでは、「社内データだから安全」という思い込みがリスクを増幅させます。例えば、外部委託先が作成したマニュアルや過去のFAQに悪意ある記述が混入した場合、AIはそれを正解として参照します。**モデルは汚染された知識を疑わない**ため、誤情報の拡散や機密情報の不正送信といった二次被害につながります。

こうした背景から、2026年の先進的なレッドチーミングでは、対話ログ全体を評価するステートフル分析と、RAGデータソースそのものへの敵対的テストが重視されています。ISO/IEC 42001やEU AI Actが求めるのも、まさにこの統合的視点です。マルチターン攻撃とRAG汚染は、AIの知性が高まるほど顕在化するリスクであり、技術進化と同じ速度での防御進化が求められています。

自律型AIエージェント時代のセキュリティ課題

自律型AIエージェントの普及により、セキュリティ課題は従来の「不正侵入を防ぐ」段階から、「意思決定そのものをいかに安全に制御するか」という次元へと移行しています。2026年時点では、AIがメール送信、決済、業務システム操作といった実行権限を持つことが一般化し、**一度の誤判断が即座に現実世界の損害へ直結するリスク**が顕在化しています。

この変化を象徴するのが、NECや富士通が公開している自律型エージェントの検証結果です。NECのcotomi ActはWeb操作精度80%超を達成しましたが、同時に「意図しない行動」を防ぐため、ツール利用ログの常時監査と権限分離が不可欠であると報告しています。これは、**性能向上とリスク増大が表裏一体で進行している**ことを示しています。

自律型エージェント特有の課題は、人間が直接入力しない「間接的な攻撃経路」にあります。Microsoftの研究によれば、マルチターン対話を通じてエージェントの目的解釈を歪め、最終的に不正なアクションを実行させる攻撃が確認されています。従来の単発プロンプト検知では、こうした長時間・文脈依存型の攻撃を防げません。

| リスク領域 | 具体例 | 影響範囲 |

|---|---|---|

| 意思決定の逸脱 | 業務目的を誤解し不要な処理を実行 | 業務停止・品質低下 |

| 権限の悪用 | API権限を使った不正送金 | 金銭的損失 |

| 連携プロセスの脆弱性 | 複数ツール連動時の論理破綻 | 組織全体の信用低下 |

EU AI ActやISO/IEC 42001が求めているのは、まさにこの領域への対策です。PwCやBSIが指摘するように、**自律エージェントは「機能単位」ではなく「行動シナリオ単位」で評価しなければならない**とされています。そのため、攻撃者視点でエージェントの行動連鎖を検証するレッドチーミングが、法規制対応の実務要件として組み込まれました。

さらに深刻なのは、エージェント同士が連携するマルチエージェント環境です。富士通が発表した研究では、攻撃AIと防御AIを仮想空間で競合させることで、人間が想定できなかった脆弱な行動パターンが多数発見されています。これは、**人間のレビューだけでは自律型AIの安全性を保証できない**ことを裏付けています。

2026年のセキュリティ課題の本質は、「AIを止めること」ではなく、「AIがどこまで動いてよいかを常時監督すること」にあります。自律型AIエージェントは強力な労働力である一方、適切なガバナンスと継続的検証がなければ、最大の内部リスクにもなり得ます。この二面性を理解し、行動レベルでの安全設計を行える組織だけが、次のAI活用フェーズへ進めるのです。

EU AI ActとISO/IEC 42001が企業に求める対応

EU AI ActとISO/IEC 42001は、企業に対して単なる技術対策ではなく、組織としてAIリスクを管理し、その妥当性を説明できる体制を求めています。2026年時点で両者に共通する本質は、「安全に配慮しているか」ではなく、「安全性を継続的に検証・改善している証拠を示せるか」にあります。

EU AI Actでは、特に汎用目的AIや高リスクAIを扱う企業に対し、敵対的テストの実施と結果の文書化が明示的に要求されています。欧州委員会や関連する技術文書によれば、ここで想定されている敵対的テストには、想定外の利用、誤用、悪用まで含めた評価が含まれ、形式的なチェックリストでは不十分とされています。

| 観点 | EU AI Act | ISO/IEC 42001 |

|---|---|---|

| 位置づけ | 法的義務(違反時は制裁) | マネジメントシステム規格 |

| 重視点 | 社会的・基本権リスクの抑制 | 組織的リスク管理と継続改善 |

| レッドチーミング | 敵対的テストとして事実上必須 | リスク対応の有効性検証手段 |

一方、ISO/IEC 42001はAIマネジメントシステム全体の枠組みを定める国際標準であり、リスクアセスメント、役割分担、意思決定プロセス、記録管理までを包含します。BSIやJQAが公表している審査事例では、レッドチーミングを一度実施しただけでは不十分で、結果をどう是正措置につなげ、次の評価に反映しているかが重要視されています。

両者を同時に満たすための実務的な対応として、多くの先進企業が採用しているのが「リスクベース運用」です。AIの用途や影響範囲に応じて評価の深度や頻度を変え、重要なユースケースでは外部第三者による評価結果を保存・提示できる形で管理します。これはPwCやデロイトが示すベストプラクティスとも一致します。

重要なのは、これらへの対応をコンプライアンスコストとして捉えない視点です。レッドチーミングを軸にした検証体制は、規制対応であると同時に、ブランド毀損や重大事故を未然に防ぐ経営管理ツールでもあります。2026年の企業評価において、AIガバナンスの成熟度が取引先選定や市場参入の前提条件になりつつある今、EU AI ActとISO/IEC 42001への対応は、競争力そのものに直結しています。

日本のAI事業者ガイドラインとAISIの役割

日本におけるAIガバナンスの中核を成すのが、経済産業省と総務省が策定したAI事業者ガイドラインです。2026年時点では、単なる倫理指針ではなく、AIを事業として提供・利用する際の実務的な行動規範として企業活動に深く組み込まれています。

このガイドラインは、開発、提供、利用というライフサイクル全体を通じて、リスクの特定、低減、説明責任を果たすことを求めています。特に生成AIや自律型エージェントの普及を背景に、ハルシネーション、差別的出力、意図しない行動といったリスクを事前に検証する体制整備が強調されています。

| 観点 | ガイドラインの要点 | 企業への影響 |

|---|---|---|

| リスク管理 | ライフサイクル全体での継続的評価 | 開発後も運用監視が必須 |

| 説明責任 | 判断根拠や対策の文書化 | 監査・対外説明への対応力向上 |

| 体制 | 独立した評価主体の確保 | 社内ガバナンス再設計 |

この実装を具体的に支える存在が、2024年に設立されたAIセーフティ・インスティテュート(AISI)です。AISIは政府方針を踏まえつつ、現場で使える評価基準やレッドチーミング手法を体系化し、企業が参照可能な形で公開しています。

AISIが公表したレッドチーミング手法ガイドでは、評価者を開発チームから切り離した独立主体と定義し、攻撃者視点での検証を重視しています。これは国際的にも評価が高く、ISO/IEC 42001のリスク対応要求とも整合的です。実際にソフトバンクやNEC、富士通などは、AISIの考え方を踏まえた社内ガバナンス体制を構築していると公表しています。

経済産業省の有識者会合でも指摘されている通り、日本の特徴は法規制に先行してガイドラインと実装支援を組み合わせる点にあります。AISIは単なる監督機関ではなく、企業が安全なAI活用を実現するための伴走者として機能しており、この役割分担こそが日本型AIガバナンスの実効性を支えています。

AIレッドチーミングの組織設計と3線防御モデル

2026年におけるAIレッドチーミングは、個人のスキルに依存する属人的活動から、**組織設計そのものに組み込まれたガバナンス機能**へと進化しています。その中核となっているのが、金融業界で標準化されてきた3線防御モデルのAI領域への適用です。AIのリスクが技術・法務・倫理・ブランドにまたがる以上、単一部署での対応には限界があり、役割分担と牽制が効く組織構造が不可欠です。

欧州の規制当局やISO/IEC 42001の要求事項でも、リスク評価を実施する主体の独立性が強調されています。これは、開発スピードや事業目標が安全性判断を歪めることを防ぐためです。実際、PwCやデロイトのAIガバナンス実装事例によれば、**開発部門と評価部門を分離した企業の方が、重大インシデントの是正までの時間が短い**ことが報告されています。

3線防御モデルでは、第1線がAIを作り運用する現場、第2線がリスクを統制する内部レッドチーム、第3線が第三者の監査・検証を担います。この構造は、単なるチェック体制ではなく、AIのライフサイクル全体に安全性を埋め込むための設計図として機能します。

| 防御線 | 主な役割 | AIレッドチーミングでの具体像 |

|---|---|---|

| 第1線 | 開発・運用 | Security by Design、自動テスト、ガードレール実装 |

| 第2線 | リスク管理 | 独立評価、法務・倫理観点の敵対的テスト |

| 第3線 | 監査・外部評価 | 第三者レッドチーム、国際標準への適合確認 |

特に重要なのが第2線の設計です。日本のAIセーフティ・インスティテュートが示すガイドラインでも、内部レッドチームは開発部門と異なる指揮系統を持つべきだと明記されています。ソフトバンクグループやLINEヤフーが設置するAI倫理・ガバナンス組織は、**技術的に動くかではなく、社会的に許されるかを判断する最後の砦**として機能しています。

さらに2026年の特徴として、3線防御モデルが固定的ではなく、AIエージェントや自動化ツールによって補強されている点が挙げられます。第1線ではPyRITやGarakによる常時テストが稼働し、第2線はその結果を解釈・判断し、第3線が外部視点で妥当性を検証します。この分業により、**スピードと厳格さを両立したレッドチーミング運用**が可能になります。

AIレッドチーミングの成否は、どれだけ高度な攻撃を再現できるか以上に、発見されたリスクを誰が止め、誰が最終判断を下すのかという組織設計にかかっています。3線防御モデルは、AI時代における責任の所在を明確にし、企業が社会から信頼を得るための現実的かつ実践的な枠組みとして定着しつつあります。

自動化ツールと継続的レッドチーミングの実践

2026年のAIレッドチーミングにおいて、自動化ツールと継続的レッドチーミングの実践は、もはや先進企業の実験的取り組みではなく、標準的な運用要件となっています。生成AIや自律型エージェントは、モデル更新やデータ追加によって挙動が日々変化するため、年に数回の手動テストではリスクの変化に追いつけません。

この課題に対し、多くの組織が導入しているのが、PyRITやGarakといった自動化フレームワークです。Microsoftの研究者によれば、数千パターンの敵対的プロンプトを自動生成し、応答を定量評価することで、人手では見逃されがちなマルチターン攻撃や文脈依存の脆弱性を高い再現性で検出できるとされています。

| 観点 | 自動化レッドチーミング | 従来型手動テスト |

|---|---|---|

| 実施頻度 | 毎日またはモデル更新ごと | 不定期・リリース前中心 |

| 再現性 | 高い(コード化) | 低い(属人化) |

| 検出範囲 | 数千〜数万ケース | 限定的 |

さらに注目すべきは「継続的レッドチーミング」という考え方です。Citadel AIなどが提唱するこの手法では、評価指標そのものをコードとして管理し、CI/CDパイプラインに組み込むことで、モデルの再学習やRAGデータ更新のたびに自動検証を行います。安全性評価を一度きりの監査から、運用プロセスの一部へ昇華させる点が最大の特徴です。

国産ツールのTakumi byGMOでは、検出した脆弱性に対する修正パッチ案まで自動生成する機能が実装され、修正サイクルを大幅に短縮しています。GMO Flatt Securityの公開情報によれば、これにより開発チームとレッドチーム間の往復工数が減り、DevSecOpsの実効性が高まったと報告されています。

重要なのは、自動化が人間の判断を不要にするわけではない点です。AISIやISO/IEC 42001が示す通り、自動化は継続的なスクリーニングを担い、人間は高リスク事象の解釈と意思決定に集中するという役割分担が、2026年時点で最も現実的かつ効果的な運用モデルといえます。

国内主要企業に学ぶAIレッドチーミング導入事例

日本国内では、AIレッドチーミングを単なる技術検証にとどめず、経営や事業リスクと直結させる動きが明確になっています。2026年時点で先行する企業に共通するのは、法規制対応、ブランド信頼、そして自律型AI時代への備えを同時に満たす実装を行っている点です。

代表的な事例がソフトバンクグループです。同社はResponsible AIを経営のマテリアリティに位置づけ、AIガバナンスワーキンググループを中心に、リスクレベルに応じてレッドチーミングの深度と頻度を変える運用を採っています。**高リスク用途では外部専門家を含む第三者評価を必須化し、低リスク用途では自動化ツールによる継続監視に委ねる**ことで、スピードと安全性の両立を実現しています。

攻撃者視点を徹底しているのがGMOインターネットグループです。GMOサイバーセキュリティ by イエラエは、AIシステム単体ではなく、運用組織や物理環境まで含めたフルスコープのレッドチーミングを実施しています。公開事例では、疑似攻撃を通じてAIの脆弱性だけでなく、SOCやCSIRTの検知遅延といった運用上の課題も可視化しています。これはPwCなどが指摘する「技術リスクと組織リスクの統合評価」を国内で体現した例といえます。

技術主導のアプローチではNECと富士通が際立っています。NECは生成AI cotomiの開発過程で、外部のAI安全性専門企業と連携し、モデルの挙動を敵対的に検証しています。富士通はさらに踏み込み、攻撃AIと防御AIを仮想空間で競わせるマルチAIエージェント技術を実用化しました。**人間が想定できない攻撃パターンをAI自身に発見させる設計は、2026年以降の主流モデルとして国際的にも注目されています。**

顧客接点に焦点を当てた事例が東京海上日動です。保険分野ではハルシネーションが直接的な顧客被害につながるため、同社は対話型AIの回答範囲を厳密に制御し、想定外の出力を誘発するシナリオを重点的にレッドチーミングしています。AISIのガイドラインが示す「用途限定型評価」を忠実に実装した国内有数のケースです。

| 企業 | 主な焦点 | レッドチーミングの特徴 |

|---|---|---|

| ソフトバンクグループ | 全社AIガバナンス | リスクベースで頻度と深度を調整 |

| GMOインターネットグループ | 攻撃者視点の徹底 | 物理・組織を含むフルスコープ演習 |

| NEC・富士通 | 自律型AIの安全性 | マルチAIエージェントによる敵対検証 |

| 東京海上日動 | 顧客対応の信頼性 | 用途限定・ハルシネーション重視評価 |

これらの事例が示すのは、AIレッドチーミングが業界や用途ごとに異なる最適解を持つという事実です。**国内主要企業は、自社の事業特性に合わせて評価軸を明確化し、レッドチーミングを競争力の源泉へと転換しています。**その実践知は、2026年以降にAI活用を本格化させる企業にとって、極めて示唆に富むものです。

2027年を見据えた成熟度モデルと経営への示唆

2027年を見据えると、AIレッドチーミングは技術施策の完成度ではなく、経営プロセスにどこまで統合されているかで成熟度が評価される段階に入ります。EU AI Actの運用定着やISO/IEC 42001の普及により、単発の評価や形式的な対応では、監督当局や取引先、投資家の信頼を維持できなくなりつつあります。

PwCやデロイトのリスクアドバイザリーが示す共通認識は、レッドチーミングを「年次イベント」から「経営ダッシュボードの一部」へ移行させる必要性です。具体的には、AIシステムごとのリスクスコア、未解決の重大指摘数、修正までの平均リードタイムといった指標が、財務KPIと並んで経営会議に報告される状態が、2027年の到達点とされています。

| 成熟度段階 | 主な特徴 | 経営への意味合い |

|---|---|---|

| 管理型 | 自動化ツールで定期評価 | 規制対応は可能だが差別化は困難 |

| 最適化型 | 継続的・自律的レッドチーミング | リスク低減と開発速度を両立 |

| 統合型 | 経営判断と直結した運用 | 信頼を競争優位に転換 |

2026年時点で多くの先進企業は「管理型」から「最適化型」に到達していますが、2027年に差が付くのは「統合型」への移行です。ここでは、Takumi byGMOのような自動修正機能や、Microsoft PyRITによる定量評価の結果が、投資判断やサービス提供範囲の意思決定材料として使われます。

例えば、富士通が進めるマルチAIエージェント型のセキュリティ検証は、未知の脆弱性が一定回数以上検出された場合に機能制限をかける設計思想を採用しています。これは技術判断であると同時に、ブランド毀損リスクを数値で管理する経営判断でもあります。

経営層にとって重要なのは、レッドチーミング結果を「現場の報告書」で終わらせないことです。AISIのガイドラインが示すように、評価主体の独立性と結果の透明性を確保し、その示唆を人事評価、M&Aデューデリジェンス、海外展開判断にまで反映させることが、2027年以降の標準になります。

AIを活用する企業が増えるほど、事故を起こさないこと自体は差別化になりません。事故を未然に防ぐ仕組みを、経営として説明できるかが問われます。その答えとしての成熟度モデルを自社に当てはめ、どの段階にいるのかを直視することが、2027年に向けた最初の一手になります。

参考文献

- Marubeni Research:AI 規制の夜明け:国際社会が進める法的枠組みの構築とその未来

- Japan AISI:AI セーフティに関するレッドチーミング手法ガイド(第1.10版)

- Microsoft Security Blog:Jailbreaking is mostly simpler than you think

- PwC Japan:AIサービスのリスクとAIレッドチーム

- GMOサイバーセキュリティ by イエラエ:レッドチーム演習とは?基本戦略と導入効果

- NVIDIA Blog:NVIDIA Releases NIM Microservices to Safeguard Applications for Agentic AI