生成AIは、もはや一部の先進企業だけの実験的ツールではなく、日本のビジネス現場に深く浸透した社会インフラになりつつあります。文章作成、分析、開発支援など、その恩恵を実感している方も多いのではないでしょうか。

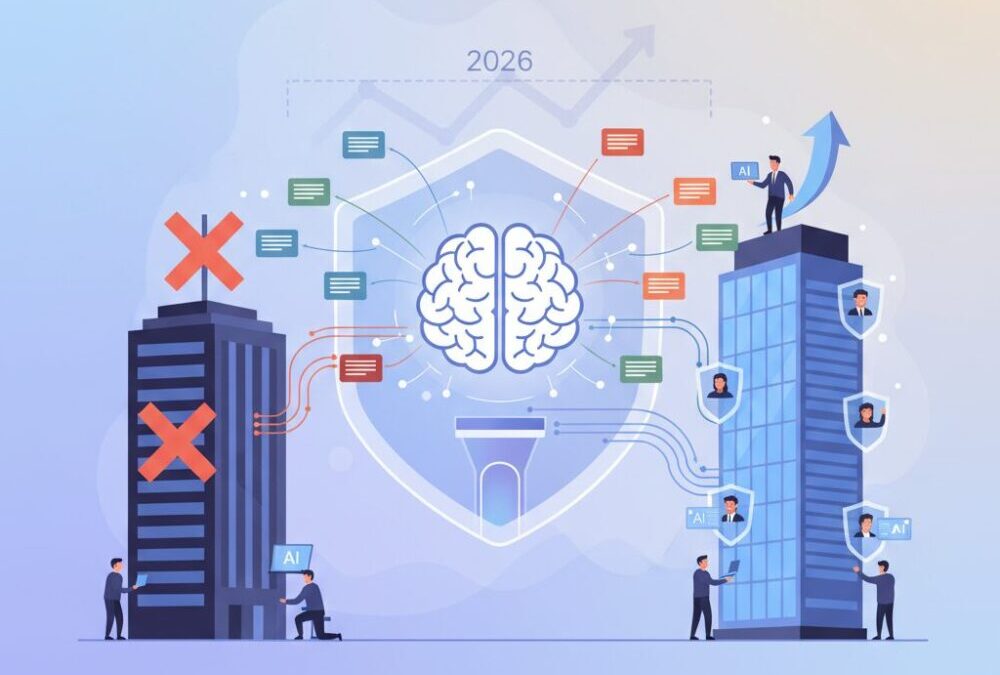

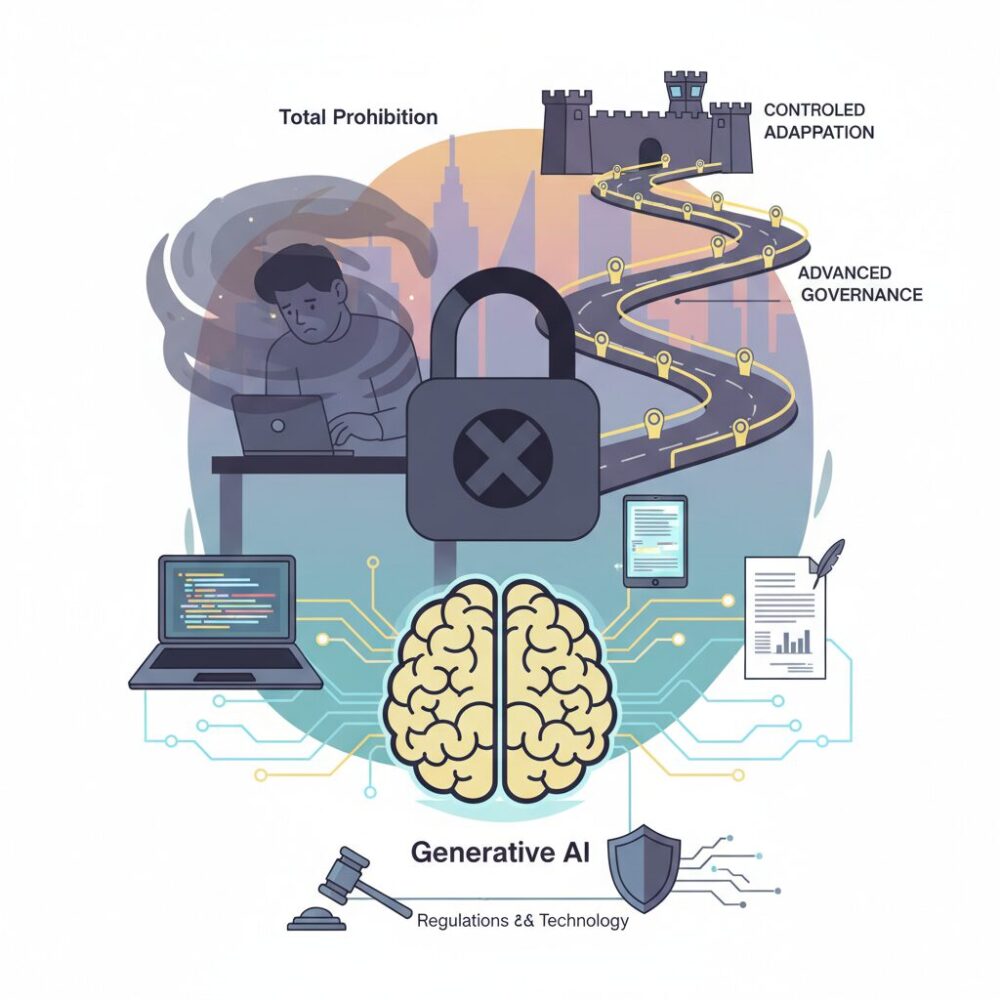

一方で、多くの企業が頭を悩ませているのが「機密情報を生成AIに入力してよいのか」という根源的な問いです。全面禁止という強いルールを敷く企業がある一方で、活用を前提にガバナンスを高度化させる企業も増え、対応は大きく二極化しています。

禁止すれば本当に安全なのか、現場で進む“見えない利用”はどんなリスクを孕むのか。そして法規制や技術は、どこまで企業を守ってくれるのか。本記事では、2026年時点の最新データや事例をもとに、生成AIガバナンスの現実と限界を整理します。

さらに、先進企業や自治体が実践する具体策から、これからの企業に求められる「制御された適応」という考え方までを俯瞰します。生成AIを恐れるのではなく、競争力に変えるための視点を得たい方にとって、必ず示唆を持ち帰っていただける内容です。

2026年の生成AIランドスケープと企業ガバナンスの分水嶺

2026年は、生成AIが実験的な業務効率化ツールから、企業活動そのものを支える基盤技術へと完全に移行した転換点です。かつては一部の先進部署や個人の工夫に委ねられていた生成AIの活用が、今や経営判断、研究開発、顧客対応といった中核業務に深く入り込み、**企業ガバナンスの在り方そのものを問い直す局面**に入っています。

独立行政法人情報処理推進機構が公表した最新調査によれば、生成AIの業務利用に関するルールを何らかの形で整備している日本企業は52.0%に達しました。一見すると管理が進んでいるように見えますが、その内訳を見ると実態は対照的です。利用を許可する企業が25.8%である一方、ほぼ同数の26.2%が全面禁止を選択しており、**「活用による競争力強化」と「リスク回避のための遮断」という二極化**が鮮明になっています。

| 生成AI利用ルールの状況 | 企業割合 | 示唆されるガバナンス姿勢 |

|---|---|---|

| 利用を許可 | 25.8% | リスク管理を前提に成長を選択 |

| 利用を禁止 | 26.2% | 不確実性を理由に防御を優先 |

| ルール未整備・不明 | 48.0% | ガバナンス不在の潜在リスク |

この分断が「分水嶺」と呼ばれる理由は明確です。生成AIはもはや使うか使わないかの選択肢ではなく、**使わないこと自体が生産性と競争力の低下を招く構造**になっているからです。PwCの国際比較調査でも、生成AIを積極的に業務へ組み込んでいる企業ほど、意思決定スピードとイノベーション創出で優位に立つ傾向が示されています。

一方で、全面禁止を選ぶ企業の判断も無理解ではありません。IPAの同調査では、過去5年間に営業秘密の漏洩を経験した、あるいは認識している企業が35.5%に達し、2020年調査の5.2%から異常とも言える増加を示しています。生成AIは入力データの取り扱いがブラックボックス化しやすく、**経営層にとっては「見えないリスク」**として恐怖の対象になりやすいのです。

しかし2026年時点で明らかになったのは、単純な禁止が必ずしも安全をもたらさないという現実です。専門家の間では、生成AIを電気やインターネットと同様の「汎用インフラ」と捉え、リスクを前提に制御する考え方が主流になりつつあります。経済産業省やデジタル庁のガイドラインも、利用そのものを否定するのではなく、契約、技術、運用の三位一体で管理する方向性を強調しています。

この問いに正面から向き合えるかどうかが、数年後の競争環境を左右します。生成AIを恐れて距離を置く企業と、ガバナンスを再設計して取り込む企業。その差は短期的な効率の違いにとどまらず、**人材の学習速度、意思決定の質、そして企業文化そのもの**にまで波及していくのです。

日本企業に広がる生成AI利用ルールの二極化

2026年現在、日本企業における生成AI利用ルールは、明確な二極化が進んでいます。独立行政法人情報処理推進機構によれば、生成AIに関する社内ルールを整備している企業は52.0%に達しましたが、その内訳を見ると「利用を許可している企業」が25.8%、「全面的に禁止している企業」が26.2%と、ほぼ拮抗しています。活用を前提に管理する企業と、リスクを理由に遮断する企業が、同時に存在している状況です。

この分断は単なるITポリシーの違いではなく、経営判断そのものの差を映し出しています。許可派の企業は、生産性向上や意思決定の高度化を目的に、入力データの制限や監査ログの整備など、条件付きでの利用を進めています。一方、禁止派の企業は、営業秘密や個人情報の漏洩リスクを重く見て、生成AIへの入力を一律に認めない姿勢を維持しています。

| 区分 | 企業の主な判断軸 | 想定しているリスク |

|---|---|---|

| 利用許可 | 生産性・競争力の向上 | 管理不全による情報漏洩 |

| 全面禁止 | コンプライアンス遵守 | 再学習や外部流出 |

全面禁止を選ぶ企業の背景には、営業秘密漏洩への強い恐怖があります。IPAの調査では、過去5年間に営業秘密の漏洩被害を認識した企業は35.5%に達し、2020年調査の5.2%から急増しました。クラウド利用の拡大や内部ルールの形骸化が進む中で、生成AIは「制御しきれない外部サービス」と見なされやすいのです。

しかし同時に、PwCの生成AI実態調査などが示すように、化学、エネルギー、物流といった分野では、生成AIを競争力の源泉と位置づける企業が着実に成果を上げています。禁止を続ける企業と、条件付きで使いこなす企業との差は、すでに業務スピードや開発力に表れ始めています。

この二極化は過渡期の現象とも言えますが、2026年時点ではまだ収束していません。むしろ、日本企業が生成AIを「危険な存在」と見るのか、「制御可能なインフラ」と捉えるのか、その認識の差が、ルールの分断として表面化しているのが実情です。

なぜ企業は機密情報入力を禁止し続けるのか

多くの企業が2026年になっても機密情報の入力禁止を解除できない最大の理由は、生成AIそのものの危険性というより、企業が負う法的・経営的責任の非対称性にあります。生成AIを使わなかったことによる機会損失は定量化しづらい一方、情報漏洩は損害額、行政指導、ブランド毀損として即座に顕在化します。このリスク構造が、意思決定を極端に保守的な方向へと押しやっています。

独立行政法人情報処理推進機構によれば、過去5年間で営業秘密の漏洩被害を認識した企業は35.5%に達しています。2020年調査の5.2%から急増しており、経営層の記憶には「漏洩は例外的事故ではなく、いつ自社で起きても不思議ではない事象」として刻まれています。この状況下で、ブラックボックス性が完全には払拭できない生成AIに機密情報を入力させる判断は、心理的にも組織的にも極めて困難です。

| 企業が禁止を続ける主因 | 具体的な懸念内容 | 判断主体 |

|---|---|---|

| 法令違反リスク | 個人情報保護法、越境データ移転規制への抵触 | 法務・コンプライアンス |

| 知財喪失リスク | 未公開技術の入力による特許新規性喪失 | 知財・研究部門 |

| 説明責任の不在 | AI事業者側の処理・学習範囲が完全に検証できない | 経営層 |

特に強い影響を与えているのが、個人情報保護と知的財産に関する規制の不確実性です。個人情報保護委員会は、生成AIサービスに入力された個人情報が再学習や二次利用される可能性について継続的に注意喚起を行っています。万一、顧客情報や従業員情報が意図せず外部に再現された場合、企業は「入力した側」として管理責任を免れません。

また、研究開発部門では別の恐怖が存在します。専門家の間では、生成AIへの入力行為が特許法上の公知性に影響を及ぼす可能性が指摘されています。未発表の発明内容をパブリックなAIに相談した結果、後の特許出願が無効になるリスクは、企業の将来価値を根底から揺るがします。このためR&D領域では、一般的な情報セキュリティ基準よりも厳しい入力禁止が維持されがちです。

さらに見逃せないのが、説明可能性と監査対応の問題です。監査法人や取引先から「そのAIに何を入力し、どこで処理され、どのように保管されているのか」と問われた際、明確に説明できない仕組みは採用しづらいというのが実務の現実です。PwCなどの調査でも、ガバナンス未整備を理由に全面禁止を選択する企業が一定数存在することが示されています。

このように、機密情報入力禁止は技術への無理解から生まれているのではありません。最悪のシナリオが一度でも発生した場合に失うものの大きさを前提に、責任ある立場ほど「使わない」という選択を合理的と判断しているのです。禁止ルールは、企業がリスクを制御できない段階における、極めて人間的で現実的な防衛反応だと言えます。

禁止ルールが招くシャドーAIという逆説

企業が生成AIのリスクを恐れ、「機密情報入力禁止」という厳格なルールを敷いたとき、皮肉にもその統制力は弱まる傾向があります。**禁止は安全を生むどころか、管理不能なシャドーAIを組織内に拡散させる**という逆説が、2026年時点で明確になっています。

IPAやPwCの調査が示す通り、全面禁止を選択する企業は約4分の1に達していますが、その裏側で従業員の行動が止まっているわけではありません。業務効率や成果へのプレッシャーが強い現場では、ルールと現実の乖離が静かに広がっています。

この乖離を数値で可視化したのが、SIGNATEの「AI活用実態調査レポート2025年12月版」です。生成AIに関心の高い層の34.8%が、会社非公認のAIツール、いわゆるシャドーAIを利用した経験があると回答しています。

| 企業ルール | 従業員の実態 | 結果としてのリスク |

|---|---|---|

| 機密情報入力を全面禁止 | 個人端末や私用アカウントでAIを利用 | ログ監査不能、漏洩検知不可 |

| 公式AIは機能制限が多い | 最新モデルを外部サービスで利用 | 再学習・越境移転リスクの増大 |

注目すべきは、シャドーAIの多くが**悪意ではなく善意から生まれている**点です。調査では、利用動機の上位に「業務効率化」「生産性向上」「新技術の試行」が並びます。従業員はルールを破るためではなく、仕事を前に進めるためにAIを使っています。

しかし、企業が提供する公式ツールが旧世代モデルであったり、利用のたびに煩雑な申請が必要だったりすると、現場は合理的に別の選択をします。**この瞬間、ガバナンスは完全に組織の視界から消えます。**

さらに深刻なのは、経営層と現場のリスク認識ギャップです。IPAの調査が指摘するように、経営層は「禁止しているから安全」と認識しがちですが、現場では日常的に非公式なAI利用が進んでいます。このズレこそが、最大のセキュリティホールになります。

禁止ルールは、遵守されて初めて意味を持ちます。**守られない禁止は、統制の幻想を生むだけ**です。生成AIが電卓や検索エンジンと同じレベルで業務に溶け込んだ2026年において、入力を止める発想そのものが現実と乖離し始めています。

この逆説が示す教訓は明確です。リスクを恐れて蓋をするほど、組織は見えない場所でより大きなリスクを抱え込みます。シャドーAIは従業員の逸脱行為ではなく、**ルール設計の失敗を映す鏡**として捉える必要があります。

経営層と現場に存在するリスク認識ギャップ

生成AIを巡るリスク管理において、2026年現在、最も深刻な課題の一つが経営層と現場のリスク認識のギャップです。経営層はルールを定めた時点で統制が効いていると判断しがちですが、現場では業務効率や成果へのプレッシャーから、その前提が静かに崩れています。

独立行政法人情報処理推進機構(IPA)の調査では、生成AI利用を「禁止」している企業が約4分の1存在しますが、同時に営業秘密漏洩の原因として「従業員のルール不徹底」が3割を超えています。これは、禁止ルールそのものが現場で十分に機能していない現実を示唆しています。

| 視点 | 経営層の認識 | 現場の実態 |

|---|---|---|

| 生成AI利用 | 禁止・制限しているため安全 | 業務上必要な場面で私的に利用 |

| 主なリスク | 外部攻撃・技術的脆弱性 | 業務遅延・成果不足 |

| 行動原理 | ルール遵守による統制 | 効率化・自己防衛 |

株式会社SIGNATEの2025年調査によれば、生成AIに関心の高い層の約35%がシャドーAIを経験しており、その多くが「業務効率化」を動機としています。ここで重要なのは、現場の行動が悪意ではなく善意と成果志向に基づいている点です。

一方、非利用者の約8割はセキュリティやコンプライアンスへの懸念を理由にAIを避けています。同じ組織内で、リスクを取ってでも前に進もうとする層と、規律を守ろうとする層が分断されている構図が浮かび上がります。この断絶は、組織文化そのものの摩擦を生みます。

経営層が想定する「静的なルール遵守モデル」と、現場が直面する「動的な業務現実」の乖離を放置すれば、ガバナンスは形骸化します。重要なのは、どちらが正しいかではなく、このギャップ自体を前提条件として捉え直すことです。

PwCの分析でも、生成AIを競争力の源泉と捉える企業ほど、現場との対話を通じてリスクを具体化し、技術的・運用的な対策に落とし込んでいると指摘されています。経営層が「見えているリスク」だけで判断する時代は終わり、見えない利用実態をどう可視化するかが、2026年の経営判断を分ける分水嶺になっています。

生成AIを巡る最新の法規制・ガイドライン動向

2026年に入り、生成AIを巡る法規制とガイドラインは「抽象的な注意喚起」から「具体的な運用要件」へと明確に進化しています。最大の特徴は、生成AIそのものを一律に規制するのではなく、入力データの性質と管理体制に責任を求める設計思想が鮮明になった点です。

日本国内では、デジタル庁と経済産業省の動きが実務上の基準点になっています。デジタル庁が2025年に公表した生成AI利活用ガイドラインでは、プロンプトを含む入力データが再学習に使われるか否かを調達段階で確認することが強く求められています。これは、AIの出力品質以前に、データの行き先を把握できないサービスは選定リスクが高いという考え方を行政が公式に示したものです。

この流れは民間企業にも波及しています。経済産業省のAIガバナンス検討会では、2026年に向けて「利用者企業が負う説明責任」の重要性が繰り返し議論されており、生成AIの利用可否を決めるだけでなく、なぜそのルールにしているのかを説明できる体制が求められています。

| 主体 | 文書・指針 | 実務への影響 |

|---|---|---|

| デジタル庁 | 生成AI調達・利活用ガイドライン | 再学習有無の確認、契約条項の明確化 |

| JDLA | 生成AI開発契約ガイドライン | 入力データと生成物の権利整理 |

| 個人情報保護委員会 | 生成AI利用に関する注意喚起 | 個人情報入力時のリスク認識強化 |

特に実務担当者に影響が大きいのが、日本ディープラーニング協会が公開した生成AI開発契約ガイドラインです。ここでは、ユーザーが入力したデータがモデル改善に使われる場合の権利帰属や、プロンプトに含まれる営業秘密の秘密保持義務が具体的に整理されています。生成AIへの入力行為そのものが契約・知財の論点になることを明確にした点は画期的です。

個人情報保護の観点では、個人情報保護委員会が引き続き強い警鐘を鳴らしています。生成AIへの入力が海外事業者のサーバーで処理される場合、越境移転の問題が生じ、本人同意や安全管理措置の説明責任が問われます。これは、マーケティング部門や人事部門が日常的にAIを使う企業ほど、無視できない論点です。

2026年の規制動向が示す本質は、「AIを使ったか」ではなく「どの情報を、どの条件で使ったか」が問われる時代に入ったという点です。

欧州ではEU AI Actが段階的に施行され、高リスク用途に対する厳格な管理義務が定義されましたが、日本のアプローチはあくまでガイドライン中心です。ただし、その分、企業側の自主的なガバナンス設計が前提となり、ルール未整備は事実上のリスク放置と評価されかねません。生成AIの法規制は、守りのコンプライアンスではなく、企業の信頼性を左右する経営課題として位置づけられつつあります。

個人情報・知的財産を巡る見落とされがちな論点

生成AIの議論では「機密情報を入力してはいけない」という総論が語られがちですが、個人情報と知的財産ではリスクの性質が本質的に異なる点は、2026年時点でも見落とされやすい論点です。両者を同一の禁止ルールで括ることが、かえってガバナンスの空洞化を招いています。

まず個人情報については、個人情報保護委員会が繰り返し注意喚起している通り、生成AIへの入力行為そのものが「第三者提供」や「越境移転」に該当する可能性があります。特に海外事業者のAIサービスでは、入力データが国外サーバーで処理される場合があり、本人同意や委託契約の整理が不十分なまま利用すると、意図せず法令違反に陥るリスクがあります。

一方で、個人情報はマスキングや匿名化によって業務活用と両立しやすいという特徴があります。氏名や連絡先を伏せた相談文、属性情報を抽象化した顧客データなどであれば、AIの分析価値を保ちながらリスクを大きく下げられます。IPAやデジタル庁のガイドラインが「入力データの加工」を現実解として位置づけているのは、この可逆性の高さに理由があります。

| 観点 | 個人情報 | 知的財産・営業秘密 |

|---|---|---|

| 主なリスク | 法令違反・本人権利侵害 | 競争優位性の喪失 |

| 回避手段 | マスキング・匿名化 | 原則入力回避 |

| 回復可能性 | 一定程度可能 | ほぼ不可逆 |

対照的に、知的財産や営業秘密は性質がまったく異なります。未公開の発明情報や設計思想、アルゴリズムの核心部分を生成AIに入力した瞬間、特許法上の新規性喪失や秘密管理性の否定につながる可能性があります。マネーフォワードなどの法務解説が指摘する通り、これは後から是正できない不可逆リスクです。

研究開発部門でありがちな「アイデア壁打ち」や「仕様相談」は特に危険です。内容が公開情報と混在していても、未発表要素が含まれていれば、それだけで知財価値が毀損する恐れがあります。知財については加工すれば安全という発想自体が成立しません。

この違いを無視して一律禁止を敷くと、現場では「どこまでがアウトなのか分からない」状態が生まれ、結果としてシャドーAI利用が横行します。2026年の実務で求められるのは、個人情報は条件付きで扱い、知的財産は原則遮断するという、リスク非対称性を前提にしたルール設計です。

生成AI時代のガバナンスは、情報を守るために使わせないことではなく、情報の種類ごとに守り方を変える知的整理から始まります。この整理を怠ることこそが、最大の見落とし穴だと言えるでしょう。

技術で守る生成AI活用:マスキング・DLP・専用環境

生成AIを業務で安全に活用するため、2026年時点で最も現実的かつ効果的とされているのが、技術による多層防御です。単なるルールや教育だけでは、シャドーAIの拡大やヒューマンエラーを防ぎきれないことが、IPAや民間調査で明らかになっています。そのため先進企業は、入力段階・通信段階・実行環境という三つのポイントに技術的なガードレールを設けています。

まず中核となるのがデータマスキングです。**個人情報や営業秘密を自動検知し、生成AIに渡る前に伏字や置換を行う仕組み**が標準化しつつあります。K2viewなどのプラットフォームでは、API通信の途中でリアルタイムにマスキングする動的方式が採用され、元データを改変せずに安全性を確保できます。欧州のプライバシー研究でも、匿名化されたデータは再識別リスクを大幅に下げると報告されており、実務と法規制の両立に寄与しています。

次に重要なのがDLPの進化です。従来はメールやUSBが監視対象でしたが、2026年のDLPは生成AIの入力欄そのものを監視します。**ブラウザ上で機密ワードや番号列を検知し、送信前にブロックや警告を出す**仕組みが実装されています。Fortraなどの製品は、社内ポリシーと連動し「社外秘」「未発表特許」などのラベル付き情報を即座に判別します。これにより、善意の従業員による“うっかり入力”を最後の瞬間で止められます。

| 技術 | 防御ポイント | 主な効果 |

|---|---|---|

| データマスキング | 入力前・通信中 | 個人情報・機密情報の匿名化 |

| DLP | 入力操作 | 誤送信・ルール違反の即時防止 |

| 専用環境AI | 実行基盤 | 外部流出リスクの物理的遮断 |

三つ目が専用環境での生成AIです。オンプレミスやプライベートクラウドで完結するAIは、**データを外部インターネットに出さないという根本的な安心感**を提供します。東芝デジタルエンジニアリングの事例では、製造現場の図面や不具合履歴を社内に閉じたままAI解析に活用しています。経済産業省やデジタル庁のガイドラインでも、再学習に使われない環境選定が高水準の基準として示されています。

重要なのは、これらを単独で使うのではなく組み合わせることです。**マスキングで内容を薄め、DLPで操作を監視し、専用環境で出口を塞ぐ**という多層構造が、禁止ルールに代わる実効性の高い解となります。技術で守られた環境を提供することが、従業員の創造性と企業の競争力を同時に守る最短ルートになっています。

実際に起きたインシデントから学ぶ教訓

生成AIを巡る議論が抽象論に陥りがちな中で、実際に起きたインシデントは極めて具体的な教訓を突きつけます。2025年前後に発生した複数の不正アクセス事案は、生成AIそのものが原因ではないにもかかわらず、AI利用時の機密情報管理の弱点を浮き彫りにしました。**重要なのは「AIだけを特別視しない」視点**です。SaaSやメール、ID管理といった既存の脆弱性が、生成AIの文脈で増幅される構造を理解する必要があります。

例えば、2025年4月のPR TIMESへの不正アクセス事案では、管理者アカウントが突破されたことで、サービス内部の情報にアクセス可能な状態が生じました。これはIPAも繰り返し指摘している通り、クラウド型サービス全般に共通するリスクです。生成AIに置き換えると、**チャット履歴やプロンプト自体が「機密情報の集積データ」になり得る**という点が最大の示唆です。IDや多要素認証の不備は、AI利用履歴の一括漏洩につながります。

中央大学で発生した教員メールアカウントの不正利用による個人情報流出も、生成AI活用企業にとって他人事ではありません。メール文面の要約や翻訳に生成AIを使うケースが一般化した現在、**入力データと生成物の双方が攻撃対象になる**という前提が不可欠です。学術機関に限らず、研究開発部門や企画部門では、未公開情報が自然文としてAIに入力される場面が増えており、攻撃者にとって価値の高い知的資産がログとして残る危険性があります。

| インシデント | 表面的な原因 | 生成AI文脈での教訓 |

|---|---|---|

| PR TIMES 不正アクセス | 管理画面の認証突破 | チャット履歴は攻撃者にとって宝庫 |

| 中央大学 メール流出 | 教員アカウントの乗っ取り | 入力データと生成物の両方が漏洩対象 |

| NTT系 基幹システム侵入 | 外部からの不正アクセス | RAG連携部分が新たな攻撃面になる |

NTTコミュニケーションズ関連の基幹システムへの不正アクセス事案は、生成AIと社内データをAPI連携する際の危うさを示しています。特にRAG構成では、検索対象データそのものは安全でも、**プロンプトインジェクションによって意図しない情報抽出が起きる可能性**があります。NISTやENISAといった国際的なセキュリティ機関も、2024年以降この種の攻撃を生成AI特有の新リスクとして明確に位置付けています。

これらの事例から導かれる最大の教訓は、**「機密情報を入力しなければ安全」という単純な発想の危険性**です。現実には、メール、SaaS、AIチャットの境界は溶けつつあり、従業員は同じ感覚で情報を扱います。IPAが示す営業秘密漏洩の約3割が「ルール不徹底」に起因しているというデータは、技術以前に運用設計の失敗を物語っています。

したがって、インシデントから学ぶべきは「禁止の強化」ではありません。**どの情報が、どの経路で、どのように蓄積・再利用され得るのかを可視化すること**こそが再発防止策になります。実際、PwCやデジタル庁のガイドラインでも、ログ管理、アクセス制御、再学習有無の確認といった横断的対策が強調されています。生成AIは新しい道具ですが、事故の本質は一貫して「見えないデータの流れ」にあるのです。

先進事例に学ぶ『攻めのガバナンス』設計

先進企業が実践する「攻めのガバナンス」とは、生成AIを制約の対象ではなく、競争優位を生み出す経営資源として前提化する設計思想に立脚しています。単なる禁止や注意喚起ではなく、どの条件下で、どの情報なら使えるのかを明確に定義し、現場が迷わず使える状態を意図的につくる点に特徴があります。

IPAの調査によれば、生成AI利用を許可している企業の多くは、情報を一律に扱うのではなく「営業秘密」「個人情報」「公開情報」などに再分類し、それぞれに異なる入力ルールを設けています。これは経済産業省やデジタル庁のガイドラインが示すリスクベースアプローチとも整合的であり、リスクの高低に応じて統制の強度を変えるという現実的な判断です。

象徴的なのが横須賀市の全庁導入事例です。同市ではLGWANという閉域ネットワーク内に生成AI環境を構築し、個人情報はマスキングしたうえで入力する運用を徹底しています。2025年時点で職員の約95%が業務効率の向上を実感しているという結果は、統制と成果が両立し得ることを示しています。

| 設計観点 | 守りのガバナンス | 攻めのガバナンス |

|---|---|---|

| 基本方針 | 原則禁止 | 条件付き許可 |

| 情報の扱い | 一律に機密 | 重要度別に分類 |

| 現場行動 | シャドーAIが横行 | 公式環境に集約 |

製造業やインフラ企業では、さらに踏み込んだ設計が進んでいます。東芝デジタルエンジニアリングのように、オンプレミスや専用クラウドで生成AIを稼働させることで、設計図面や保守記録といった高機密データを外部に出さずに活用しています。これは「入力させない」のではなく、入力しても漏れない構造を先につくるという発想の転換です。

また、PwCやJDLAが指摘するように、攻めのガバナンスでは法務・情シス・現場の分断を放置しません。契約段階で再学習の有無やログ管理を明示し、DLPやマスキング技術で技術的なガードレールを敷いたうえで、従業員教育を継続します。ルールを守らせるのではなく、守るほうが合理的だと現場が感じる設計こそが、2026年型ガバナンスの核心です。

生成AIが社会インフラ化した現在、使わない選択肢は事実上存在しません。だからこそ先進事例に共通するのは、恐怖ではなく設計でリスクを制御し、成果を取りに行く姿勢です。攻めのガバナンスは、技術論ではなく経営判断そのものとして位置づけられています。

参考文献

- ACT1:52%生成AI「利用」VS「禁止」企業で二極化 営業秘密の流出5年で急増

- PwC Japan:生成AIに関する実態調査 2025春 5カ国比較

- PR TIMES:SIGNATE、「AI活用実態調査」レポート2025年12月版を公開

- デジタル庁:行政の進化と革新のための生成AIの調達・利活用に係るガイドライン

- 日本ディープラーニング協会(JDLA):生成AI開発契約ガイドライン

- 個人情報保護委員会:生成AIサービスの利用に関する注意喚起等について