生成AIは一時的なブームを越え、今や企業の基幹業務や顧客接点に深く組み込まれる存在となりました。

しかし多くのビジネスパーソンや専門家が、「PoCは成功したが本番運用が回らない」「プロンプトの品質や安全性をどう担保すればよいのか分からない」といった新たな壁に直面しています。

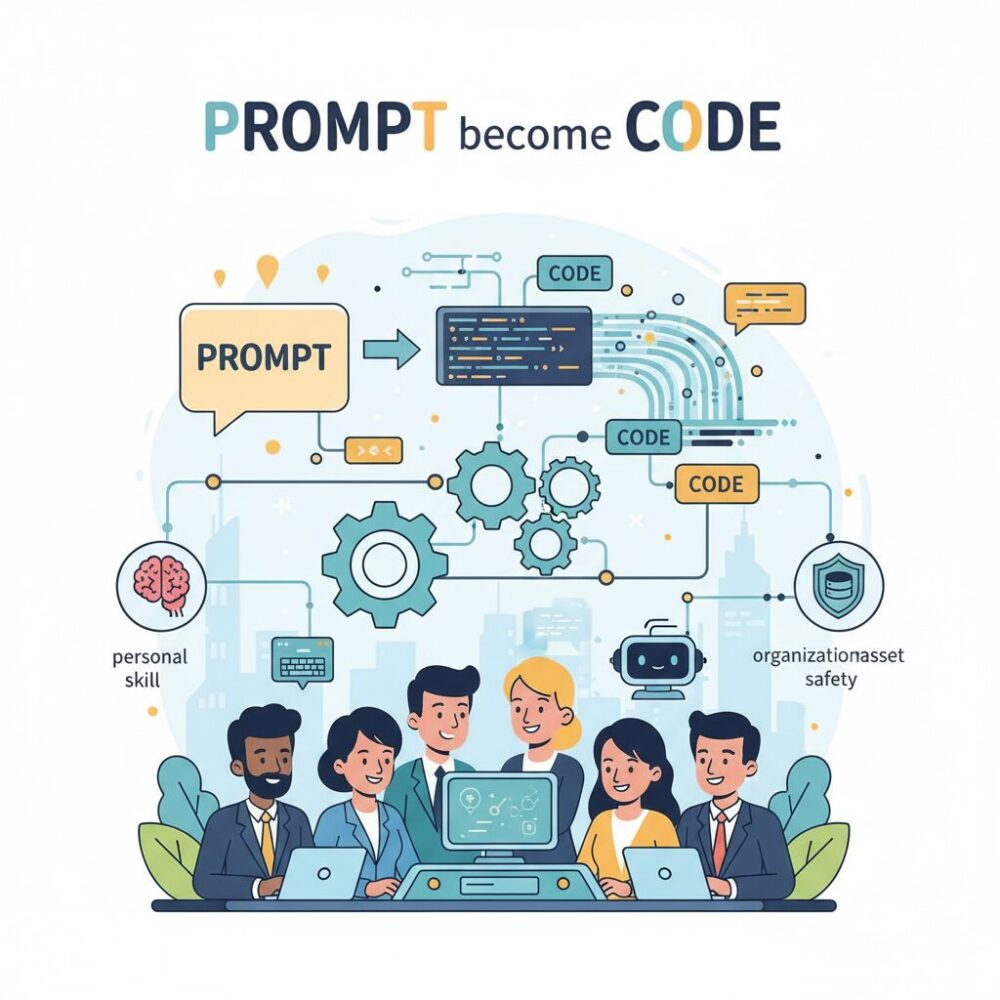

その核心にあるのが、プロンプトを“個人技”ではなく“組織資産”として管理・改善するためのPrompt Opsという考え方です。自律的に行動するAIエージェントが普及した2026年現在、プロンプトはコードやデータと同等に扱われ、評価・監視・ガバナンスまで含めた運用体制が競争力を左右しています。

本記事では、Prompt Opsの定義や技術的進化から、DSPyや自動プロンプト最適化の最新動向、国内外ツールのエコシステム、日本企業の具体事例、さらにセキュリティ規制やキャリア動向までを体系的に整理します。

読み終えたとき、Prompt Opsが単なる技術トレンドではなく、AI時代の経営基盤そのものであることを理解できるはずです。

2026年に起きたAI実装のパラダイムシフト

2026年におけるAI実装の最大の変化は、生成AIが「試してみる技術」から「止められない社会基盤」へと不可逆的に移行した点にあります。2023年から2024年にかけて主流だったPoC中心の取り組みは急速に姿を消し、現在では生成AIが基幹業務、顧客対応、意思決定支援といった企業活動の中枢に組み込まれています。**AIを使うかどうかではなく、AIを前提に業務をどう再設計するか**が問われる段階に入っています。

この転換を象徴するのが、プロンプトの位置づけの変化です。かつてプロンプトは、一部のエンジニアが経験と勘で調整する属人的なノウハウでした。しかし2026年のエンタープライズ環境では、プロンプトは組織で共有・管理される運用資産として扱われています。Mordor IntelligenceのエンタープライズAI市場分析でも、AI導入の成否はモデル性能よりも運用管理体制に左右される傾向が強まっていると指摘されています。**プロンプトはもはやメモではなく、監査可能なコードの一部**です。

この背景から登場した概念がPrompt Opsです。DevOpsやMLOpsの思想を生成AIに拡張したこのアプローチは、プロンプトの設計からテスト、デプロイ、監視、セキュリティまでを一貫して管理します。重要なのは、入力を工夫する発想から、出力の品質と再現性を保証する発想へと重心が移った点です。**正しく動き続けているかを検証できないAIは、業務に組み込めない**という現実が、このシフトを加速させました。

| 観点 | 従来(PoC中心) | 2026年の実装 |

|---|---|---|

| AIの位置づけ | 実験的ツール | 業務インフラ |

| プロンプト管理 | 個人依存 | 組織的・版管理 |

| 評価方法 | 主観的確認 | 自動評価と監査 |

さらに、エージェンティックAIの普及がこの流れを決定的にしました。AIが単発の応答ではなく、自律的に計画し、ツールを選び、複数ステップで行動するようになると、単一プロンプトの調整では全体挙動を制御できません。Stanford大学の研究でも示されているように、複数プロンプトの相互作用を前提としたオーケストレーションと監視が不可欠になっています。**Prompt Opsは複雑化したAIを制御するための工学的回答**です。

加えて、EUのAI法や日本のAIセーフティ・インスティテュートによるガイドラインが、透明性と説明責任を強く求めています。企業は、どのプロンプトが、いつ、誰によって承認され、どの出力を生んだのかを追跡できなければなりません。こうした規制要請により、Prompt Opsは効率化手法ではなく、**法令遵守と信頼確保のための必須インフラ**として位置づけられています。

このように2026年のAI実装は、技術トレンドの変化ではなく、組織の意思決定と責任構造そのものを変えるパラダイムシフトです。生成AIは実験段階を完全に終え、社会実装を前提とした運用の時代へと突入しています。

Prompt Opsとは何か:プロンプトを資産として扱う発想

Prompt Opsとは、プロンプトを一過性の指示文ではなく、企業が管理・蓄積・改善していく「運用資産」として扱うための考え方と実践体系です。2026年現在、生成AIは基幹業務や顧客接点に深く組み込まれ、出力の品質や再現性が事業成果やリスクに直結しています。その結果、プロンプトは個人のノウハウではなく、組織全体で統制されるべき対象へと位置づけが変わりました。

DevOpsやMLOpsと同様に、Prompt Opsでは設計・テスト・デプロイ・監視・改善というライフサイクル全体を扱います。重要なのは、プロンプトを変更したときに何がどう変わったのかを説明できる状態を常に保つことです。スタンフォード大学のDSPy研究が示すように、プロンプトをコード同様に構造化・バージョン管理することで、モデル変更や最適化にも耐えうる運用が可能になります。

この発想転換は、エージェンティックAIの普及によって決定的になりました。複数のプロンプトが連鎖的に実行される環境では、単一の巧妙な指示文よりも、全体として安定した振る舞いを保証する運用設計が求められます。BCGの分析でも、AI活用の成否はモデル性能よりも運用プロセスに依存する割合が年々高まっていると指摘されています。

| 観点 | 従来の発想 | Prompt Opsの発想 |

|---|---|---|

| 管理主体 | 個人 | 組織 |

| 位置づけ | メモ・試行錯誤 | 再利用可能な資産 |

| 変更管理 | 属人的 | 履歴・承認・監査可能 |

さらに、法規制とガバナンスの観点でもPrompt Opsは不可欠です。EUのAI法や日本のAIセーフティ・インスティテュートのガイドラインでは、AIの判断根拠や利用履歴の追跡可能性が求められています。どのプロンプトが、いつ、誰によって承認され、本番で使われたのかを説明できなければ、社会実装は成立しません。

つまりPrompt Opsとは、プロンプトを「書く技術」ではなく、「育て、守り、証明する仕組み」へと昇華させる概念です。この視点を持てるかどうかが、2026年以降のAI活用における競争力の分水嶺になります。

エージェンティックAIがPrompt Opsを必須にした理由

エージェンティックAIの登場によって、Prompt Opsは選択肢ではなく必須条件になりました。理由は単純で、自律型AIは「単発の指示」ではなく「連鎖する意思決定の集合体」だからです。従来の生成AIは、人が投げた一つのプロンプトに対して一つの応答を返す存在でした。しかし2025年以降に普及したエージェンティックAIは、目標を受け取ると自ら計画を立て、複数のプロンプトを内部で生成・実行し、外部ツールを呼び出しながら行動します。

この構造では、どこか一つのプロンプトが不適切であるだけで、誤った判断が連鎖的に増幅されます。BCGが指摘するように、自律性が高まるほどAIは人間の介入頻度が下がり、その分「初期設計と運用管理の品質」が成果を左右します。つまり、プロンプトはもはや調整対象ではなく、システム全体のリスクと価値を決める制御点になったのです。

| 観点 | 従来型生成AI | エージェンティックAI |

|---|---|---|

| プロンプトの役割 | 応答品質の改善手段 | 行動と意思決定の設計図 |

| 失敗時の影響 | 単発の誤回答 | 誤判断の連鎖・業務影響 |

| 管理の必要性 | 個人レベルで対応可能 | 組織的な運用管理が必須 |

この変化を裏付けるのが、スタンフォード大学のDSPy研究や、マルチエージェント評価に関する近年の論文です。複数エージェントが協調する環境では、個々のプロンプト品質よりも、バージョン管理、評価指標、回帰テストといった運用レイヤーの有無が、意思決定品質に強く相関することが示されています。特にDecision Qualityのような指標は、人間評価と高い一致率を示し、Prompt Opsなしでは自律改善が成立しないことを明確にしています。

さらに無視できないのがガバナンスの問題です。EUのAI法や日本のAISIガイドラインでは、AIの判断根拠と変更履歴の追跡可能性が求められています。エージェンティックAIが誤った行動を取った場合、「どのプロンプトが、いつ、誰によって変更されたのか」を説明できなければ、企業は法的・社会的責任を果たせません。Prompt Opsはエージェントの自由度を高めるための仕組みではなく、自由度を安全に封じ込めるための枠組みでもあります。

トヨタコネクティッドやメルカリの事例が示す通り、先進企業はすでにプロンプトをコードとして扱い、評価と監査を前提に運用しています。これは効率化のためではなく、自律型AIを事業に組み込むための最低条件だからです。エージェンティックAIの時代において、Prompt Opsを欠いた運用は、ブレーキのない自動運転と同義だと理解する必要があります。

プロンプトはコードになる:DSPyとプログラマティック・プロンプティング

DSPyは、スタンフォード大学の研究チームが提唱したフレームワークで、2026年のPrompt Opsを語るうえで避けて通れない存在です。最大の特徴は、プロンプトを人間が書く文章ではなく、システムの振る舞いを定義するコードとして扱う点にあります。従来のように自然言語の文字列を直接編集するのではなく、入力と出力の関係を宣言的に定義し、最終的なプロンプト生成はコンパイラに委ねます。

この考え方は「プログラマティック・プロンプティング」と呼ばれ、プロンプトエンジニアリングを職人技から工学へと引き上げました。DSPyでは、シグネチャとモジュールという抽象概念を用いてLLMの役割を定義します。開発者は「質問を受け取り、根拠付きで回答する」といった仕様だけを記述し、具体的な言い回しやFew-Shot例は書きません。

その役割を担うのがテレプロンプターと呼ばれる最適化コンポーネントです。スタンフォード大学の公開研究によれば、テレプロンプターは訓練データと評価指標をもとに、最適なプロンプト構造や例示を自動探索します。これにより、モデル変更時にも人手での書き直しが不要となり、再最適化を実行するだけで済みます。

| 観点 | 従来手法 | DSPy |

|---|---|---|

| 管理単位 | 文字列プロンプト | モジュールとシグネチャ |

| 最適化 | 人手の試行錯誤 | 自動探索と評価駆動 |

| モデル変更対応 | 全面修正が必要 | 再コンパイルで対応 |

2025年に公開されたarXiv論文では、DSPyで最適化したプロンプトが、人手で作成したプロンプトを大きく上回る精度を示したと報告されています。特にコード生成やハルシネーション検出のタスクでは、正答率が40%台から60%台へと改善しました。さらに注目すべきは、7億パラメータ級の小規模モデルでも、大規模モデルに匹敵する推論性能を発揮した点です。

これはコスト最適化の観点でも重要です。高価な巨大モデルに依存せず、評価指標と最適化ロジックを資産化することで、組織全体のAI運用効率が向上します。DSPyの思想は、Prompt Opsが単なるプロンプト管理ではなく、再現性と監査性を備えたエンジニアリング領域であることを明確に示しています。

自動プロンプト最適化(APO)の主要アプローチ

自動プロンプト最適化(APO)は、2026年のPrompt Opsにおいて中核技術として位置づけられています。人間の勘や試行錯誤に依存していたプロンプト改善を、再現可能なアルゴリズムに置き換えることで、品質とスケーラビリティを同時に実現する点が最大の価値です。

2025年から2026年にかけて発表された複数のサーベイ論文によれば、APOは主に三つのアプローチに体系化されています。いずれも「評価→改善→再評価」を自動で回す点は共通していますが、最適化の考え方は大きく異なります。

第一のアプローチが、LLM自身を最適化主体として用いる方法です。Google DeepMindのOPROに代表されるこの手法では、モデルに出力結果を自己評価させ、誤りの原因分析とプロンプト修正を繰り返します。人間では言語化しにくいニュアンス調整を内省プロセスとして吸収できる点が特徴で、複雑な自然言語タスクとの相性が良いと報告されています。

第二が勾配ベースの最適化です。プロンプトを単語列ではなく連続的なベクトルとして扱い、誤差逆伝播によって最適化します。スタンフォード大学の研究でも、ソフトプロンプトを用いた手法は、限定タスクにおいてフルファインチューニングに匹敵する性能を示しています。一方で、生成されるプロンプトは人間が読めない場合が多く、ガバナンスや説明責任が重視される日本企業では用途が限定的です。

第三が進化的アルゴリズムです。複数のプロンプトを個体として扱い、評価スコアの高いものを選択・交叉・変異させます。この方法は探索空間が広く、局所最適に陥りにくい利点があります。特に、正解が一つに定まらない創造的タスクで有効性が確認されています。

| アプローチ | 強み | 主な適用領域 |

|---|---|---|

| LLM自己最適化 | 言語的柔軟性が高い | FAQ、要約、対話 |

| 勾配ベース | 高精度・省パラメータ | 分類、抽出 |

| 進化的手法 | 多様解探索に強い | 企画、生成系タスク |

BCGの分析によれば、2026年に競争優位を持つ企業は、これらを単独で使うのではなく、評価指標に応じて組み合わせています。APOの本質は手法選択そのものではなく、適切な評価関数を設計できるかにあります。自動化された最適化は、評価が曖昧であれば誤った方向に高速で進むからです。

そのため現在の先進企業では、Decision Qualityのようなビジネス価値に直結する指標を定義し、APOをその下位レイヤーとして位置づけています。自動プロンプト最適化は魔法ではなく、評価設計を前提とした工学的プロセスとして理解される段階に入っています。

評価指標の進化とDecision Qualityという考え方

生成AIの業務実装が進むにつれ、「どれだけ賢く答えたか」ではなく、**「その出力が意思決定の質をどれだけ高めたか」**が厳しく問われるようになっています。

この背景には、自動プロンプト最適化やエージェンティックAIの普及があります。アルゴリズムが自律的にプロンプトを改善する時代において、人間の感覚的な良し悪しではなく、機械が参照可能な評価指標が不可欠になりました。

従来使われてきたBLEUやROUGEなどの指標は、文面の類似度を測るには有効でしたが、ビジネス文脈では致命的な欠点がありました。表現が違っても正しい判断を導く回答や、逆に流暢でも誤った判断を招く回答を区別できなかったのです。

| 評価観点 | 従来指標 | Decision Quality |

|---|---|---|

| 測定対象 | 文面の一致度 | 意思決定への貢献度 |

| ビジネス適合性 | 低い | 高い |

| 自動最適化との相性 | 限定的 | 非常に高い |

こうした課題への回答として注目されているのがDecision Quality(DQ)です。DQは、AIの出力を「判断材料」として捉え、その有効性を多面的に評価します。

具体的には、妥当性、具体性、正確性という三つの軸で構成されます。単に正しい情報を含んでいるかだけでなく、**そのまま行動に移せる水準かどうか**が重視される点が特徴です。

この考え方の実用性は、学術研究と実務の両面で検証が進んでいます。インシデント対応を題材にしたスタンフォード大学や関連研究者の検証では、DQスコアによる自動評価がSREなどの専門家評価と高い相関を示したと報告されています。

また、日本企業でも実装が始まっています。トヨタコネクティッドやメルカリでは、想定質問と正解をセットにしたゴールデンクエリを用意し、DQに基づく回帰テストを継続的に実行しています。これにより、プロンプトやモデルを更新しても意思決定品質が劣化しないことを保証しています。

重要なのは、DQが評価の終点ではなく、改善の起点になる点です。評価結果がそのまま自動プロンプト最適化のフィードバックとして使われ、システムが自己改善ループを回します。評価指標そのものが、Prompt Opsの中核的な設計要素へと昇格したと言えます。

2026年時点で、生成AIの競争力を分けるのはモデル性能よりも評価設計です。**何を「良い判断」と定義するか**を言語化できる組織だけが、AIを安定した意思決定基盤として運用できる段階に入っています。

2026年のPrompt Opsツールエコシステム最新図

2026年時点のPrompt Opsツールエコシステムは、単一の万能ツールではなく、役割ごとに分化した複層的な構造として理解することが重要です。PoC中心だった2024年頃と比べ、現在は設計・開発・評価・監視・ガバナンスまでを前提とした実運用向けの構成が主流となっています。特に自律型AIやエージェンティックAIの普及により、ツール間連携を前提としたエコシステム全体最適が競争力を左右しています。

全体像を俯瞰すると、Prompt Opsツールは大きく「設計・生成」「実行・オーケストレーション」「可観測性・評価」「ガバナンス・セキュリティ」という4層に整理できます。スタンフォード大学のDSPy研究が示したように、プロンプトは人が書く文章ではなく、最適化され続ける構成要素として扱われるようになりました。その結果、設計層と評価層を強く結びつけるツールが中核的な位置を占めています。

| レイヤー | 主な役割 | 代表的ツール群 |

|---|---|---|

| 設計・生成 | プロンプトの構造化と自動最適化 | DSPy、APO系フレームワーク |

| 実行・統合 | RAGやエージェントの実行制御 | Dify、LangChain系基盤 |

| 可観測性・評価 | 品質・コスト・挙動の可視化 | Langfuse、PromptLayer |

| ガバナンス | 監査・承認・セキュリティ対応 | 国産統合基盤、SIer提供環境 |

この構造の中で2026年に顕著なのは、可観測性と評価がエコシステムの重心になっている点です。Langfuseのようなツールは、トークン消費量やレイテンシだけでなく、エージェントの思考連鎖や中間生成物まで追跡可能にしました。これはGoogle SREの思想をAI領域に拡張した動きであり、AIをブラックボックスとして扱わないという業界共通認識の表れです。

また、日本市場ではこのエコシステム図に独自の補助線が引かれています。富士通や日立、PKSHA Technologyが提供する統合プラットフォームは、複数レイヤーを一体で提供し、監査ログや承認フローを標準装備しています。これはEU AI法やAISIガイドラインへの対応を前提とした設計であり、海外の開発者主導型ツールとは思想が異なります。

結果として、2026年のPrompt Opsツールエコシステム最新図は、技術選定の地図であると同時に、企業のAI成熟度を測る診断表でもあります。どのレイヤーを自社で担い、どこを外部ツールやパートナーに委ねるのか。その選択こそが、AIを実験で終わらせるか、社会実装の基盤に昇華できるかを分ける決定的な分岐点になっています。

日本企業に見るPrompt Ops実践事例

日本企業におけるPrompt Opsの実践は、単なる技術導入ではなく、既存業務プロセスや組織文化とどう接続するかに重点が置かれている点が特徴です。特に2026年時点では、プロンプトを「現場で使われ続ける運用資産」として管理する発想が定着しつつあります。

象徴的なのがトヨタコネクティッドの取り組みです。同社はデジタル取扱説明書に生成AIを組み込むにあたり、Prompt Opsを通じてハルシネーション抑制と説明責任を両立させました。スタンフォード大学を中心としたLLMOps研究でも参照されるこの事例では、プロンプトのバージョン管理と自動評価を厳密に行い、どの回答がどの指示文から生成されたのかを常に追跡可能にしています。

| 企業名 | 適用領域 | Prompt Opsの主眼 |

|---|---|---|

| トヨタコネクティッド | 顧客向けサポート | 安全性・再現性の担保 |

| メルカリ | 社内業務・プロダクト開発 | 評価駆動による継続改善 |

| リクルート | 人事・採用業務 | 標準化と属人性排除 |

メルカリの事例も、日本的なPrompt Opsの成熟を示しています。同社は「評価駆動開発」を軸に、プロンプト変更が業務KPIに与える影響を自動計測する仕組みを構築しました。これはソフトウェア工学のテスト駆動開発を応用したもので、人間の感覚に頼らず、数値でプロンプト品質を判断する点が評価されています。このアプローチはFOSSASIA Summitでも共有され、国際的にも注目を集めました。

一方、リクルートではPrompt Opsが人材業務の標準化に貢献しています。採用担当者ごとに異なっていた文章作成や要件定義を、検証済みプロンプトとして集中管理し、定期的に更新しています。これにより、担当者の経験差によるアウトプット品質のばらつきが大幅に縮小しました。経済産業省のAIガバナンス指針でも示されている通り、プロンプトの統制はリスク管理そのものであり、日本企業では特に重視されています。

これらの事例から見えてくるのは、日本企業がPrompt Opsを「攻めの生産性向上」と「守りのガバナンス」を同時に満たす仕組みとして位置づけている点です。生成AIを現場に根付かせるための実践知が、国内企業の中で着実に蓄積されています。

セキュリティ・ガバナンス要件とPrompt Opsの役割

生成AIが基幹業務に深く組み込まれた2026年、セキュリティとガバナンスは「後付けの対策」ではなく、Prompt Opsの中核的な設計要件として位置づけられています。特にエージェンティックAIの普及により、AIが自律的に判断しツールを操作する場面が増えたことで、**プロンプト自体がリスクの起点になり得る**という認識が企業間で共有されるようになりました。

この背景には、EUのAI法や日本のAIセーフティ・インスティテュートによるガイドラインが求める透明性・説明責任があります。AIがどの判断を、どのプロンプト定義に基づいて行ったのかを説明できなければ、法令遵守も事故対応も成立しません。Prompt Opsは、プロンプトのバージョン管理、承認フロー、監査ログを通じて、意思決定の来歴を追跡可能にする役割を担います。

実務上、特に重要視されているのがプロンプトインジェクション対策です。OWASPが公表するLLM向けトップリスクでも最上位に挙げられており、AISIのレッドチーミング手法ガイドでも必須検証項目とされています。Prompt Opsでは、設計段階から防御用プロンプトやガードレイヤーを組み込み、更新のたびに自動テストを回す運用が一般化しています。

| ガバナンス要件 | Prompt Opsでの対応 | 実務上の効果 |

|---|---|---|

| 説明責任 | プロンプトの履歴管理と監査ログ | 判断根拠の迅速な開示 |

| 不正入力耐性 | 自動レッドチーミングと検知ルール | 攻撃の事前封じ込め |

| 権限統制 | エージェントごとの権限制限 | 過剰な自律行動の防止 |

経済産業省やデジタル庁の政府調達要件では、人間による監視やアクセス制御の実装証明が求められています。これは民間調達にも波及しており、**Prompt Opsはコンプライアンス対応のための実装証跡を提供する装置**として機能します。単に安全なAIを作るだけでなく、安全であることを示し続けることが、競争力そのものになっているのです。

結果として、Prompt Opsは開発効率化の手法から、企業全体のリスクマネジメント基盤へと進化しました。セキュリティとガバナンスを前提にプロンプトを運用できる組織だけが、生成AIを安心してスケールさせられる段階に入っています。

市場動向とキャリア視点で見るPrompt Opsの未来

Prompt Opsを市場動向とキャリアの両面から見ると、2026年は明確な転換点に位置づけられます。かつて生成AIは実験的投資の対象でしたが、現在は基幹業務を支えるインフラとして扱われています。この変化に伴い、プロンプト運用を体系化するPrompt Opsは、企業価値を左右する必須機能として認識されるようになりました。**単なる効率化ではなく、リスク管理と競争優位の源泉**として評価されている点が特徴です。

市場調査会社Mordor Intelligenceなどの分析によれば、エンタープライズAI市場は年率30%超の成長が見込まれており、その中でも運用・管理領域への投資比率が急上昇しています。特にエージェンティックAIの普及により、複数プロンプトや評価指標を統合管理できる体制が不可欠となり、Prompt Ops関連ツールやマネージドサービスへの需要が拡大しています。日本市場ではSIer主導の包括提供モデルが多く、運用設計そのものを外部と共同で構築するケースも増えています。

| 観点 | 2023–2024 | 2026年 |

|---|---|---|

| 市場の位置づけ | PoC中心 | 社会実装・基幹化 |

| 投資対象 | モデル性能 | 運用・評価・ガバナンス |

| Promptの扱い | 個人スキル | 組織資産 |

この市場変化はキャリアにも直結しています。Prompt Engineerという呼称は残りつつも、その内実は大きく変化しました。現在評価されるのは文章作成能力ではなく、評価指標設計、CI/CDへの組み込み、監査対応まで含めた運用設計力です。BCGの人材レポートでも、AI時代に価値を持つ人材像として「技術と業務を横断できるオペレーター型人材」が強調されています。

日本国内の年収データを見ても、Prompt Opsを担える人材は800万〜1200万円帯が中心となり、AIガバナンスや戦略設計まで担える層は1500万円超の水準に達しています。**重要なのは、Prompt Opsが一過性の職種ではなく、AI時代の標準的な運用スキルとして定着しつつある点**です。今後は「AIエージェントを管理する管理職」としての役割も拡張し、人とAIの協働を設計できる人材が、最も持続的な市場価値を持つと考えられます。

参考文献

- Mordor Intelligence:Enterprise AI Market – Share, Trends & Size 2025 – 2030

- Stanford HAI:DSPy: Compiling Declarative Language Model Calls into State-of-the-Art Pipelines

- arXiv:A Systematic Survey of Automatic Prompt Optimization Techniques

- Langfuse:LLM Observability & Application Tracing Documentation

- Japan AI Safety Institute (AISI):Guide to Red Teaming Methodology on AI Safety

- Mercari AI:LLMOps for Eval-Driven Development at Scale