生成AIや自律型エージェントが業務の中核を担うようになった今、データ品質は単なるIT管理の話ではなく、企業価値そのものを左右する経営テーマへと変化しています。かつては多少の欠損や揺らぎがあっても、人間の判断力が最後の砦となっていましたが、AI中心の意思決定プロセスではその余地はありません。

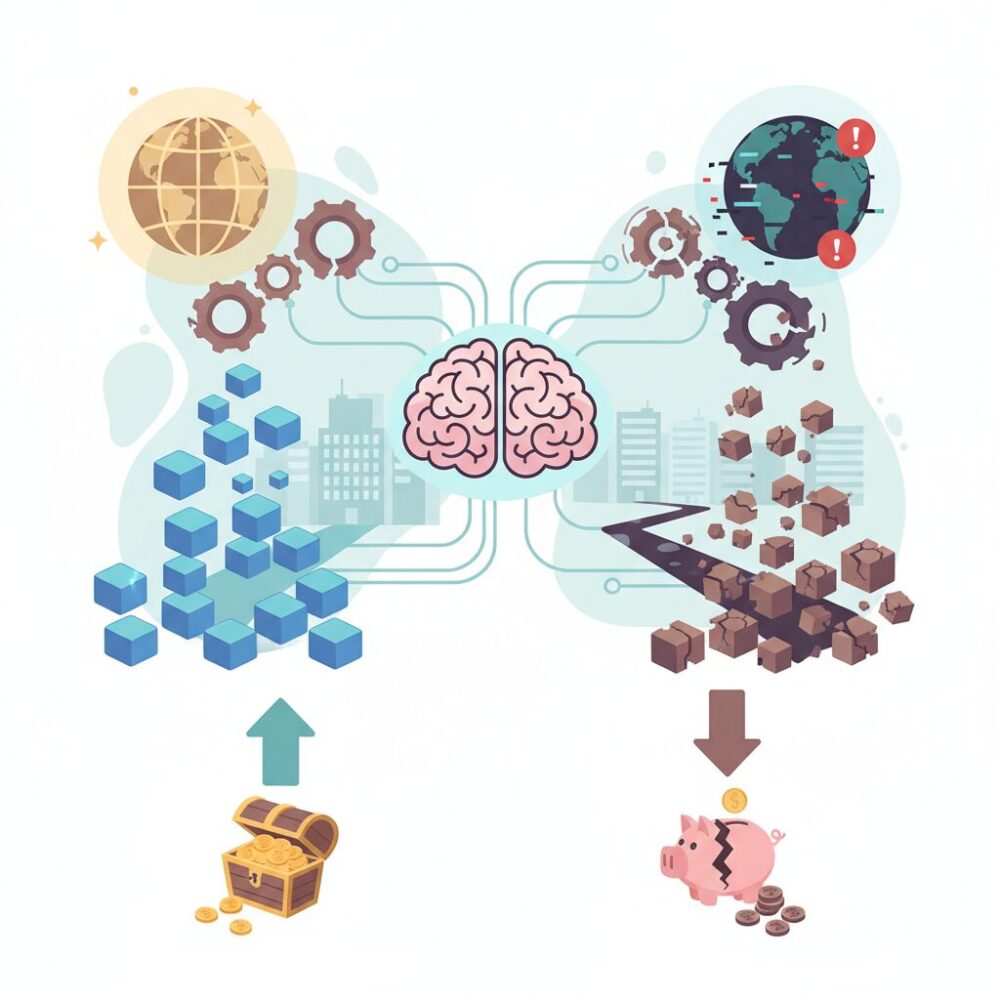

2026年現在、低品質なデータはAIのハルシネーションや誤判断を引き起こし、瞬時に大きな経済損失や信頼低下につながるリスクをはらんでいます。一方で、高品質なデータ基盤を持つ企業は、AIを競争優位の源泉として活用し、生産性と意思決定スピードを飛躍的に高めています。

本記事では、国内外の最新統計や実際に起きたインシデント、研究結果を交えながら、2026年におけるデータ品質の再定義と経済的インパクトを整理します。さらに、日本企業が直面する固有の課題や、生成AI時代に求められるデータ品質管理の進化、そして次の一手までを俯瞰的に解説します。AI活用を本気で成果につなげたい方にとって、読み終えた瞬間から行動に移せる視点を得られる内容です。

2026年に変わったデータ品質の定義とパラダイムシフト

2026年現在、データ品質の定義は根本から書き換えられました。かつてのデータ品質は、人間が読むレポートやダッシュボードの正確性を担保するためのものでした。多少の欠損や表記揺れがあっても、人間が文脈を補完することで実務は成立していました。しかし、生成AIや自律型エージェントが意思決定の主体となった今、その前提は完全に崩れています。

大規模言語モデルやエージェント型AIは確率論的に推論するため、入力データのわずかな矛盾や曖昧さにも極端に敏感です。人間なら無視できるノイズが、AIにとっては致命的な推論エラーやハルシネーションの引き金になります。データ品質はもはや「管理の良し悪し」ではなく、「AIの知能そのものを規定する要因」へと昇格したと言えます。

この変化を象徴するのが、Techment社が指摘するモデル中心からデータ中心への転換です。2026年には基盤モデルの性能差が縮小し、競争優位の源泉はどのモデルを使うかではなく、どれだけ高品質で一貫したデータを与えられるかに移りました。つまり、データ品質はバックオフィスのコストではなく、AI戦略の中核資産として再定義されたのです。

| 旧来の定義 | 2026年の定義 |

|---|---|

| 人間が読むための正確性 | AIが誤推論しないための完全性と一貫性 |

| 中央集権的な管理 | エッジやマルチクラウドを含む分散前提 |

| 形式的なチェック | 意味と文脈を含むセマンティック品質 |

定量データもこのパラダイムシフトを裏付けています。IDCによれば、エンタープライズデータの75%はエッジで生成・処理される段階に入りました。Gartnerは、80%の組織がマルチクラウド環境にあるとしています。データはもはや一か所に集めて整えるものではなく、生成される瞬間から品質を保証する必要があります。

さらにGartnerは、分析クエリの40%が自然言語で行われると報告しています。自然言語分析では、売上や顧客といった言葉の定義がメタデータとして明示されていなければ、AIは自信満々に誤った数値を返します。正確性だけでなく、意味が機械に理解可能であることが品質要件に追加された点は、2026年を象徴する変化です。

人材不足も品質定義を変えました。ManpowerGroupの調査では、APAC地域の77%の企業がデータ人材不足に直面しています。人手によるクレンジングやチェックはもはや持続不可能であり、品質は人の努力ではなく、設計と自動化で担保されるべきものへと移行しました。

加えて、世界144カ国でデータプライバシー法が施行され、世界人口の82%がその対象となっています。GDPRなどの規制により、不正確な個人データを保持すること自体がリスクになりました。2026年のデータ品質とは、AIの推論精度、事業スピード、そして法的安全性を同時に支える基盤であり、その定義は不可逆的に拡張されたのです。

AI中心社会でデータ品質が経営課題になった理由

2026年においてデータ品質が経営課題へと格上げされた最大の理由は、企業活動の意思決定主体が人間からAIへと移行した点にあります。従来、データは人間が読み、解釈し、最終判断を下すための材料でした。そのため多少の欠損や表記揺れがあっても、人の経験や文脈理解が補正装置として機能していました。

しかし現在、生成AIや自律型エージェントが価格設定、需要予測、与信判断、顧客対応といった業務の中核を担うようになり、この緩衝地帯は消失しています。確率論的に動作するAIは、入力データの微細な矛盾や曖昧さを人間のように解釈で埋めることができず、誤った推論を高い自信をもって実行してしまいます。ハーバード大学の研究が示すように、AIの誤回答の多くはモデル性能ではなく、学習・参照データの品質に起因しています。

加えて、データが生成・利用される環境そのものが複雑化しています。IDCによれば、エンタープライズデータの大半はエッジで生成され、Gartnerは企業の80%がマルチクラウド環境にあると指摘しています。この結果、企業内には異なる定義や粒度を持つデータが分散し、どのデータが「正」と言えるのかを説明できない状態が常態化しました。これは単なるITの問題ではなく、経営判断の前提条件が揺らいでいることを意味します。

| 変化要因 | 2026年の状況 | 経営への影響 |

|---|---|---|

| 意思決定主体 | AI・自律型エージェント | データ品質が判断精度を直接左右 |

| データ環境 | エッジ・マルチクラウド | 全社的な一貫性確保が困難 |

| 人材状況 | データ人材の慢性的不足 | 手作業の品質管理が限界に |

さらに深刻なのは経済的インパクトです。Gartnerはデータ品質不良による年間損失を平均1,290万ドルと試算してきましたが、AIが誤った判断を高速かつ大規模に実行する現在、この数値は実態を過小評価している可能性があります。誤った在庫補充や価格変更が自動で連鎖すれば、数分で億単位の損失が発生し得ます。

法規制の観点でも、データ品質は無視できません。世界人口の8割以上をカバーするデータプライバシー法の下では、不正確な個人データを保持していること自体がリスクと見なされます。正確に把握できない、削除できないデータは、企業にとって潜在的な負債となります。

このように2026年のデータ品質は、分析精度の問題ではなく、AIの行動、企業価値、法的責任を同時に左右する基盤となりました。だからこそデータ品質は、バックオフィスの改善テーマではなく、経営が直接向き合うべき戦略課題として位置付けられるようになったのです。

最新統計が示すデータ品質を巡る市場環境とリスク

2026年の最新統計は、データ品質を巡る市場環境が量的拡大と同時に、質的リスクを急速に高めていることを示しています。IDCによれば、エンタープライズデータの約75%がエッジ環境で生成・処理される段階に入り、データはもはや一元管理できる存在ではなくなりました。センサーやモバイル、IoT機器から発生するデータは即時性が高い一方で、欠損やノイズを含みやすく、**品質劣化がリアルタイムで意思決定に伝播する危険性**を孕んでいます。

さらにGartnerの調査では、80%の組織がマルチクラウドを利用しているとされ、クラウド間でのデータ定義やメタデータの不整合が常態化しています。これは単なる運用上の煩雑さではなく、AIや分析基盤に誤った前提条件を与える構造的リスクです。Gartnerが指摘するように、分析クエリの40%が自然言語で生成される時代においては、**データの意味が曖昧なまま民主化されること自体が経営リスク**となります。

人材不足も市場環境を不安定化させています。ManpowerGroupによると、APAC地域の77%の企業がデータ・IT人材の不足を訴えており、従来型の人力クレンジングや目視チェックは限界に達しています。この状況下で無理にAI活用を進めると、検証されていないデータが学習や推論に使われ、誤判断を高速かつ大規模に増幅させるリスクが高まります。

| 主要統計 | 2026年時点の数値 | データ品質上のリスク |

|---|---|---|

| エッジ生成データ比率 | 約75% | 分散環境での品質監視不足、即時判断エラー |

| マルチクラウド利用率 | 80% | メタデータ断絶による意味解釈の不一致 |

| 自然言語クエリ比率 | 40% | 定義曖昧な指標の誤用・誤回答 |

加えて、Amplitudeの調査では41%の組織がデータの一貫性に課題を抱えていると報告されています。一貫性を欠いたデータは、AIにとっては矛盾した世界認識そのものです。**誤ったデータは沈黙するのではなく、もっともらしい誤答として表出する**ため、経営層が異常に気づいた時点ではすでに損失が発生しているケースも少なくありません。

規制面の圧力も無視できません。世界の82%の人口をカバーするデータプライバシー法制の下では、不正確な個人データを保持しているだけでコンプライアンス違反となり得ます。データ品質は効率化のための投資ではなく、**市場環境そのものが企業に強制するリスク管理要件**へと変化しています。最新統計が示すのは、データ品質を軽視する企業ほど、競争力だけでなく存続可能性そのものを失う時代に入ったという厳しい現実です。

データ品質の低下が生む経済損失と企業価値への影響

データ品質の低下がもたらす影響は、もはや業務効率の悪化にとどまりません。2026年現在、低品質データは直接的かつ測定困難な形で企業の経済価値を毀損する要因として認識されています。Gartnerの研究によれば、データ品質不備による企業の平均年間損失額は約1,290万ドルと推計されていますが、生成AIや自律型エージェントが意思決定を担う環境では、この数字は実態を過小評価している可能性が高いと指摘されています。

最大の変化は、損失が「局所的・遅延的」から「全社的・瞬間的」へと転換した点です。例えば、価格設定AIが誤った需要データを参照した場合、数秒で全チャネルの価格を誤更新し、数億円規模の逸失利益やブランド毀損を引き起こします。これは人間のレビュー工程を前提とした従来型DQMでは想定されていなかったリスクです。

加えて、規制リスクも経済損失を拡大させています。GDPRをはじめとするデータ保護法は、不正確な個人データの保持そのものを違反と見なします。欧州委員会の公開情報を基にした集計では、2026年時点のGDPR関連制裁金総額は約17.8億ユーロに達しており、データ品質はコンプライアンスコストを左右する財務変数になっています。

| 損失領域 | 主な発生要因 | 企業価値への影響 |

|---|---|---|

| AI意思決定 | 誤った学習・参照データ | 逸失利益、ブランド信頼低下 |

| 規制対応 | 個人データの不正確性 | 制裁金、是正コスト増大 |

| IT投資ROI | 前処理工数の肥大化 | 投資回収遅延、競争力低下 |

もう一つ見逃せないのが、IT投資効率への影響です。Gartnerは、データサイエンティストが業務時間の40〜80%をデータ前処理に費やしていると報告しています。これは高度人材が付加価値を生まない作業に拘束されている状態であり、しばしば「隠れた工場」と表現されます。低品質データは人件費を通じて静かに企業価値を侵食しているのです。

投資家や市場の視点も変化しています。近年の統合報告書やESG評価では、データガバナンスやAIリスク管理が評価項目として明示されるケースが増えました。正確で再利用可能なデータ基盤を持つ企業は、将来キャッシュフローの予測可能性が高いと評価され、結果として企業価値評価にも正の影響を与えます。

つまり、データ品質の低下は単なるコスト増ではなく、収益力・信頼・将来成長性を同時に損なう複合的な価値毀損要因です。2026年の経営において、データ品質への投資は防衛策ではなく、企業価値を守り高めるための中核的な資本配分判断になっています。

日本企業が直面するレガシーシステムとデータ分断の現実

2026年現在、日本企業が直面している最大の構造的課題の一つが、レガシーシステムとデータ分断の同時進行です。経済産業省が警鐘を鳴らした「2025年の崖」は期限としては通過しましたが、実態としては問題が解消されたわけではなく、**老朽化した基幹系と中途半端にクラウド化された周辺系が併存する歪なIT構造**が、多くの企業で固定化しています。

特に深刻なのは、基幹システムに蓄積されたデータがブラックボックス化している点です。長年の個別改修や独自仕様により、データ定義や業務ロジックが設計書に反映されていないケースが少なくありません。IPAや経済産業省の調査でも、レガシー刷新を阻む最大要因として「既存システムの複雑性と影響範囲の不透明さ」が繰り返し指摘されています。結果として、**データは存在しているのに使えない**という状態が常態化しています。

加えて、2025年前後に急速に進められたクラウド移行の多くが、Lift & Shiftにとどまったことも問題を深刻化させました。インフラは更新されたものの、データモデルやコード体系は旧来のまま残され、オンプレミスとクラウドの間、あるいはクラウド同士で新たなサイロが生まれています。Gartnerが指摘するように、マルチクラウド利用が一般化した環境では、**メタデータの断絶そのものがデータ品質リスク**となります。

| 領域 | 表面化している問題 | 経営・業務への影響 |

|---|---|---|

| 基幹系レガシー | データ定義不明、属人化 | AI・分析用途に転用不可 |

| クラウド移行後 | 新旧システム間の不整合 | 全社データ統合の失敗 |

| 人材面 | 保守人材の引退・不足 | 改修コストとリードタイム増大 |

このデータ分断は、単なるIT効率の問題にとどまりません。生成AIや自律型エージェントを業務に組み込もうとした瞬間、部門ごとに意味の異なる顧客IDや売上定義が衝突し、AIが誤った判断を下すリスクが顕在化します。Techment社のレポートが述べるように、AI時代においては**モデル性能よりもデータの一貫性と文脈整合性が競争力を左右**します。

さらに、日本特有の問題として、人材構造の歪みも無視できません。経済産業省の試算通り、IT人材の需給ギャップは約43万人規模に達し、特にレガシーを理解するベテラン層の引退が進んでいます。暗黙知に支えられてきたデータ構造が継承されないまま残されることで、システムは触れない資産、すなわち負債へと転化しています。

このように、日本企業が直面するレガシーシステムとデータ分断の現実は、DXの遅れという抽象論ではなく、**データ品質を起点とした経営リスク**として具体化しています。AI活用を加速させる以前に、分断されたデータの現実を直視し、構造的な負債として扱う視点が、2026年の経営判断に強く求められています。

生成AIとハルシネーションを引き起こすデータ的要因

生成AIにおけるハルシネーションは、モデルの性能不足やアルゴリズムの欠陥として語られがちですが、2026年現在の研究と実務の知見では、**その多くがデータ品質に起因する構造的問題**であることが明確になっています。特に大規模言語モデルや自律型エージェントは、入力データのわずかな矛盾や欠損に極端に敏感であり、人間であれば補正できる曖昧さを自律的に解釈できません。

ハーバード大学のMisinformation Reviewや複数のプレプリント研究によれば、ハルシネーションを引き起こすデータ的要因は大きく二系統に整理できます。一つは学習データそのものに内在する問題、もう一つは推論時に参照されるデータの品質問題です。これらは性質も対策も異なるため、切り分けて理解することが重要です。

| 要因の分類 | 具体的内容 | 発生しやすい局面 |

|---|---|---|

| 学習データ起因 | 誤情報、矛盾、古い情報、バイアス | 事前学習・追加学習時 |

| 参照データ起因 | 不正確な社内文書、更新漏れ、文脈欠落 | RAG・業務利用時 |

まず学習データ起因の問題です。インターネット由来のコーパスには、ニュース記事、論文、ブログ、風刺記事、誤情報が混在しています。AIは文章の流暢さや頻度は学習できますが、**それが事実か、冗談か、過去の情報かを意味的に区別する能力は限定的**です。その結果、内部知識そのものが汚染され、もっともらしい誤答を生成する土壌が形成されます。

次に深刻なのが、業務利用で顕在化する参照データ起因のハルシネーションです。RAGは信頼できる外部情報に基づいて回答を生成する仕組みですが、参照元のデータが不完全であれば逆効果になります。古い社内規定、改訂前後が混在したPDF、例外条件が欠落した文書が検索対象に含まれると、**AIは誤った情報を「根拠付き」で提示してしまいます**。

特に見落とされがちなのが、非構造化データをベクトル化する過程で生じる品質劣化です。文書分割が不適切な場合、「原則」と「例外」が分断され、検索では原則部分のみがヒットします。その結果、AIは例外を無視した断定的な回答を返し、利用者はそれを正解だと誤認します。これはモデルの問題ではなく、データ前処理設計の問題です。

Googleの検索AIが風刺記事を事実として引用した事例や、法務分野で架空判例が生成されたケースは、いずれも「信頼できるデータソースの選別」と「データ更新管理」が不十分であった点に共通項があります。Alationなどの専門家が指摘するように、**ホワイトリスト化された信頼ドメインと、メタデータ品質の維持**がなければ、RAGであってもハルシネーションは防げません。

2026年の結論として明らかなのは、生成AIの誤答は偶発的な事故ではなく、データ品質の結果であるという事実です。AIが嘘をつくのではなく、**嘘をつかせるデータ環境を人間が作っている**という認識こそが、次の品質対策の出発点になります。

RAG活用で顕在化するデータ品質の新たな課題

RAGの導入が進むにつれ、企業内では新たなデータ品質課題が顕在化しています。RAGは生成AIの回答を社内外の知識ベースに基づいて補強する仕組みですが、**参照データの品質がそのままAIの判断品質に直結する**という特性を持ちます。Gartnerが指摘するように、RAGはハルシネーション低減の有効策である一方、データ管理が不十分な組織では逆に誤情報を増幅させるリスクも抱えています。

特に問題となるのが、知識ベース内に存在する「時間軸の混乱」です。社内規程、商品仕様、契約条件などが改訂されても、過去文書が整理されないまま残存しているケースは珍しくありません。RAGは検索結果の新旧や正当性を自律的に評価できないため、**最新情報と旧情報を同列に扱い、矛盾した回答を生成する**可能性があります。これは人間であれば文脈で回避できた誤りが、AIでは致命傷になる典型例です。

また、非構造化データの前処理品質も深刻な課題です。PDFやPowerPointをベクトル化する際のチャンク分割が不適切だと、条件文や例外規定が分断され、AIが部分的な事実のみを根拠に回答してしまいます。ハーバード大学のMisinformation Reviewでも、**グラウンディング不全はデータの構造化段階で発生することが多い**と指摘されています。

| 品質課題の類型 | RAGでの具体的影響 | ビジネス上のリスク |

|---|---|---|

| 情報の陳腐化 | 旧版文書を根拠に回答 | 誤った意思決定、コンプライアンス違反 |

| 文脈の分断 | 例外条件を無視した生成 | 契約・法務判断の誤り |

| メタデータ不足 | 意味の誤解釈 | 分析結果への不信感 |

さらに見落とされがちなのが、メタデータ品質の問題です。自然言語検索が一般化した現在、AIは「売上」「顧客」「契約」といった言葉を曖昧なまま解釈します。Gartnerによれば、2026年時点で分析クエリの約40%が自然言語で行われており、**定義が曖昧なデータほどRAGの誤答率を押し上げる**傾向が確認されています。数値そのものが正しくても、意味が誤って伝われば実務では使えません。

重要なのは、RAGが万能の安全装置ではないという認識です。検索対象となるデータが不完全であれば、RAGは「信頼できない情報を、信頼できそうな形で」提示してしまいます。Techment社の分析が示す通り、**RAG時代のデータ品質とは正確性だけでなく、鮮度、文脈、意味の一貫性まで含む概念**へと拡張しています。

RAG活用を成功させる企業は、モデル改善よりも先に知識ベースの棚卸しと更新プロセスの設計に投資しています。データを貯める行為そのものが価値になる時代は終わり、**AIに参照させても安全なデータだけを残す覚悟**が、RAG時代の競争力を左右しつつあります。

国内外のインシデントから学ぶデータ品質の教訓

国内外で発生したインシデントを振り返ると、データ品質の問題は単なるIT上の不備ではなく、組織の信頼や社会的責任に直結することが分かります。特に2024年から2026年にかけては、AI活用やデジタル連携の高度化に伴い、品質不備の影響範囲が一気に拡大しました。ここでは代表的な事例から、実務に生かすべき教訓を整理します。

日本国内で象徴的だったのが、マイナンバー関連情報の誤紐付け問題です。氏名や住所表記の揺らぎといった基礎データの不統一が、別人情報の結合という重大な結果を招きました。デジタル庁の検証でも、システム以前に名寄せルールと標準化の不徹底が根本原因であったとされています。人手による最終確認に依存した運用は、データ量が増えるほど破綻しやすいことを示しました。

一方、民間企業では2025年のアスクルのランサムウェア被害が示唆に富みます。事業停止の長期化を左右したのは、バックアップの有無ではなく、そのデータが最新かつ整合性を保っていたかでした。専門家の分析によれば、可用性と完全性はセキュリティと不可分であり、データ品質はBCPの中核要素であると再認識されています。

| インシデント | 表面化した問題 | 教訓 |

|---|---|---|

| マイナンバー誤紐付け | 本人確認データの不整合 | 基礎データ標準化の徹底 |

| ランサムウェア被害 | 復旧遅延・業務停止 | 品質担保されたバックアップ |

| 金融系システム障害 | 取引データの一貫性低下 | リアルタイム連携時の検証強化 |

海外事例では、生成AIが誤情報を事実として提示したケースが注目されました。Googleの検索AIが風刺記事を真実として要約した問題は、AIの判断ミスというより、参照データの選別と管理の失敗です。ハーバード大学の研究でも、信頼できる情報源の明示とメタデータ管理がなければ、AIは誤りを自信を持って拡散すると指摘されています。

これらの事例に共通するのは、問題発生後の対応コストが、事前の品質投資をはるかに上回る点です。**データ品質は事故を防ぐ保険であると同時に、AI時代の意思決定を支えるインフラ**です。インシデントから学ぶべき最大の教訓は、品質管理を例外対応ではなく、日常業務とシステム設計の前提条件として組み込む必要があるという事実です。

Agentic AIによるデータ品質管理の自律化と最新動向

2026年において、データ品質管理は人手による統制から、Agentic AIによる自律的な運用へと明確に移行しています。背景にあるのは、エッジ生成データの急増、マルチクラウド化、そして深刻なデータ人材不足です。GartnerやIDCが示す通り、もはや中央集権的なチェック体制では全体を把握できず、データ品質そのものがリアルタイムで変動する前提に立たざるを得ません。

こうした環境下で注目されているのが、Agentic AIによるデータ品質管理の自律化です。これは単なる自動化ではなく、AIエージェントがデータの文脈や過去の挙動を理解し、異常検知から是正判断、実行までを連続的に行う点に本質があります。Alationの2026年トレンドレポートによれば、従来型ツールでは見逃されていた意味的な矛盾や利用目的との不整合を、エージェントが自律的に特定できる段階に入ったとされています。

具体的には、売上データの急変を単なる外れ値として隔離するのではなく、キャンペーン施策や外部要因を参照し「正しい異常」か「修正すべき誤り」かを判断します。これにより、人間が介在しないまま品質劣化が業務やAI推論に波及するリスクを大幅に低減できます。Harvard Kennedy SchoolのAI誤情報研究でも、文脈理解を伴う自律的ガバナンスがハルシネーション抑制に有効であると指摘されています。

また、Agentic AIはメタデータ管理の在り方も変えています。データ定義やリネージを人が記述・更新するのではなく、エージェントがデータの利用履歴やクエリ内容を解析し、意味情報を自動補完します。これにより、自然言語クエリが主流となった分析環境でも、解釈のズレが蓄積しにくくなっています。

| 観点 | 従来型DQM | Agentic AI型 |

|---|---|---|

| 異常検知 | 固定ルール・閾値 | 文脈・履歴を考慮 |

| 是正判断 | 人手レビュー | 自律判断+実行 |

| メタデータ | 手動更新 | 利用状況から自動生成 |

日本企業でも先進事例が現れています。JDMCのデータマネジメント賞受賞企業では、Agentic AIを品質監視の常駐担当者として位置づけ、人は例外対応と方針設計に集中しています。その結果、データ修正のリードタイムが大幅に短縮され、AI活用プロジェクトの立ち上げ速度が向上したと報告されています。

2026年の最新動向として重要なのは、Agentic AIが万能な代替者ではない点です。自律性を発揮させるには、信頼できる参照データ、明確なガバナンスポリシー、そして人による監督設計が不可欠です。**自律化とは放任ではなく、人とAIの役割分担を再設計すること**であり、その成否が次世代のデータ競争力を左右しています。

成功企業に学ぶデータ品質を競争力に変える実践アプローチ

データ品質を競争力へと転換している企業に共通するのは、品質をコストや統制の問題としてではなく、価値創出の起点として再定義している点です。2026年の先進企業は、AI活用の成否がデータ品質に直結することを前提に、経営レベルでの意思決定と現場の実践を結び付けています。**重要なのは、完璧なデータを目指すことではなく、ビジネス成果に直結する品質を継続的に作り出す仕組み**を持つことです。

日本データマネジメント・コンソーシアムが表彰した2025年の受賞企業の取り組みを見ると、品質向上が具体的な成果に結び付いていることが分かります。例えばKDDIは、全社共通のデータ定義とメタデータ管理を徹底することで、分析やAI開発前のデータ準備工数を大幅に削減しました。Gartnerが指摘する「分析作業時間の大半が前処理に費やされる」という課題に対し、**準備時間の短縮そのものを競争優位と捉えた点**が特徴です。

| 企業の実践 | データ品質施策 | 競争力への転換点 |

|---|---|---|

| 通信・インフラ企業 | 全社共通マスタと自動品質監視 | AI施策の立ち上げ速度向上 |

| 製薬企業 | データを製品として管理 | 研究開発の再現性と信頼性向上 |

| 小売企業 | 現場主導のデータ責任体制 | 需要予測精度の改善 |

武田薬品工業の事例では、研究データを「Data as a Product」と位置付け、品質基準や更新責任を明確化しました。これにより、生成AIや分析モデルが参照するデータの信頼性が担保され、再検証や手戻りのコストが減少しています。IDCが示すように、データ生成が分散化する時代において、**責任の所在を曖昧にしない設計が品質を守る最短ルート**となっています。

さらに注目すべきは、成功企業が人材不足を理由に品質向上を諦めていない点です。ManpowerGroupが指摘する深刻なデータ人材不足に対し、これらの企業は自律型データ管理や自動修復の仕組みを導入し、人に依存しない運用へ移行しています。Alationのレポートによれば、このアプローチは品質維持の安定化だけでなく、ガバナンス対応の迅速化にも寄与しています。

成功事例が示す最大の教訓は、データ品質を一度きりの改善活動にしないことです。品質を測定し、改善し、再利用する循環を日常業務に組み込むことで、データは守るべき資産から攻めの武器へと変わります。2026年の競争環境において、**データ品質を戦略的に運用できる企業こそが、AI時代の持続的優位を確立しています**。

2027年を見据えた企業のための戦略的データ品質アクション

2027年を見据えた企業にとって、データ品質は「是正する対象」ではなく、将来価値を生み出すために先回りして設計すべき戦略アセットになっています。2026年時点で多くの企業が直面しているのは、AI導入後に品質問題が顕在化する後追い型の対応です。**2027年に競争優位を確立する企業は、AIが本格稼働する前提でデータ品質を能動的に組み込んでいます。**

まず重要なのが、データ品質をIT施策ではなく経営KPIとして再定義することです。Gartnerが示すように、データ品質不備による平均年間損失は1,290万ドル規模に達しますが、これはAIによる誤判断が連鎖的に発生した場合の直接損失のみを反映した数字にすぎません。価格最適化、需要予測、信用判断といった領域でAIを活用する企業ほど、品質劣化は即座に利益率の低下として現れます。

このため先進企業では、売上成長率やROIと並んで「AI可用データ比率」や「メタデータ完全性」といった指標を経営ダッシュボードに組み込み始めています。**AIが安全に参照できるデータの割合を定量管理することが、2027年型ガバナンスの中核です。**

| 戦略アクション | 目的 | 2027年の効果 |

|---|---|---|

| AI可用データの定義 | 品質基準の明確化 | ハルシネーションリスク低減 |

| メタデータ自動化 | 意味の一貫性確保 | 自然言語分析の精度向上 |

| 品質KPIの経営統合 | 意思決定の迅速化 | ROI最大化 |

次に注目すべきは、データ品質の「事前組み込み」です。IDCが指摘する通り、エンタープライズデータの大半はエッジで生成される時代に入りました。つまり、後段のDWHやAI基盤で修正するのでは遅く、データが生まれる瞬間に品質を担保する設計が求められます。製造業であればセンサー定義、金融であれば取引コード体系、医療であれば入力ルールの標準化がその典型です。

さらに2027年を見据えると、Agentic Data Managementの実装は選択肢ではなく前提条件になります。Alationの2026年レポートが示すように、AIエージェントによる自律的な異常検知と修復は、人材不足下でも品質を維持する現実的な解となりつつあります。**人がチェックする品質から、AIが守る品質へと役割分担を転換することが不可欠です。**

2027年に成果を出す企業は、データ品質を「後工程のコスト」ではなく「AI価値創出の前提条件」として設計しています。

最後に忘れてはならないのが、文化としての定着です。JDMCのデータマネジメント賞受賞企業に共通するのは、入力段階での品質責任が現場に明確に割り当てられている点です。ツールやAIは補助輪にすぎず、**データは誰が使うかではなく、誰が責任を持つかで品質が決まります。**2027年に向けた戦略的データ品質アクションとは、技術・指標・文化を同時に前進させる経営判断そのものなのです。

参考文献

- IDC:Worldwide Global DataSphere Forecast

- Gartner:How to Design a Data-Centric AI Strategy

- Harvard Kennedy School Misinformation Review:New sources of inaccuracy? A conceptual framework for studying AI hallucinations

- Journal of Nuclear Medicine:On Hallucinations in Artificial Intelligence–Generated Content for Nuclear Medicine Imaging

- Alation:2026 Data Management Trends and What They Mean For You

- 経済産業省:DXレポート