ここ数年で「AIを使える人」と「AIを任せられる人」の差が急速に広がっています。かつてはチャットボットを業務に活用できれば十分とされていましたが、2026年の現在、その前提は完全に崩れました。AIは質問に答える存在から、業務プロセスを自律的に遂行するエージェントへと進化し、人間はその設計者・監督者としての役割を担う時代に入っています。

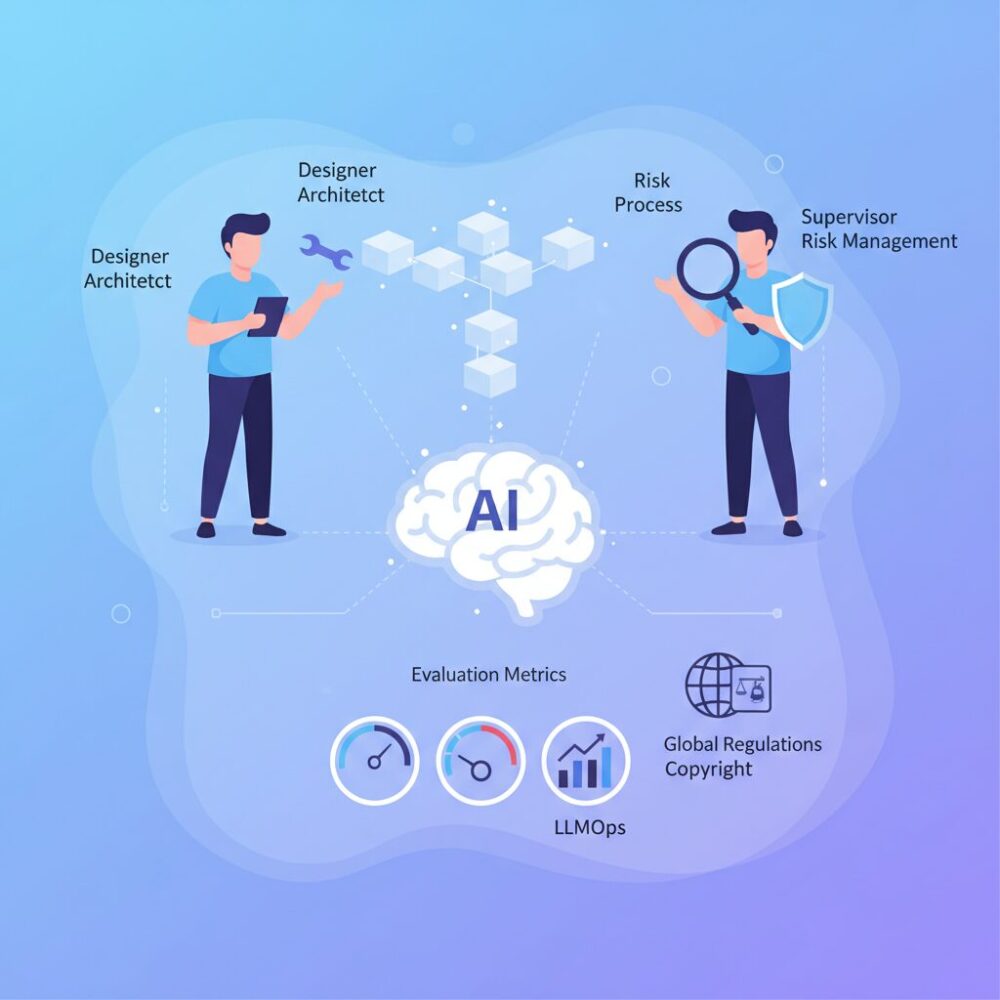

この変化は、単なるITスキルの話ではありません。RAGの評価指標を理解し、ハルシネーションを前提とした運用を設計し、EU AI法や著作権といったグローバル規制に対応する力まで含めて、AIリテラシーは「組織の競争力」を左右する経営課題となっています。実際、日本企業の多くがAI活用の次の段階に進めず、統制や評価の壁に直面しています。

本記事では、自律型エージェント時代を迎えた2026年に、日本のビジネスパーソンや専門家が身につけるべきAIリテラシーの全体像を体系的に整理します。技術、制度、教育、企業事例を横断しながら、AIと共創しつつリスクを制御するための実践的な視点を得られる内容です。読み終えたとき、自身や組織に何が足りないのかを明確に描けるはずです。

2026年にAIリテラシーが再定義される理由

2026年にAIリテラシーが再定義される最大の理由は、AIが「助言する存在」から「業務を遂行する主体」へと質的に変化した点にあります。2023〜2024年の生成AIブームでは、チャットボットを使いこなす操作能力が注目されましたが、この段階はすでに基礎教養となりました。**現在のAIは、人の指示を待つツールではなく、業務プロセスの一部を自律的に実行するエージェントへ進化しています。**

クラウドエースが2026年1月に公表した企業調査によれば、日本企業の約3分の1がすでにRAGを用いた「社内知見参照レベル」に到達しており、提案書作成や情報整理をAIが担うケースが常態化しています。一方で、同調査ではチャット利用者の約4割が「二重チェックの負荷」や「手離れの悪さ」を課題として挙げています。これは、AIを動かす力は身についたものの、AIを設計・統制するリテラシーが追いついていない現状を示しています。

| 観点 | 従来のAIリテラシー | 2026年のAIリテラシー |

|---|---|---|

| AIの位置づけ | 作業支援ツール | 自律的な業務パートナー |

| 重視点 | 操作・使いこなし | 設計・監督・責任 |

| リスク対応 | 個人の注意 | 組織的ガバナンス |

この変化を決定づけたのが、エージェント型AIとRAGの実務標準化です。AIが複数の社内文書を横断検索し、判断材料を提示する現在、問われるのは「導入したか」ではなく「回答の品質をどう保証するか」です。FaithfulnessやRelevanceといった評価指標を理解し、数値で議論できることが、企画職や管理職にも求められるようになりました。**AIの出力を評価できない人は、AIを任せることも止めることもできません。**

さらに、EU AI法の完全適用フェーズ入りが再定義を加速させています。同法第4条は、AIを利用する組織に対し十分なAIリテラシー教育を求めており、これは事実上の国際基準です。経済産業省やIPAが示すDX推進スキル標準も、この流れと連動しています。もはやAIリテラシーは個人の生産性向上スキルではなく、**組織としてAIを安全かつ価値創出に使うための前提条件**として位置づけ直されているのです。

このように2026年のAIリテラシー再定義は、技術進化、企業実務、そして国際規制が同時に臨界点を越えた結果です。AIと協働する時代に必要なのは、賢い使い手ではなく、信頼できる管理者であるという認識そのものが、今まさに更新されています。

チャットボットの終焉と自律型エージェントの台頭

2023年から2024年にかけて急速に普及したチャットボット型生成AIは、2026年現在、その役割を大きく変えています。単発の質問に答える「相談相手」としての価値は依然として残るものの、業務の中核を担う存在としては限界が明確になりました。背景には、ビジネス現場で求められるスピード、再現性、責任所在の明確さが、対話中心のAIでは満たせなくなった現実があります。

クラウドエースが2026年1月に公表した国内調査によれば、日本企業のAI活用は「チャットによる補助」から「実務の自律的代行」へと重心を移しています。特に、社内データを参照するRAG環境が整備された企業ほど、人が逐一指示し確認するチャット運用に強い非効率を感じていることが示されています。実際、チャット利用者の約4割が二重チェックや手離れの悪さを課題として挙げています。

| 観点 | チャットボット | 自律型エージェント |

|---|---|---|

| 主な役割 | 質問応答・要約 | 業務プロセスの実行 |

| 人の関与 | 常時必要 | 監督・承認に限定 |

| 価値の源泉 | 即時性 | 再現性とスケール |

この変化の本質は、AIが「話し相手」から「働く主体」へと進化した点にあります。自律型エージェントは、事前に設計されたワークフローに基づき、情報収集、下書き作成、システム操作までを連続的に遂行します。OpenAIやMicrosoftが示すエージェント設計思想でも、人間は逐次操作する存在ではなく、成果物の品質と意思決定に責任を持つマネージャーとして位置付けられています。

重要なのは、チャットボットが突然「不要」になったわけではない点です。むしろ、チャットはエージェントを設計・監督するためのインターフェースへと役割転換しています。AIとの対話はゴールではなく、業務を自律的に前進させるための設計手段になったのです。ここに、チャットボット時代の終焉と、自律型エージェント時代の本質的な違いがあります。

AI活用レベルの進化と日本企業の現在地

2026年現在、日本企業におけるAI活用レベルは明確な段階差を伴いながら進化しています。かつて主流であった生成AIとの対話中心の活用はすでに基礎段階と見なされ、実務をどこまでAIに委ねられているかが企業の成熟度を測る軸となっています。

クラウドエースが2026年1月に公表した調査によれば、日本企業のAI活用は5段階モデルで整理されており、**最も多いのは社内データを検索・参照するLv.3(RAG活用)で約33.3%**を占めています。一方、業務プロセスの主体をAIが担うLv.4以上に到達している企業は依然として少数派です。

| 活用レベル | 主な特徴 | 2026年の位置づけ |

|---|---|---|

| Lv.2 | チャット・要約・検索補助 | 基礎リテラシーとして定着 |

| Lv.3 | RAGによる社内知見活用 | 最多層・実務インフラ段階 |

| Lv.4 | AIエージェントによる業務代行 | 先進企業が実装を開始 |

この分布が示すのは、日本企業の多くが「AIは使っているが、任せ切れてはいない」状態にあるという現実です。調査では、チャット型AI利用者の約4割が**二重チェックの負担や手離れの悪さ**を課題として挙げており、AIを自律的なエージェントへ進化させる設計力と運用力がボトルネックになっています。

背景には、日本企業特有の品質責任意識とリスク回避文化があります。経済産業省やIPAが示すDX推進スキル標準でも、AI活用は個人の効率化ではなく、組織的なプロセス設計とガバナンスの一部として位置づけられています。**AIに仕事を任せるとは、成果物の最終責任を人間が引き受けること**を意味するため、単純な自動化よりも慎重な導入が選ばれてきました。

しかし、RAGが業務インフラとして定着した2026年は転換点でもあります。AIの回答を定量指標で評価し、品質を継続監視するLLMOpsの考え方が広がり、AIを管理可能な存在として扱える土壌が整いつつあります。スタンフォード大学のHuman-Centered AIの研究でも、人間が監督者として関与する設計が自律型AIの信頼性を高めると指摘されています。

日本企業の現在地は、決して出遅れではありません。**対話から代行へ、操作から設計へと移行するための助走期間**にあり、ここで必要なのは新しいツールではなく、AIを業務プロセスの一員として統制するリテラシーです。この一段の壁を越えられるかどうかが、2027年以降の競争力を大きく左右していきます。

RAGが前提となる時代の評価指標とLLMOps思考

RAGが業務インフラとして定着した2026年において、AI活用の成否を分けるのは導入可否ではなく評価設計です。特にエージェント型AIが自律的に判断や処理を行う前提では、**人間がAIの出力品質をどの指標で監視し、いつ介入するか**を明確にしておかなければ、業務リスクは指数関数的に高まります。そのため評価指標は、もはやエンジニアだけの関心事ではなく、マネージャーや企画職が理解すべき共通言語になっています。

実務で中核となるのが、回答品質と検索品質を分けて捉える視点です。スタンフォード大学やGoogle DeepMindのRAG関連研究でも、生成精度の劣化要因の多くは生成モデルそのものではなく、参照コンテキストの質に起因すると指摘されています。つまり、検索段階の設計と評価を誤れば、どれほど高性能なLLMでも正しい答えは返せません。

| 評価領域 | 指標 | ビジネス上の意味 |

|---|---|---|

| 回答品質 | Faithfulness | 社内文書や一次情報に忠実かを測定し、コンプライアンス違反や誤判断を防ぎます |

| 回答品質 | Answer Relevance | 質問意図に即した回答かを評価し、現場の手戻り工数を削減します |

| 検索品質 | Context Precision | 不要情報の混入を防ぎ、AIの推論迷走を抑制します |

| 検索品質 | Context Recall | 必要情報の欠落を防ぎ、判断ミスの芽を摘みます |

これらの指標を一過性の検証で終わらせず、継続的に監視する発想がLLMOpsです。MetaやMicrosoftが公開している運用事例でも、評価スコアの時系列変化をダッシュボードで可視化し、数値の劣化をトリガーにデータ更新や検索ロジック改善を行う体制が標準化しています。**評価は品質保証であると同時に、改善ポイントを示す経営指標**でもあるのです。

実際の企業現場では、「今月はFaithfulnessが低下しているため、最新規程がベクトルDBに反映されていない可能性がある」といった会話が定例会議で交わされています。このレベルに達して初めて、AIはブラックボックスではなく管理可能な業務プロセスになります。RAG前提の時代に求められるのは、AIを信じる姿勢ではなく、**数値で疑い、数値で改善するLLMOps思考**なのです。

ハルシネーションを前提とした設計と人間の責任

2026年のAIリテラシーにおいて、法的・倫理的観点はもはや専門部署だけの課題ではありません。**自律型エージェントが業務を代行する時代では、現場の判断一つが企業全体の法的責任に直結します**。特にEU AI法の本格適用により、日本企業にもグローバル基準での統制が強く求められています。

EU AI法第4条は、AIの提供者と利用者に対し、利用文脈に応じた十分なAIリテラシーを確保することを義務づけています。欧州委員会の解説によれば、これは単なる操作研修では足りず、AIの仕組み、限界、リスクを理解した上での運用能力を含みます。**違反そのものに高額罰金はなくとも、リテラシー不足が原因で損害が生じれば、民事責任や監督当局の調査対象となる現実的リスクがあります**。

実務上の変化として顕著なのが、研修の位置づけです。NAVEXなどのコンプライアンス専門企業は、AIリテラシーを倫理・内部統制研修の中核に組み込み、受講記録や理解度を監査可能な形で保存する仕組みを提供しています。これは、AI活用が進むほど「教育の実施証跡」が企業防衛の重要な根拠になることを示しています。

| 論点 | 2026年の実務的解釈 | 企業に求められる対応 |

|---|---|---|

| EU AI法 第4条 | 十分なAIリテラシー確保は事実上の義務 | 役割別・記録付き研修の実施 |

| 著作権(日本) | 学習段階と利用段階の法的性質は別 | 生成物の利用可否を人が判断 |

| ガバナンス | 説明責任と透明性が評価対象 | ISO/IEC 42001準拠の運用 |

著作権分野でも、議論は成熟段階に入りました。文化庁やJEITAの整理によれば、AI学習目的での著作物利用は原則適法である一方、生成物の利用段階で既存作品と類似すれば侵害リスクが生じます。**この「学習と利用の分離」を理解せずにAIを使うこと自体が、2026年ではリテラシー不足と評価されます**。マーケティングやクリエイティブの現場では、契約や利用規約を読み解く力が不可欠です。

さらに、組織的成熟度を示す指標としてISO/IEC 42001の認証取得が広がっています。この規格は、技術の正確性だけでなく、倫理性、透明性、安全性を含むAIマネジメントを求めます。認証プロセスを通じ、現場社員にもPDCAに基づく説明責任が浸透し、**AIを使うこと自体がガバナンス行為であるという意識が定着しつつあります**。

法的・倫理的リテラシーとは、ルールを暗記することではありません。**AIの判断と人間の責任の境界を理解し、リスクを予見して設計・運用に反映させる能力**です。2026年、この能力の有無が、AI活用企業として信頼されるかどうかを静かに分けています。

日本政府のAI戦略とDX推進スキル標準の影響

日本政府のAI戦略とDX推進スキル標準は、2026年時点で企業や個人のAIリテラシーを事実上の共通基盤へと押し上げています。デジタル庁が主導するAI戦略では、生成AIや自律型エージェントを行政実務に組み込む前提で制度設計が進められており、これは民間にも強い波及効果をもたらしています。特に注目すべき点は、AI活用が単なる効率化ではなく、業務プロセス全体の再設計を伴う国家的DXとして位置づけられていることです。

経済産業省とIPAが策定したDX推進スキル標準は、その象徴的な存在です。この標準は職種ごとに求められる役割とスキルを定義し、AIを含むデジタル技術を使って価値創出を行う能力を可視化しています。**「AIを使えるか」ではなく「AIを前提に業務を設計・統制できるか」**が評価軸となり、人事評価や採用基準にも組み込まれています。

| 観点 | 従来 | 2026年の標準 |

|---|---|---|

| 政府のAI活用 | 実証実験中心 | 本番運用と横展開 |

| 人材評価 | ITスキルの有無 | 役割別DXスキル水準 |

| 企業DX | 部門最適 | 全社・全工程最適 |

デジタル庁の活動報告によれば、ガバメントAI構想では調達仕様や運用ガイドラインが標準化され、地方自治体や委託先企業にも同水準のリテラシーが求められています。これにより、公共案件に関わる民間企業は、AIの仕組みやリスクを説明できなければ競争力を失う状況になっています。**政府調達が“実務で通用するAIリテラシー”の最低基準を定義している**と言えます。

DX推進スキル標準の影響は、ビジネス現場にも明確に現れています。ビジネスアーキテクトには、生成AIを活用した業務変革構想を描き、エンジニアやデザイナーと共通言語で議論する能力が求められています。これは単なる知識ではなく、AIの限界やハルシネーションリスクを理解した上で意思決定する実践的な判断力です。IPAによれば、この標準は「育成計画を立てるための地図」として機能することが意図されています。

重要なのは、これらの政策や標準がトップダウンの号令で終わっていない点です。人材開発支援助成金や職業訓練の重点化により、地方や中小企業にも学習機会が広がっています。**AI戦略とDX推進スキル標準は、個人の学び直しと企業変革を同時に促すレバーとして設計されている**のです。2026年の日本において、AIリテラシーはもはや任意のスキルではなく、社会全体で共有される前提条件となっています。

先行企業に学ぶAI人材育成と実装のリアル

先行企業の取り組みを俯瞰すると、2026年のAI人材育成は座学中心の研修から、実装と成果創出を前提とした現場主導型へと明確に移行しています。**ポイントは「全社員の底上げ」と「高度人材の内製化」を同時に進めている点**であり、単なるツール習得では競争優位は生まれないという共通認識が見て取れます。

トヨタグループでは、生成AIブーム初期から社内に専門組織を設置し、エンジニア層に対してはLLMOpsやエージェント連携設計まで踏み込んだ育成を行っています。トヨタコネクティッドのデジタル道場では、業務システムとAIをどう安全に接続し、どう監督するかが重視され、**AIを動かす側に立つ視点が鍛えられています**。これは経済産業省やIPAが示すDX推進スキル標準の思想とも整合しています。

一方、伊藤忠商事の事例は、ビジネス職主導の実装が成果に直結した好例です。営業現場で使われる物性検索・提案AIは、RAGを活用して膨大な技術資料を即座に参照できる仕組みを構築しました。**重要なのは、AIの精度指標やデータ範囲を現場が理解し、改善に関与している点**であり、導入後も評価と修正を繰り返す運用リテラシーが定着しています。

| 企業 | 育成の主軸 | 実装上の特徴 |

|---|---|---|

| トヨタグループ | 高度技術人材の内製化 | LLMOps・エージェント設計まで含む実践訓練 |

| 伊藤忠商事 | ビジネス職の実装力 | RAG評価を前提にした営業プロセス改革 |

| セブン&アイ | 課題設定力の育成 | 現場課題を用いたワークショップ型研修 |

セブン&アイ・ホールディングスでは、現場課題を題材にしたワークショップ形式を採用し、AIリーンキャンバスを用いて業務変革を設計させています。**操作方法ではなく、どの業務にAIを組み込むべきかを考えさせる設計**が特徴で、ビジネスアーキテクト的思考を持つ人材を計画的に増やしています。

さらにソフトバンクのように、コンテスト形式で発想と実装を競わせる企業も増えています。専門家によれば、アウトプット前提の学習は定着率が高く、実務への転用が早いとされています。**先行企業に共通するのは、AIを試す場と失敗を許容する文化を制度として用意していること**であり、これこそが2026年のAI人材育成と実装のリアルだと言えるでしょう。

EU AI法が突きつけるAIリテラシーとコンプライアンス

EU AI法は、AIを「使えるかどうか」ではなく、「理解し、統制できているか」を企業に厳しく問いかけています。2026年に完全適用フェーズへ入った同法の中でも、特に第4条が定めるAIリテラシー要件は、日本企業にとって見過ごせない論点です。EU域内で事業を展開する場合だけでなく、EU市民のデータを扱う、あるいはEU企業と取引するだけでも、事実上の遵守が求められます。

第4条の特徴は、特定の職種や専門家に限定せず、AIシステムの提供者・導入者が関与する人々全体に対し、十分なAIリテラシーを確保する措置を義務付けている点です。欧州委員会の解釈によれば、ここでいうリテラシーとは操作方法の理解にとどまらず、AIの限界、誤作動リスク、倫理的影響を踏まえた判断能力まで含みます。

重要なのは、AIリテラシーが「教育施策」ではなく「コンプライアンス施策」として扱われ始めた点です。

罰金が直接規定されていないにもかかわらず、多くの企業が本格対応に乗り出している背景には、リテラシー不足が原因で事故や差別的判断が生じた場合、民事責任や監督当局の調査リスクに直結するという現実があります。国際法律事務所やNAVEXのようなコンプライアンス専門企業も、AI研修の記録化と継続実施を強く推奨しています。

| 観点 | EU AI法が求める内容 | 企業実務への影響 |

|---|---|---|

| 対象範囲 | 開発者・利用者・運用関与者全体 | 全社員向け教育が必要 |

| 知識内容 | 仕組み・限界・リスク理解 | 操作研修のみでは不十分 |

| 証明責任 | 措置を講じた記録の保持 | 研修履歴の管理が必須 |

この流れは、日本企業のAI活用姿勢そのものを変えつつあります。従来の「現場に任せる便利ツール」から、「組織として説明責任を負う業務インフラ」への転換です。AIの判断を人間が理解し、必要に応じて止められる体制を整えているかどうかが、取引先や投資家からの評価軸にもなり始めています。

EU AI法が突きつけているのは、技術力の優劣ではありません。AIと共に働く組織として、どこまで成熟したリテラシーと統制力を備えているかという、経営そのものへの問いなのです。

著作権・知的財産と契約で管理するAI活用

2026年のAI活用において、著作権・知的財産の論点は「対立」から「契約で管理する実務」へと明確に移行しています。生成AIや自律型エージェントが業務プロセスの中核に組み込まれた現在、法解釈だけに依存した運用は現実的ではなく、契約設計こそがリスクコントロールの主戦場になっています。

文化庁が示すAIと著作権に関する整理によれば、学習段階における著作物利用は著作権法第30条の4により原則適法とされています。一方で、生成・利用段階では、既存著作物との類似性や依拠性が問題となり、侵害リスクは依然として残ります。**この「学習は適法、利用は要注意」という二層構造を前提に、企業は契約で責任範囲を具体化する必要があります。**

実務で特に重要なのが、AIサービスの利用規約やベンダー契約に含まれる知的財産条項の読み解きです。例えば、生成物の著作権帰属、第三者権利侵害時の補償有無、学習データへの再利用可否などは、契約ごとに大きく異なります。JEITAが知的財産推進計画に向けた意見で指摘している通り、法で未整備な領域は当事者間の合意で補完するという考え方が、2026年には事実上の標準となっています。

| 論点 | 2026年の実務的整理 | 契約で管理すべきポイント |

|---|---|---|

| 生成物の権利 | 自動的に利用者帰属とは限らない | 著作権帰属と利用範囲の明記 |

| 侵害リスク | 完全排除は困難 | 補償条項・免責範囲の設定 |

| 学習データ | ブラックボックス化しやすい | 再学習可否・拒否権の明確化 |

マーケティングやクリエイティブ領域では、「特定の作家や画風に似せない」といった倫理的配慮を、法ではなく契約や社内ポリシーで担保する動きが定着しています。**これは創作者保護とAI活用を両立させる現実的な落としどころであり、感情論ではなくルール設計の問題として扱われています。**

また、自律型エージェントが外部APIやデータベースと連携する場合、生成物だけでなく「プロセスの責任」も問われます。どのデータを参照し、どの条件でアウトプットを生成したのかを説明できるよう、契約とログ管理をセットで設計することが不可欠です。国際的にはISO/IEC 42001のようなAIマネジメント規格が、こうした説明責任を組織要件として明文化しています。

2026年のAIリテラシーにおける著作権・知的財産対応とは、法律知識の暗記ではありません。**自社のAI活用目的に照らし、どのリスクを契約で引き受け、どこを回避するのかを判断できる力**が問われています。AIと共創する時代において、契約は単なる防御策ではなく、価値創出を可能にする戦略的ツールになっているのです。

教育現場で進むAIネイティブ世代の育成

教育現場では今、従来の「デジタルネイティブ」を超えるAIネイティブ世代の育成が急速に進んでいます。2026年時点の特徴は、AIを便利な道具として教える段階を終え、学習プロセスそのものにAIが組み込まれている点です。生徒や学生は、AIに答えを聞く存在ではなく、思考を深め、検証し、改善するための対話相手としてAIを使いこなすことが前提になりつつあります。

文部科学省が推進する数理・データサイエンス・AI教育プログラム認定制度によれば、大学教育では全学部横断でAIとデータ活用を学ぶ体制が標準化しました。医療系や教育系学部であっても、アルゴリズムの基礎やデータの扱い方、AIの限界とリスクを理解する科目が必修化されています。これは、専門分野にAIをどう組み込み、どう統制するかを考えられる人材を育てる狙いがあります。

高校以下の教育現場でも変化は顕著です。2022年度から必修となった情報Iで基礎を学んだ生徒たちは、2026年には探究学習の中で生成AIを活用する段階に進んでいます。ベネッセコーポレーションとデジタルハリウッドの共同カリキュラムでは、AIを使って仮説を立て、資料を比較し、結論の妥当性を検証する授業設計が行われています。ここで重視されているのは、AIの出力をそのまま使わない批判的思考です。

| 教育段階 | AI活用の位置づけ | 育成される能力 |

|---|---|---|

| 小・中学校 | 創作・発想支援 | 表現力と思考の可視化 |

| 高等学校 | 探究・検証パートナー | 批判的思考と情報判断力 |

| 大学・高専 | 専門分野の共創ツール | 設計力と責任ある活用力 |

また、教員側の役割も変わっています。授業準備や評価の一部をAIが補助することで、教員は知識伝達者から学習設計者へとシフトしています。EdTech分野の研究者によれば、AIを前提にした授業では、生徒一人ひとりの思考過程を把握しやすくなり、プロセス評価の質が向上することが示されています。これは一斉授業では難しかった個別最適化を現実のものにしています。

重要なのは、AIネイティブ世代が単に操作に慣れている世代ではない点です。彼らは、AIが誤る可能性や偏りを含むことを学習段階から理解し、どう監督すべきかを体感的に身につけています。教育現場で進むこの変化は、将来のビジネスや社会において、AIと共創しつつ統制できる人材を生み出す基盤となっています。

Human-AI Synergyがもたらす次の競争軸

2026年における競争優位の源泉は、AIの性能そのものではなく、人間とAIがどのような役割分担で価値を生み出しているかへと明確に移行しています。エージェント型AIが業務プロセスを自律的に遂行できる現在、企業間の差は「どのAIを使っているか」ではなく、「Human-AI Synergyをいかに設計・運用しているか」によって生まれます。

クラウドエースが2026年に公表した調査によれば、RAGやAIエージェントを導入済みの企業であっても、成果創出に差が生じる最大要因は、AIの判断結果を人間がどの段階で介入・承認しているかという運用設計にありました。特に高い成果を上げている組織では、AIを「自動化ツール」ではなく、意思決定を加速する認知的パートナーとして位置付けています。

この文脈で重要になるのが、Human-in-the-loopの再定義です。従来はリスク回避のためのチェック工程と捉えられていましたが、2026年現在では、人間が価値判断や文脈理解に集中し、AIが探索・生成・実行を担うという、役割の最適分解として設計されます。スタンフォード大学HAIの議論でも、人間が介在するポイントを減らすのではなく、意味のある介在点を意図的に設けることが、組織全体の生産性と品質を同時に高めると指摘されています。

| 競争軸 | 従来型 | Human-AI Synergy型 |

|---|---|---|

| 人の役割 | 作業主体・最終実行者 | 判断主体・設計責任者 |

| AIの位置付け | 補助ツール | 自律的パートナー |

| 成果差の要因 | 操作スキル | 協調設計と統制力 |

先行企業の事例を見ると、この競争軸は抽象論ではありません。伊藤忠商事では、営業現場にAIを組み込む際、AIが提示する提案案をそのまま使わせるのではなく、人間が「なぜその提案が妥当か」を説明できる設計を重視しました。その結果、提案の質だけでなく、顧客からの信頼性向上という副次的な価値も生まれています。

また、EU AI法第4条が求めるAIリテラシーの本質も、この競争軸と深く結びついています。同条は単なる操作教育ではなく、AIの能力と限界を理解した上で、人間が責任を持って活用できる状態を求めています。これは裏を返せば、Human-AI Synergyを組織的に構築できる企業ほど、グローバル市場での信頼と競争力を獲得できることを意味します。

今後の市場では、AI投資額やモデルサイズはコモディティ化が進みます。その中で持続的な差別化を生むのは、人間がAIをどう信頼し、どこで疑い、どの判断を自ら引き受けるのかという設計思想です。Human-AI Synergyは、単なる協業概念ではなく、2026年以降の企業価値を左右する次の競争軸として、すでに実務の現場で機能し始めています。

参考文献

- Cloud Ace:【AI 駆動(AI-Driven)型ビジネスへの移行実態調査】企業の AI 活用は「チャット」から「実務代行」へ

- Workstyle Evolution:RAG評価の完全ガイド|生成AI開発者が知るべき精度と品質を測る指標

- デジタル庁:2025年デジタル庁活動報告

- IPA:DX推進スキル標準(DSS-P)概要

- EU Artificial Intelligence Act:Article 4: AI literacy

- AIsmiley:G検定がシラバス改訂。生成AIやAI倫理・AIガバナンスに関する範囲が追加

- 文部科学省関連ニュース(順天堂大学):数理・データサイエンス・AI教育プログラム認定制度の取り組み