生成AIの爆発的な進化により、データセンターの冷却技術は「裏方の設備」から「競争力を左右する戦略インフラ」へと変わりました。従来の空冷では1ラックあたり15~20kWが限界とされてきましたが、最新のAIクラスタでは60kW、さらには100kW超が当たり前になりつつあります。

NVIDIA Blackwell UltraやAMD Instinct MI350シリーズのように、1,400W級のTDPを持つGPUが登場したことで、直接液冷(Direct-to-Chip Cooling, D2C)は選択肢ではなく必須要件となりました。液体の高い比熱容量と熱伝導率を活かし、発生熱の最大98%を捕捉する技術が、AIインフラの限界を押し広げています。

市場規模も急拡大しており、データセンター液冷市場は今後10年で数倍規模に成長する見通しです。PUEの大幅改善、エネルギーコスト削減、廃熱再利用、そしてESG対応まで、D2Cは経営判断に直結するテーマになっています。本記事では、市場データ、GPU仕様、TCO比較、日本市場の動向までを体系的に整理し、意思決定に役立つ視点を提供します。

空冷の限界とデータセンター冷却のパラダイムシフト

2026年のデータセンター業界では、空冷の限界がいよいよ明確になっています。従来は1ラックあたり15〜20kW程度が実質的な上限とされてきましたが、AI向け最新GPUを搭載したラックでは60kW、さらに100kWを超える設計も珍しくありません。

特にNVIDIAのBlackwell UltraやAMDのInstinct MI350シリーズは、1チップあたり最大1,400W級の熱設計電力(TDP)を持ちます。こうした超高密度環境では、従来型のCRACや大型空調機だけで安定運用することは事実上困難です。

冷却はもはや付帯設備ではなく、演算能力の上限を決める戦略インフラへと変質しています。

| 項目 | 従来空冷 | 高密度AIラック |

|---|---|---|

| ラック当たり電力 | 15〜20kW | 60〜150kW |

| 主な冷却手法 | 空調・ホット/コールドアイル | 直接液冷(D2C)併用 |

| GPU搭載枚数 | 〜64枚程度 | 〜128枚(液冷前提) |

空気の比熱容量や熱伝導率は物理的に限界があります。IDTechExの分析によれば、液体は空気と比べて比熱容量で約4倍、熱伝導率で約25倍高く、同じ体積でも圧倒的に多くの熱を運ぶことができます。この物性差が、冷却方式のパラダイムシフトを後押ししています。

さらに問題となるのが電力効率です。空冷中心の施設ではPUEが1.4〜1.8にとどまるケースが多い一方、液冷を前提とした設計では1.1前後、条件によっては1.05台も視野に入ります。冷却エネルギーだけで30〜50%削減可能とする分析もあり、AIクラスタが増設されるほど差は拡大します。

つまり、空冷の限界は単なる温度管理の問題ではありません。演算密度、設置面積、電力契約容量、そしてESG評価までを左右する経営課題になっています。

市場動向もそれを裏付けています。各種調査によれば、データセンター向け液冷市場は年率18%前後で拡大しており、2030年代前半には数百億ドル規模に達すると予測されています。ハイパースケーラーがAI投資を加速する中で、液冷は「選択肢」ではなく「前提条件」として扱われ始めています。

結果として、データセンター設計の思想そのものが変わりました。空気の流れを最適化する建築中心の発想から、チップ直上で熱を回収するマイクロレベルの熱管理へと重心が移っています。ここに、冷却のパラダイムシフトの本質があります。

直接液冷(D2C)とは何か──仕組みと基本アーキテクチャ

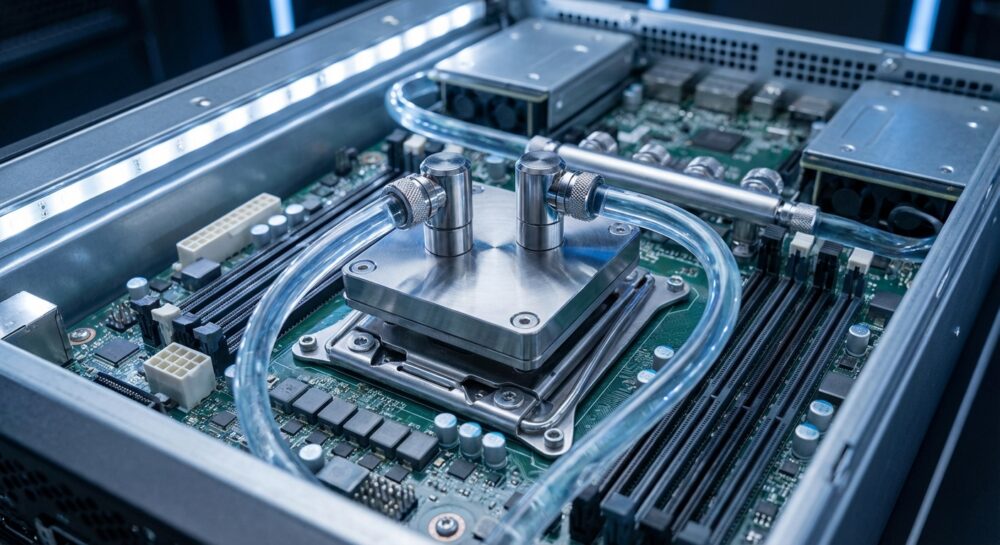

直接液冷(Direct-to-Chip Cooling:D2C)とは、CPUやGPUといった発熱源そのものに液体を直接接触させて冷却する方式です。従来の空冷のようにサーバー筐体内の空気を冷やすのではなく、チップ上に装着したコールドプレートに冷却液を循環させ、発生した熱を即座に吸収・搬送します。

液体は空気に比べて比熱容量が約4倍、熱伝導率が約25倍高いとされており、IDTechExの分析でも、この物理特性が高密度化時代の冷却基盤を支えていると指摘されています。その結果、1,000Wを超える最新GPUでも安定した温度制御が可能になります。

基本アーキテクチャは、次の4層構造で理解すると整理しやすくなります。

| 構成要素 | 役割 | 設置レイヤー |

|---|---|---|

| コールドプレート | チップ上で熱を直接吸収 | サーバーボード上 |

| マニホールド | 各ノードへ冷却液を分配 | ラック内 |

| CDU(冷却剤分配ユニット) | 温度・流量・圧力を制御 | ラック内または列間 |

| 二次側熱交換器 | 施設側水系へ熱を移送 | 設備フロア |

コールドプレート内部にはマイクロチャネルと呼ばれる微細流路が形成され、ホットスポット直上で熱を奪います。Supermicroなどの実装例では、サーバー発熱の最大98%を液体側で捕捉できると報告されています。これにより、ラック背面に放出される熱風は最小限に抑えられます。

CDUはシステムの中枢です。流量制御ポンプ、熱交換器、センサー群を備え、ラックごとに数十kWから100kW超の熱負荷を安定的に処理します。NVIDIA Blackwell Ultra世代のように1,400W級GPUを多数搭載する構成では、CDUの冗長設計が前提になります。

D2Cの本質は「空間を冷やす」のではなく「発熱点を制御する」ことにあります。そのため、空調設備全体を増強するのではなく、ラック単位で段階的に導入できるのが特徴です。

冷却方式は主に単相式と二相式に分かれます。単相式は水やグリコール水溶液を循環させる方式で、2025年時点で約70%の市場シェアを占めています。一方、二相式はチップ表面で冷媒を沸騰させ、相変化の潜熱で熱を奪います。

Open Compute Projectのホワイトペーパーによれば、二相式は等温沸騰により極めて高い熱流束に対応できますが、設計や冷媒管理の専門性が求められます。単相式は既存設備との統合が容易で、現時点では主流アーキテクチャとなっています。

また、D2Cは空冷と完全に置き換わるわけではありません。メモリや電源系統など一部は補助的に空冷を併用する「ハイブリッド構成」が一般的です。この役割分担設計こそが、現在のデータセンター標準アーキテクチャを形作っています。

結果としてD2Cは、ラックあたり60kW〜140kW級の高密度実装を可能にする基盤技術へと進化しました。直接液冷とは単なる冷却手法ではなく、高性能計算を成立させるためのインフラ設計思想そのものなのです。

市場規模と成長率から読む液冷市場の現在地

液冷市場の現在地を読み解くうえで重要なのは、単なる拡大トレンドではなく、複数の調査機関が一致して二桁成長を予測しているという点です。AIインフラ需要の爆発的増加を背景に、直接液冷(D2C)は実証段階を超え、本格的な成長フェーズに入りました。

市場調査会社Precedence Researchによれば、直接液冷市場は2025年に約25.3億ドル規模、2026年には約30.2億ドルへ拡大すると予測されています。2034年には127億ドル規模に達し、年平均成長率(CAGR)は約19.7%と見込まれています。

一方、データセンター液冷市場全体で見ると、さらに大きな構造変化が起きています。

| 区分 | 2025年 | 2035年予測 | CAGR |

|---|---|---|---|

| 直接液冷(D2C) | 約25.3億ドル | 約127.6億ドル(2034年) | 約19.7% |

| データセンター液冷全体 | 約48.0億ドル | 約271.0億ドル | 約18.2% |

特筆すべきは、液冷全体が2035年に約271億ドル規模へ到達するという予測です。これは冷却が補助設備から「戦略投資領域」へと格上げされたことを意味します。GMI Insightsの分析でも、ハイパースケーラーによるAIクラスタ投資が市場拡大の主因と指摘されています。

地域別に見ると、北米が2025年時点で世界シェアの37〜40%超を占めています。米国単体でも、2034年には約60億ドル規模に拡大する見通しです。一方で、最も高い成長率を示しているのはアジア太平洋地域です。高密度化と不動産コスト圧力が、液冷導入を加速させています。

エンドユーザー別では、通信分野が約32.2%のシェアを持ち、5Gインフラの高度化が需要を押し上げています。さらにエンタープライズ分野も約49%を占め、AI活用の内製化が市場を底支えしています。

また、市場内部でも構成要素の重心が変化しています。CPU冷却が約34.7%のシェアを維持する一方で、HBMなどメモリ冷却セグメントが急拡大しています。これはAIワークロードにおけるメモリ帯域の重要性が高まっていることを示す明確なシグナルです。

市場規模と成長率を総合的に見ると、2026年は液冷が「導入検討段階」から「標準アーキテクチャ段階」へ移行した転換点と位置付けられます。成長率の高さだけでなく、導入主体がハイパースケーラーからエンタープライズへ広がっている点が、現在地を示す最大の指標といえるでしょう。

北米・APAC・日本の地域別動向と投資トレンド

直接液冷の普及は、地域ごとに異なる電力事情、規制環境、投資主体の戦略によって様相が大きく異なります。2026年時点では、北米が市場規模で先行し、APACが成長率で追随し、日本が制度ドリブンで加速するという三極構造が鮮明です。

| 地域 | 市場特性 | 投資ドライバー |

|---|---|---|

| 北米 | 世界シェア37〜40%以上 | ハイパースケーラーのAIクラスタ拡張 |

| APAC | 最高成長率 | 高密度化・不動産制約・製造基盤 |

| 日本 | 政策支援が加速要因 | 補助金・省エネ規制・都市近接需要 |

北米では、米国を中心に大規模AIデータセンターへの資本投下が続いています。市場調査によれば、北米は2025年時点で世界市場の約4割を占めています。特にNVIDIA Blackwell Ultra世代を前提とした140kW級ラック対応施設への刷新が進み、液冷は新設案件の標準仕様になりつつあります。Brookings Institutionも、米国のデータセンター電力需要の急増がインフラ投資を加速させていると指摘しています。

APACでは、中国、シンガポール、日本、インドを含む広域でハイパースケール投資が活発です。Precedence Researchの分析では、APACは最も高いCAGRを示しています。都市部の不動産コストが高い市場では、ラック密度向上=競争力という構図が明確で、液冷による床面積あたり演算性能の最大化が投資判断を後押ししています。また、半導体およびサーバー製造のエコシステムが域内に存在することも、導入スピードを高める要因です。

日本市場は規模では北米に及びませんが、制度と立地特性が強い推進力となっています。2026年初頭に報じられた再エネ活用データセンターへの最大50%補助、総額約2,100億円規模の支援策は、液冷を含む高効率設備の導入を実質的に後押しします。改正省エネ法への対応もあり、PUE改善は単なるコスト問題ではなく経営課題になっています。

投資トレンドを見ると、北米は「超大規模AIクラスタへの集中投資」、APACは「高密度化と都市型展開」、日本は「補助金活用型の高度化投資」という色分けが可能です。さらに、ESG投資の拡大により、PUE1.1未満や水使用量削減を実現する液冷案件は資金調達面でも優位に立ちやすくなっています。

今後は、北米のメガキャンパス型、APACの高層・都市近接型、日本の耐震・高効率特化型というモデルが並存しながら、それぞれの地域特性に適応した液冷インフラが形成されていく見通しです。

NVIDIA Blackwell UltraとAMD MI350が突きつける1,400W時代の現実

NVIDIA Blackwell Ultra B300とAMD Instinct MI350シリーズの登場は、データセンターに「1,400W時代」という新たな現実を突きつけました。単一GPUで1,400Wという熱設計電力(TDP)は、もはや従来型の空冷インフラでは物理的に扱えない水準です。

実際、H100の700WからB200の1,000W、そしてB300の1,400Wへと電力は段階的に引き上げられてきました。AMDもMI355Xで同じく1,400Wに到達しており、これは一過性の競争ではなく、業界全体のトレンドであることを示しています。

主要スペックを整理すると、両社の方向性がより明確になります。

| 項目 | NVIDIA B300 | AMD MI355X |

|---|---|---|

| TDP | 1,400W | 1,400W |

| メモリ | 288GB HBM3e | 288GB HBM3e |

| メモリ帯域 | 8.0TB/s | 8.0TB/s |

| 製造プロセス | 4nm | 3nm |

演算性能の飛躍と同時に、メモリ容量と帯域も極端に拡大しています。HBMの高密度化は発熱源の集中を招き、冷却対象はGPUダイだけでなくメモリスタックへと広がっています。市場調査やベンダー資料によれば、最新世代ではメモリ冷却の重要性が急速に高まっています。

問題はラック単位での影響です。1枚1,400WのGPUを多数搭載すれば、単一ラックで100kW超は現実的な数字になります。実際、次世代クラスタでは最大140kW級の液冷能力が求められるケースも報告されています。従来の15~20kW想定の空冷設計とは前提がまったく異なります。

さらに見逃せないのは、電力と発熱が直線的にコストへ跳ね返る点です。1,400WのGPUを数千枚規模で運用すれば、IT負荷だけで数メガワットに達します。冷却効率がわずかに悪化するだけで、年間電力コストは数億円単位で変動します。

このため、**1,400W時代の本質は「GPU選定」ではなく「冷却前提のアーキテクチャ設計」**にあります。チップ仕様の比較だけでは不十分で、CDU容量、配管設計、ラック当たりの電力供給能力まで含めた統合判断が不可欠です。

2026年時点で明らかなのは、NVIDIAとAMDの競争が性能指標だけでなく、データセンターの電力密度・冷却戦略・投資計画そのものを再定義しているという事実です。1,400Wという数字は、半導体の進化の象徴であると同時に、インフラの限界を可視化する警告でもあります。

ラックあたり100kW超時代の設計要件とGPU搭載密度の変化

AIアクセラレータの消費電力が1チップあたり1,000Wを超える時代に入り、ラック設計の前提条件は根本から書き換えられています。従来は15〜20kWが上限とされていたラック電力密度は、2026年には60kWを標準レンジとし、ハイエンド構成では100kW、さらには140kW級へと到達しています。

特にNVIDIA Blackwell Ultra B300やAMD Instinct MI355Xのように最大1,400WのTDPを持つGPUが登場したことで、空冷前提の設計は現実的ではなくなりました。単体GPUの発熱量が増えただけでなく、HBM3eを288GB搭載する構成により、メモリ周辺の熱密度も急激に上昇しているためです。

たとえば、最新世代GPUを多数搭載するラックでは、構成によって必要冷却能力が大きく変わります。

| 項目 | 空冷ラック(従来) | 液冷ラック(AI特化) |

|---|---|---|

| 想定電力密度 | 7〜20kW | 60〜140kW |

| GPU搭載枚数 | 最大64枚程度 | 最大128枚規模 |

| 主冷却方式 | CRAC/CRAH | Direct-to-Chip液冷 |

液冷では発生熱の最大98%を液体で捕捉できる実装例も報告されており、サーバー背面への排熱を大幅に抑制できます。これにより、ラック単位でのGPU搭載密度を倍増させる設計が可能になりました。

設計要件も従来とは大きく異なります。第一に、ラック単体での給排水インターフェース設計が必須となり、CDUとの接続、流量制御、圧力監視が標準仕様になります。第二に、床荷重への配慮です。液体、配管、CDUを含めた総重量は増加するため、建築構造と一体での設計が求められます。

さらに重要なのが電源設計です。100kW超ラックでは、冗長化された高容量PDUやバスバー給電が前提となり、ラック単位で小規模変電所に近い扱いになります。これは単なる冷却問題ではなく、電力・構造・ネットワークを統合したインフラ設計へと進化していることを意味します。

IDTechExの分析が示すように、液冷は単なる効率化手段ではなく、演算密度を引き上げるための構造的要件です。GPU搭載密度の向上は、同一床面積あたりの演算能力を飛躍的に高め、都市部や不動産コストの高い地域において競争優位を左右します。

結果として、ラック設計は「何枚GPUを載せるか」ではなく、「何kWを安全かつ持続的に処理できるか」という問いへと転換しました。100kW超時代の設計思想は、もはや空間効率ではなく、熱と電力の制御能力そのものが競争力を決定づけるフェーズに入っています。

コールドプレート、CDU、マニホールド──D2Cの主要コンポーネント解説

直接液冷(D2C)の性能と信頼性を左右するのが、コールドプレート、CDU(冷却剤分配ユニット)、そしてマニホールドです。これらは単なる配管部品ではなく、1,400W級GPU時代の熱設計を成立させる中核インフラです。

| コンポーネント | 主な役割 | 設計上の要点(2026年) |

|---|---|---|

| コールドプレート | CPU/GPUからの直接吸熱 | マイクロチャネル化、TIM最適化 |

| CDU | 温度・圧力・流量の統合制御 | 冗長ポンプ、リアルタイム監視 |

| マニホールド | ラック内の冷却剤分配 | 均圧設計、ノンドリップQD |

コールドプレートは、発熱源に最も近い「熱の玄関口」です。2026年の主流は微細流路(マイクロチャネル)構造で、液体の接触面積を最大化しながら圧力損失を抑えます。IDTechExによれば、液体は空気に比べて圧倒的に高い熱伝導特性を持ち、この物理優位性を最大化する設計が鍵になります。特に1,400W級のBlackwell UltraやMI355Xでは、ホットスポットを局所的に冷やし切れるかどうかが安定動作の分水嶺になります。チップとプレート間のTIM選定も熱抵抗を左右する重要要素です。

CDUはシステム全体の心臓部です。冷却水の温度、圧力、流量を精密制御し、異常を検知すれば即座に遮断します。Schneider Electricの技術解説でも指摘されている通り、2026年モデルはポンプや熱交換器を冗長化し、ラック単位での高可用性を前提に設計されています。インロー型ではメガワット級クラスタを支える能力が求められ、AIワークロードの急激な負荷変動に追従する制御アルゴリズムも進化しています。

マニホールドは、各サーバーへ均等に冷却剤を供給する配分装置です。流量の偏りは温度ムラや性能低下を招くため、内部流路の均圧設計が不可欠です。Research and Marketsの市場分析でも、ノンドリップ型クイックコネクタの標準化が保守性向上の鍵とされています。ホットスワップ時でも液だれを防ぎ、人的リスクを最小化します。

重要なのは、これら3要素が個別最適ではなく統合設計されている点です。コールドプレートの圧力損失はCDUのポンプ能力に影響し、マニホールド設計は全体のΔPバランスを決定します。**D2Cの競争力は、部品単体ではなくシステム全体の流体設計思想で決まります。**

結果として、熱捕捉率は最大98%に達し、ラックあたり100kW超の環境でも安定運用が可能になります。AI時代のインフラ競争は、GPU性能だけでなく、これら主要コンポーネントの完成度に大きく依存しているのです。

単相式と二相式の比較──効率・安全性・施設要件の違い

直接液冷における単相式と二相式の違いは、単なる方式の差ではなく、効率・安全性・施設設計思想そのものを左右する分岐点です。2026年現在、市場シェアでは単相式が約70%を占める一方で、二相式は高密度AI用途を中心に導入が進んでいます。

| 比較項目 | 単相式 | 二相式(P2P) |

|---|---|---|

| 熱輸送原理 | 液体の顕熱 | 蒸発潜熱(相変化) |

| 主な冷却剤 | 水+グリコール | 誘電性冷媒(例:R-515B) |

| 市場動向 | 主流(約70%) | 高成長(CAGR約19%) |

| 施設統合性 | 既存設備と親和性高い | 専用設計が前提 |

効率面では、二相式が理論的に優位です。Open Compute Projectのホワイトペーパーによれば、相変化時の潜熱を活用することで、チップ表面温度を飽和温度付近に安定させられ、2kW級の超高TDPプロセッサにも対応可能とされています。等温沸騰によりホットスポットを抑制できる点は、将来世代GPUを見据えると大きな強みです。

一方、単相式もIDTechExの分析が示す通り、顕熱ベースでありながら高効率を実現しており、コールドプレート方式では発生熱の最大98%を液体で捕捉できる事例も報告されています。ラック単位での140kW級対応が進む現在、実用レベルでの効率差は「理論値」よりも「設計・運用完成度」に左右される傾向があります。

安全性の観点では構図が逆転します。単相式は水系冷却液を使用するため、漏えい時に電子機器へ損傷リスクがあります。そのため、リークセンサーや自動遮断機構が標準装備されています。対して二相式は誘電性冷媒を使用し、漏れても蒸発し残留物を残さない特性があります。電子機器保護という観点では二相式が構造的に有利です。

施設要件では単相式が導入しやすい選択肢です。既存空冷データセンターに段階的導入が可能で、CDUを列単位で追加することで対応できます。Research and Marketsの市場分析でも、既存インフラとの統合容易性が単相式普及の主因と指摘されています。

対照的に二相式は、冷媒管理や圧力設計を前提とした専用配管設計が求められます。設備設計段階から組み込む必要があり、グリーンフィールド型施設との親和性が高い方式です。

2026年時点では、1,400W級GPUが主流化する中でも単相式が市場をリードしていますが、2kW超世代が現実味を帯びる2030年前後には、二相式の比率がさらに上昇する可能性があります。冷却方式の選定は、単なる技術比較ではなく、将来の電力密度ロードマップをどう描くかという経営判断そのものです。

PUE1.1未満は可能か?エネルギー効率とOPEX削減効果

AI向け高密度ラックの普及により、データセンター運営者にとって最大の関心事の一つがPUE1.1未満の実現可能性です。結論から言えば、直接液冷(D2C)を前提とした設計であれば、PUE1.05前後は十分に射程圏内に入っています。

一般的な空冷データセンターの平均PUEは1.4〜1.8とされ、冷却エネルギーが全体消費電力の大きな割合を占めてきました。一方、液冷システムでは1.05〜1.15という水準が報告されており、部分的なpPUEでは1.02〜1.20に達する事例もあります。IDTechExや各種市場レポートが示す通り、冷却方式の転換は構造的な効率改善をもたらしています。

| 冷却方式 | 一般的なPUE | 冷却エネルギー削減効果 |

|---|---|---|

| 空冷 | 1.4〜1.8 | 基準 |

| 直接液冷(D2C) | 1.05〜1.15 | 約30〜50%削減 |

PUE1.1未満を実現できる背景には、コールドプレートによる最大98%の熱捕捉率があります。発熱源であるCPUやGPUから直接熱を回収するため、サーバー背面への熱放出が大幅に減少し、CRACやチラーの負荷を抜本的に低減できます。特に1,400W級GPUを多数搭載するラック環境では、この差が顕著に表れます。

OPEX削減効果は電力コストに直結します。例えば10MW規模の施設でPUEが1.5から1.1へ改善した場合、同一IT負荷でも年間数百万kWh単位の削減が生じます。Equinixなどの分析によれば、サイト全体で約25〜30%のエネルギー削減が可能とされ、これは電力単価次第で数億円規模のコスト差となります。

さらに、温水冷却設計を採用すればドライクーラー中心の閉ループ運用が可能となり、水使用量を抑制できます。冷却塔依存を減らすことで、水コストや水処理費用、さらには水資源リスクへのエクスポージャーも低減します。

重要なのは、PUE1.1未満は単一機器の性能ではなく、CDU制御、流量最適化、AIによる動的熱管理まで含めた統合設計の成果であるという点です。適切な設計と運用が前提であれば、直接液冷はエネルギー効率とOPEX削減の両立を現実的な経営戦略へと押し上げる技術と言えます。

10年間TCOで見るD2Cの経済合理性と浸漬冷却との比較

AIクラスタの超高密度化が進む中、冷却方式の選択は設備仕様の問題ではなく、10年間の総所有コスト(TCO)を左右する経営判断になっています。初期投資だけを見ると液冷、とりわけD2Cは高価に見えますが、長期スパンでの電力費・設置面積・改修費まで含めると評価は大きく変わります。

IDTechExの2026年レポートによれば、10年間のTCO比較においてD2Cは単相浸漬冷却より平均13.0%、二相浸漬冷却より平均9.4%低い水準になると分析されています。差を生むのは、エネルギー効率だけでなく、既存施設との統合コストです。

| 比較項目 | D2C | 浸漬冷却 |

|---|---|---|

| 10年TCO(相対) | 基準(低い) | +9〜13%高い |

| 既存DC活用 | ラック単位で段階導入可 | 大規模改修が必要 |

| PUE水準 | 1.05〜1.15 | 約1.01 |

| 床荷重・構造 | 既存仕様で対応しやすい | 液槽重量への補強が必要 |

確かに浸漬冷却はpPUE1.01と極めて高効率です。しかし、サーバーボード設計の変更、誘電性流体の管理、液槽重量に対応する床補強など、導入時のCAPEXが大きくなります。既存の空冷データセンターを活かしながらAIラックだけを高密度化できるD2Cは、段階的投資が可能で資本効率が高い点が強みです。

さらに、ラックあたり最大140kW級の設計が求められるBlackwell Ultra世代では、液冷ラックに128基のGPUを搭載できる構成も報告されています。空冷で64基が限界とされる構成と比較すると、同一床面積あたりの演算性能は理論上2倍です。不動産コストが高騰する都市部では、この差が10年累計で巨額の差になります。

運用面でも差は明確です。空冷比で25〜30%のサイト全体電力削減が可能とする分析もあり、冷却電力単体では最大50%削減が見込まれています。電力単価上昇や炭素価格導入を前提にすると、OPEX削減効果は年々拡大します。

一方で、浸漬冷却は非導電性流体を用いるため漏えいリスクが低く、超高密度用途では魅力があります。ただし流体の更新や廃棄コスト、規制対応(PFAS動向など)を含めたライフサイクル管理が必要です。財務モデルにこれらの変動要素を織り込むと、総合的なリスク調整後TCOではD2Cが優位と評価されるケースが増えています。

結論として、10年間という経営視点で見ると、D2Cは「最高効率」ではなく「最適バランス」の解です。既存資産を活かしながら高密度化と省エネを両立できる点こそが、2026年時点で多くのハイパースケーラーがD2Cを標準採用している経済的合理性の核心です。

漏えいリスク、化学管理、保守体制──導入時の実務課題

直接液冷の導入は性能面で大きな優位性をもたらしますが、実務の現場では「漏えいリスク」「化学管理」「保守体制」という三つの課題に正面から向き合う必要があります。とりわけ単相式D2Cでは水系冷却液を扱うため、設計段階から運用フェーズまで一貫したリスク管理が不可欠です。

漏えいは確率の問題ではなく、影響度の問題として設計する必要があります。単相式では万一の漏えいが電子機器に重大な損傷を与える可能性があるため、多層防御が前提になります。業界ホワイトペーパーや主要ベンダー資料によれば、2026年時点の主流構成は以下の通りです。

| 対策領域 | 主な実装内容 | 実務上のポイント |

|---|---|---|

| 検知 | ラック/ノード単位の水分センサー | 誤検知低減と即時アラート連携 |

| 遮断 | 自動遮断弁・CDU連動停止 | 部分停止で被害を局所化 |

| 接続 | ノンドリップ型クイックコネクタ | 保守時の人的ミス抑制 |

| 監視 | 圧力・流量の常時モニタリング | 微差から予兆検知 |

とくにCDUによる圧力・流量の連続監視は、わずかな変動からリークの兆候を捉える予防的保全の中核です。Open Compute Projectの技術文書でも、二相式は誘電性冷媒により漏えい時の機器損傷リスクが低いとされますが、その分専門的な設計・施工体制が求められます。

次に見落とされがちなのが化学管理です。水ベース冷却では腐食抑制剤や殺生物剤の添加、定期的な水質分析が不可欠です。Research and Marketsの市場分析でも、冷却液の長期安定性と部材互換性がライフサイクルコストを左右すると指摘されています。

配管材質、ポンプ、シール材との相性が不十分な場合、数年単位で腐食やスラッジ発生が進行し、流量低下や熱交換効率の悪化を招きます。導入時には「初期性能」だけでなく、5年後・10年後の化学的安定性まで契約仕様に織り込む視点が重要です。

さらに、保守体制の再設計も避けて通れません。従来の空冷中心のオペレーションから、配管系統・CDU・水質管理を含む設備工学的スキルへの拡張が求められます。AIクラスタでは1ラックあたり100kW級に達するケースもあり、保守作業の停止時間はそのまま巨額の機会損失に直結します。

そのため先進的な事業者では、IT部門とファシリティ部門の統合運用、24時間遠隔監視、予知保全アルゴリズムの導入を進めています。冷却はもはや裏方設備ではなく、演算インフラの一部です。漏えい対策、化学的健全性、保守オペレーションを一体で設計できるかどうかが、直接液冷導入の成否を分けます。

水使用量削減と廃熱再利用──サステナビリティ経営との接点

AI時代のデータセンター経営において、水使用量と廃熱の扱いはコスト問題にとどまらず、企業価値を左右するサステナビリティ指標になっています。直接液冷(D2C)は、PUE改善だけでなく、WUE(水使用効率)と熱資源化の両面で経営インパクトを持つ技術として再評価されています。

従来の空冷型データセンターでは、蒸発冷却を伴う冷却塔が大量の水を消費します。米国ではデータセンターによる水消費が2030年までに大幅増加すると予測されており、地域社会との摩擦や操業制限リスクが顕在化しています。こうした背景のもと、水を蒸発させない閉ループ型の液冷設計は、規制対応とレピュテーション管理の両面で重要性を増しています。

| 項目 | 空冷(蒸発冷却) | 直接液冷(温水・閉ループ) |

|---|---|---|

| 主な放熱方式 | 冷却塔による蒸発 | ドライクーラー |

| 水使用量 | 高い | 極めて低い(補充水ほぼ不要) |

| 外気条件の影響 | 高温多湿で効率低下 | 影響を受けにくい |

IDTechExや各種市場分析によれば、液冷はPUE1.05~1.15の達成が可能とされ、エネルギー削減効果は25~30%に及ぶケースもあります。ここで見落とされがちなのが、水と電力のトレードオフです。蒸発冷却は電力効率を改善する一方で水消費を増大させますが、温水対応のD2Cはその構造的ジレンマを回避できます。

直接液冷では戻り水温が高く、地域暖房や給湯、温室栽培などへの再利用が現実的になります。欧州ではデータセンター廃熱を地域暖房網に接続する事例が拡大しており、廃熱を販売可能なエネルギーとして扱うビジネスモデルも登場しています。これはScope3排出量削減にも寄与し、ESG評価の向上につながります。

さらに、改正省エネ法への対応や、再エネ活用型データセンターへの補助制度など政策的後押しも強まっています。設備投資の最大50%補助が検討されているとの報道もあり、省エネ型冷却インフラへの転換は財務合理性を帯び始めています。

水使用量削減と廃熱再利用は、単なる環境配慮ではなく、資本コスト低減・規制リスク回避・新規収益創出を同時に実現する経営戦略です。直接液冷は、その実装手段として、2026年のサステナビリティ経営の中核技術に位置づけられています。

日本市場の最新動向──印西・大阪の事例と政府補助の影響

2026年の日本市場では、直接液冷は「先進的な選択肢」から「AI対応の前提条件」へと位置づけが変わりつつあります。特に千葉県印西市と大阪エリアは、国内における高密度データセンター集積地として、液冷導入の最前線に立っています。

印西エリアでは、MCデジタル・リアルティのNRT10やNRT12といった大規模施設が稼働し、生成AI用途を見据えた高密度対応を強化しています。公表情報によれば、NRT12は大規模AI計算基盤への採用実績を持ち、ラック当たり数十kWを超える負荷に対応可能な設計が進められています。

日本の高温多湿な気候条件では、夏季に外気冷却効率が低下しやすいという課題があります。直接液冷はCPU・GPUから最大98%の熱を液体側で回収できるとされており、空調依存度を下げることでチラー負荷の安定化に寄与します。

| エリア | 特徴 | 液冷導入の意義 |

|---|---|---|

| 印西(千葉) | 大規模キャンパス型、ハイパースケール集積 | AIクラスタ向け高密度ラック対応 |

| 大阪 | 関西圏需要・BCP拠点 | 西日本分散配置と高効率運用の両立 |

大阪エリアでも、首都圏との分散配置ニーズやBCP観点から新設・増設が続いています。高密度化と電力制約が同時に進行するなか、液冷は「限られた受電容量で最大演算を引き出す手段」として評価されています。

この動きを加速させているのが政府支援です。2026年初頭には、再生可能エネルギー活用型データセンターに対し、設備投資額の最大50%を補助する制度が検討され、総額約2,100億円規模と報じられました。直接液冷のような高度省エネ技術も対象に含まれる見通しです。

改正省エネ法の下で、事業者にはエネルギー使用状況の報告と効率改善が求められています。PUEを1.1前後まで引き下げ得る液冷技術は、単なる設備更新ではなく、法規制対応とESG戦略を同時に満たす投資として再評価されています。

一方で、日本特有の論点も無視できません。地震リスクを踏まえた配管の耐震設計、漏えい時の自動遮断機構、床荷重制限への対応など、海外モデルの単純移植では不十分です。国内ベンダーは耐震架台や軽量マニホールド設計など、日本仕様への最適化を急いでいます。

印西・大阪という二大拠点で進む高密度化と、政府補助による資本コスト低減。この二つが交差することで、**直接液冷はコスト課題を超えた戦略インフラとして、日本市場に本格定着しつつあります。**

2030年に向けた進化予測──マイクロ流体冷却とAI制御の融合

2030年に向けて、直接液冷はさらに一段深いレイヤーへ進化しようとしています。鍵を握るのが、半導体内部に微細流路を組み込むマイクロ流体冷却と、AIによるリアルタイム制御の融合です。

従来のD2Cはコールドプレートをチップ上に密着させる方式ですが、IDTechExによれば、次世代研究ではシリコンダイ内部へ流路をエッチングし、冷却剤を直接流す構造が検討されています。これにより、シリコンと冷却媒体の間の熱抵抗を極小化し、2kW級を超える将来プロセッサへの対応が視野に入ります。

| 比較項目 | 現行D2C | マイクロ流体統合型 |

|---|---|---|

| 冷却位置 | チップ外部(コールドプレート) | チップ内部(微細流路) |

| 熱抵抗 | TIM依存 | 大幅低減が期待 |

| 想定TDP | 〜1.4kW級 | 2kW超を想定 |

一方で、冷却能力を最大化しても、それを最適に配分できなければ意味がありません。そこで重要になるのがAI制御です。AIRSYS North Americaが指摘するように、データセンター全体の温度、湿度、IT負荷、電力価格を統合解析し、CDUの流量や供給温度を動的に変化させる動きが加速しています。

2030年には「AIを冷却するAI」が標準化する可能性があります。GPU負荷の急激なスパイクを予測し、事前に流量を増やす予測制御や、ラック単位で最適なΔTを維持する自律分散制御が実装されれば、pPUEのさらなる低減が現実的になります。

この融合がもたらす最大の変化は、冷却が受動的インフラから「能動的制御システム」へ転換する点です。マイクロ流体によってチップ直下で発熱を捕捉し、AIが秒単位で流体条件を調整することで、演算密度とエネルギー効率の両立が可能になります。

結果として、2030年のデータセンターは、演算・冷却・制御が一体化したサイバーフィジカルシステムへと進化していきます。冷却はもはや裏方ではなく、AIインフラの性能上限を決める中核技術として、設計段階から半導体と同時に最適化される時代に入ろうとしています。

参考文献

- Global Market Insights:Data Center Liquid Cooling Market Size & Share Report, 2035

- IDTechEx:Thermal Management For Data Centers 2026-2036: Technologies, Markets and Forecasts

- CRN:AMD: Instinct MI350 GPUs Use Memory Edge To Best Nvidia’s Fastest AI Chips

- AMD:AMD Instinct™ MI350 Series GPUs

- Schneider Electric Blog:Rethinking data center cooling for AI: The rise of direct-to-chip liquid cooling

- Supermicro:What Is Direct-to-Chip Liquid Cooling?

- PR TIMES:MCデジタル・リアルティのNRT12データセンターが、Preferred Networks のAI計算基盤に採用