機械学習の世界は、その複雑なモデルや技術で数多くの課題解決を実現しています。この記事では、機械学習モデルの中核に位置するシグモイド関数、ソフトマックス関数、そしてロジスティック関数に焦点を当て、その基本から最新の研究までを解説します。

これらの関数がどのように動作し、どのような場面で使用されるのか、また、それぞれの関数が持つ利点や課題についても詳しく見ていきましょう。機械学習初心者からベテランまで、これらの活性化関数を深く理解することで、モデルの質をさらに向上させる手助けとなることを目指します。

はじめに: 機械学習における3つの主要な関数

近年、AIや機械学習が様々な業界での注目を浴びています。それらの技術の背後には、多くの数学的な関数が存在しており、特にシグモイド関数、ソフトマックス関数、ロジスティック関数は、多くのモデルで活性化関数や確率を出力するための関数として使用されています。これらの関数は、ニューラルネットワークの基盤となる要素であり、正確な予測や分類を行うためのキーとなります。

この記事では、これら3つの関数が何であるか、それぞれの特性や使い道を詳しく解説していきます。これから機械学習を学ぶ方はもちろん、既に知識をお持ちの方も、さらなる理解を深めるための参考にしていただければと思います。

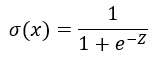

シグモイド関数とは

シグモイド関数は、機械学習やディープラーニングの世界で頻繁に遭遇する関数の一つです。特に、バイナリ分類の問題において、出力を0から1の間にスケーリングするために使用されます。

数式で表すと、シグモイド関数σ(z)は以下のようになります。

この関数の美しさは、どんな実数値の入力zも、0と1の間の値に変換する点にあります。これにより、確率的な出力として解釈することができるのです。

グラフで見ると、シグモイド関数は”S”の形をしており、入力の値が非常に大きいか小さい場合、出力はそれぞれ1または0に近づきます。しかし、入力が0に近い場合、出力は0.5近辺になります。

この特性が、機械学習のモデルにおいて、特にニューラルネットワークの活性化関数として非常に有用であることを意味しています。次のセクションでは、ロジスティック関数との関連性や、シグモイド関数の具体的な利用シーンについてさらに詳しく見ていきましょう。

ロジスティック関数の深掘り

ロジスティック関数は、多くの人が「シグモイド関数」として知っているものと本質的には同じです。この関数は、実数全体を取り、0から1の間の値にマッピングします。特に、バイナリ分類のタスクにおける出力層の活性化関数として一般的に利用されます。

数式で表すと、ロジスティック関数は以下のように表されます。

こちらは、先述のシグモイド関数の数式と同じです。ロジスティック回帰において、この関数は確率を予測するのに役立ちます。

ロジスティック関数の主な特点としては、その出力が確率として解釈されるため、バイナリ分類の問題の解を得ることができる点が挙げられます。具体的には、0.5以上の出力は「1」のクラス、0.5未満は「0」のクラスとして解釈されることが一般的です。

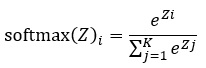

ソフトマックス関数の詳細

次に、ソフトマックス関数について見ていきましょう。この関数は、特に多クラス分類の問題において、各クラスに対する確率分布を出力するために使用されます。

ソフトマックス関数は、以下の数式によって定義されます。

ここで、zは入力ベクトル、Kはクラスの総数を表します。出力は、各クラスに対する確率として解釈されます。

ソフトマックス関数の主な利点は、出力の総和が1になることです。これにより、各クラスに所属する確率として出力を解釈することができます。ニューラルネットワークの多クラス分類タスクにおいて、出力層の活性化関数としてこのソフトマックス関数が頻繁に利用されます。

シグモイド関数 vs ソフトマックス関数: いつどれを使う?

シグモイド関数とソフトマックス関数は、ニューラルネットワークや機械学習モデルの構築において、頻繁に使用される活性化関数です。しかし、それぞれの関数が持つ特性や適用シーンは異なります。

シグモイド関数

- 用途: バイナリ分類の出力層や中間層の活性化関数として使用されます。

- 特性: 任意の実数を0から1の間に変換します。

- 使用例: メールがスパムかどうか、画像に猫が写っているかどうかなどの2クラス分類問題。

ソフトマックス関数

- 用途: 多クラス分類の出力層の活性化関数として使用されます。

- 特性: 各クラスの確率分布として解釈できる出力を生成します。

- 使用例: 手書きの数字の認識や、画像に写っている動物の種類の予測などの多クラス分類問題。

結論

シグモイド関数は、2クラス分類や中間層の活性化関数としての使用が推奨されます。一方、ソフトマックス関数は、3クラス以上の多クラス分類タスクの出力層に適しています。

勾配消失問題とこれらの関数

ニューラルネットワークの訓練中に遭遇する可能性がある主要な問題の一つが勾配消失問題です。シグモイド関数やソフトマックス関数を使用した場合、この問題に直面するリスクが高まります。

シグモイド関数の場合、入力の絶対値が大きくなると、出力の勾配が非常に小さくなります。これが原因で、逆伝播中に勾配が極端に小さくなり、ネットワークの重みの更新がほとんど行われなくなることがあります。結果として、学習が停滞することがあります。

この問題を克服するために、ReLU (Rectified Linear Unit) などの他の活性化関数が中間層で推奨されることが多いです。しかし、出力層においては、シグモイド関数やソフトマックス関数がその役割を果たす重要な場面も多く、これらの関数を適切に選択・利用することが重要です。

これらの関数の実際の応用例

シグモイド関数やソフトマックス関数は、日常のさまざまな技術やアプリケーションに応用されています。以下にその実際の応用例を挙げます。

Eメールフィルタリング

シグモイド関数を活用したモデルは、Eメールがスパムであるか否かを判定する際に役立てられます。このバイナリ分類タスクは、シグモイド関数の0から1の出力を確率として解釈する特性を活かす典型的な例です。

画像分類

ソフトマックス関数は、画像内のオブジェクトを多数のカテゴリーに分類するタスクに使用されます。例えば、CIFAR-10というデータセットを使った10クラスの画像分類問題などで、ソフトマックス関数の力を発揮します。

手書き文字認識

シグモイドやソフトマックス関数は、手書きの数字や文字を正確に識別するモデルの構築にも利用されています。

関数のパラメータ調整のヒント

シグモイド関数やソフトマックス関数をニューラルネットワークや機械学習モデルに適用する際、性能を最適化するためにはいくつかのパラメータ調整が必要です。以下は、それらの調整に関するヒントをいくつか示します。

学習率の調整

学習率はモデルの学習速度を調整する重要なパラメータです。学習率が高すぎるとモデルは収束しない可能性があり、低すぎると学習が遅くなる可能性があります。適切な学習率を見つけるための実験が必要です。

正則化

過学習を防ぐために、L1やL2正則化を導入することを検討してください。これにより、関数の適用がより効果的になる場合があります。

バッチサイズ

バッチサイズは、一度に処理されるデータの量を指します。小さなバッチサイズは、より頻繁なパラメータの更新を可能にしますが、大きなバッチサイズは一般的により安定した学習を提供します。

最適化手法との関連

ニューラルネットワークの訓練において、活性化関数だけでなく最適化手法も非常に重要な役割を果たします。シグモイド関数やソフトマックス関数の性能は、選択される最適化アルゴリズムによって大きく左右されることがあります。

勾配降下法

この基本的な最適化手法は、シグモイド関数やソフトマックス関数のような伝統的な活性化関数とよく合います。しかし、勾配消失問題に対処するための工夫が必要となる場合も。

AdamやRMSprop

これらの高度な最適化手法は、学習率の調整を動的に行うため、シグモイドやソフトマックスを使用したモデルの収束を加速させることが報告されています。

最適化手法の選択は、使用する活性化関数だけでなく、データセットやモデルの複雑さにも依存します。適切な組み合わせを見つけるための実験が不可欠です。

最新の研究: 新しい活性化関数の紹介

機械学習の分野は日々進化しており、新しい活性化関数の研究も盛んに行われています。

Swish

Googleが提案したこの新しい活性化関数は、特定のタスクでReLUやシグモイド関数よりも優れた性能を示しています。

Mish

Swishの変種として注目を浴びている活性化関数で、多くのモデルで高い精度を達成しています。

GELU (Gaussian Error Linear Units)

最近のTransformerベースのモデルでよく使用されている活性化関数で、深いネットワークでの学習を安定させる特性を持っています。

これらの新しい活性化関数は、シグモイド関数やソフトマックス関数とは異なる特性を持つため、特定の問題に対してさらに適切な解を提供する可能性があります。

まとめ: 機械学習モデルの選択とこれらの関数の役割

この記事を通して、シグモイド関数、ソフトマックス関数、そしてロジスティック関数などの機械学習における重要な活性化関数について深く探ることができました。これらの関数は、ニューラルネットワークやその他の機械学習モデルの性能に大きく影響を与える要素となっています。

関数の選択の重要性

各活性化関数は独自の特性と利点を持っています。問題の性質やデータセットに応じて、最も適した関数を選択することが求められます。

最新の研究と進化

機械学習の分野は日々進化しており、新しい活性化関数や最適化技術が継続的に開発されています。最新の技術を常に追いかけ、実際の問題解決に活かすことが重要です。

モデルの全体像

活性化関数はモデルの一部に過ぎません。モデルのアーキテクチャ、学習率、正則化など、多くの要素が組み合わさって最終的な性能を形成します。モデル設計時には、これらの要素を総合的に考慮する必要があります。

最後に、これらの活性化関数の理解と適切な適用は、高品質な機械学習モデルを構築するための基石となります。継続的な学びと実験を通じて、より良いモデルの構築を目指しましょう。